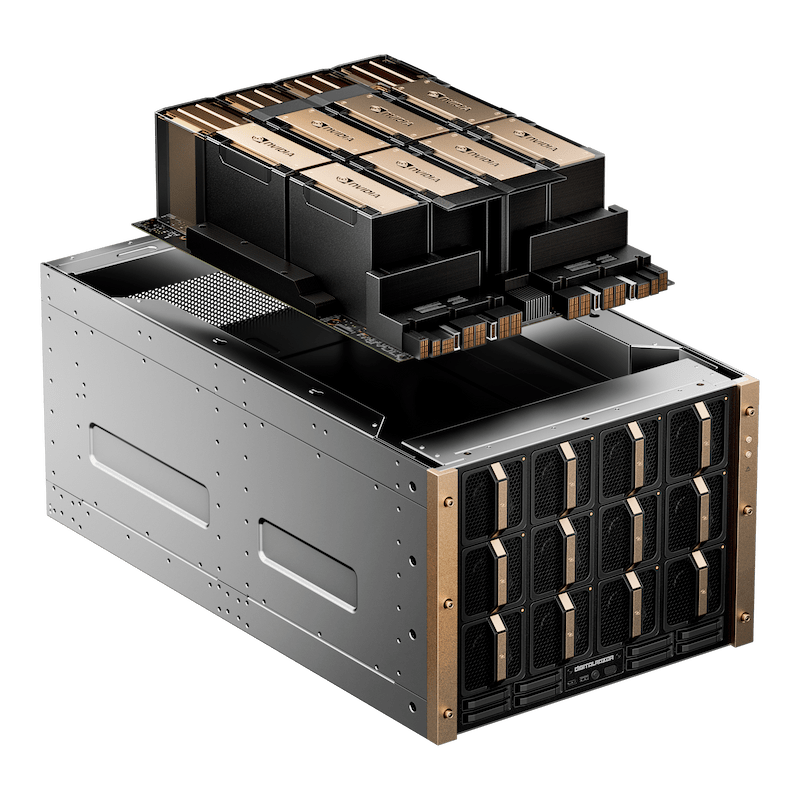

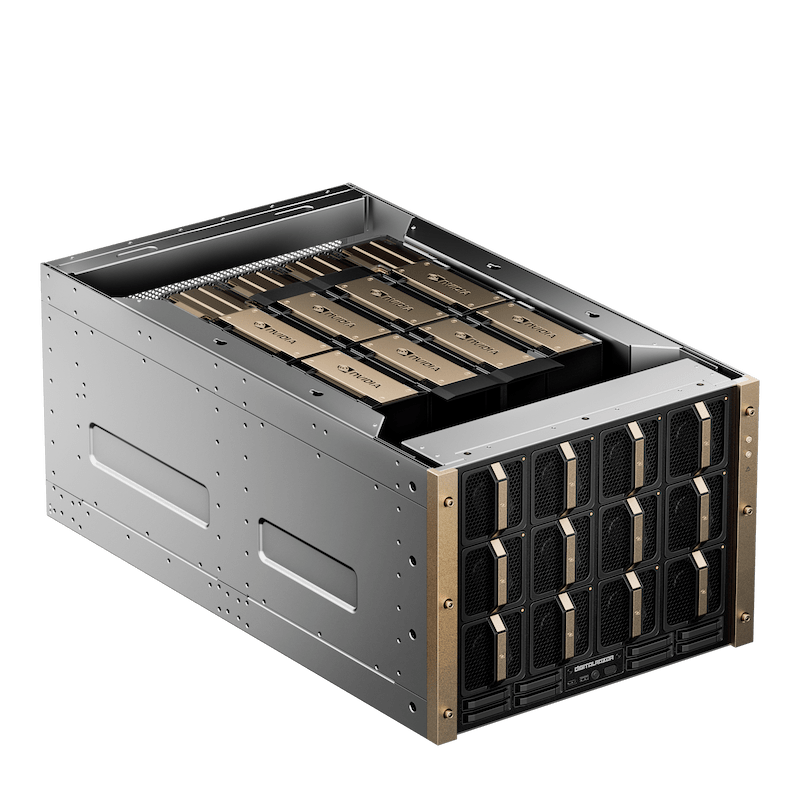

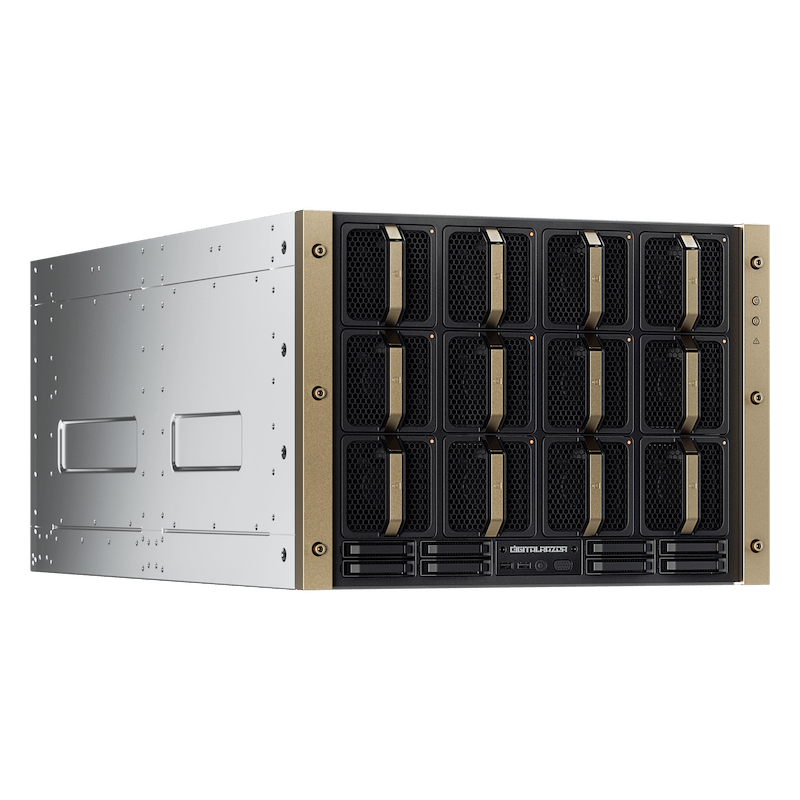

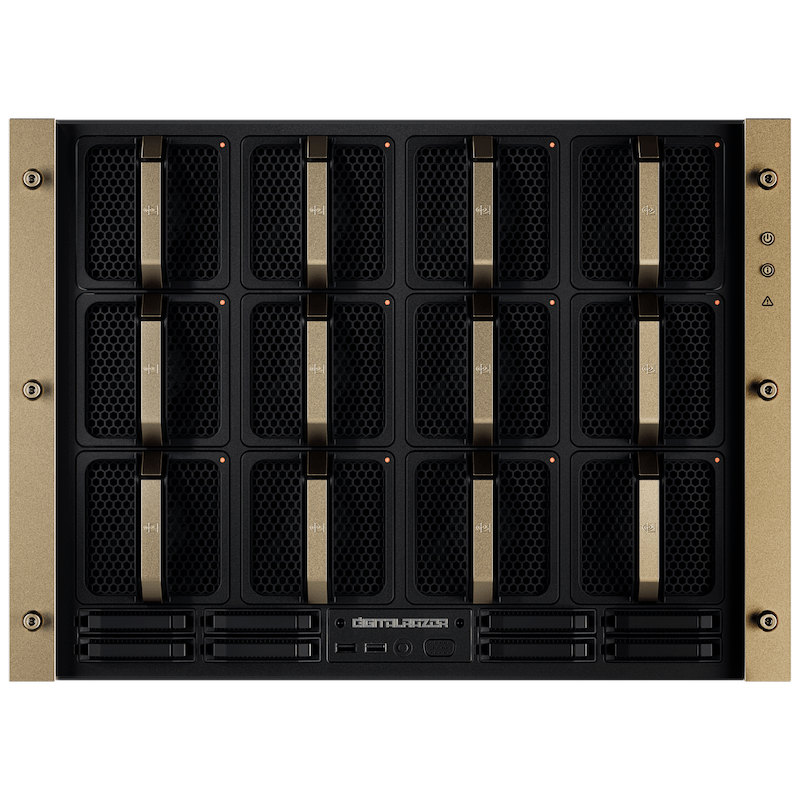

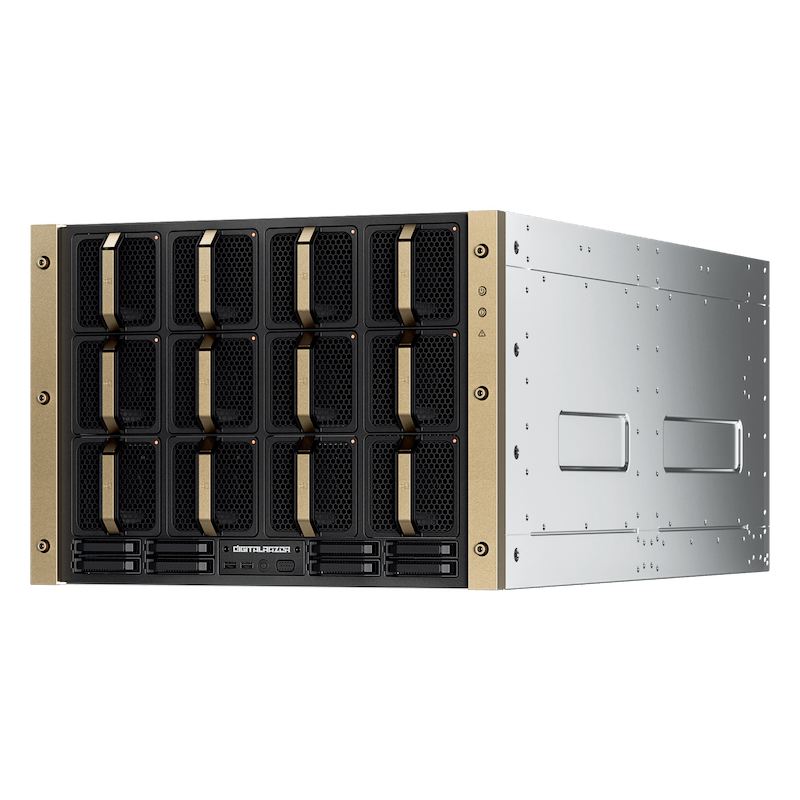

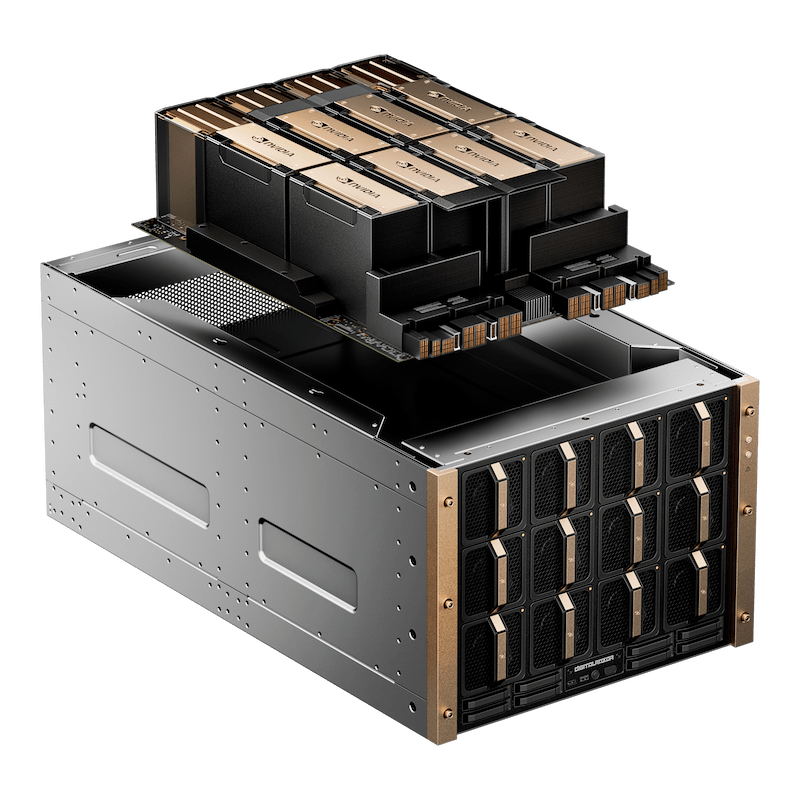

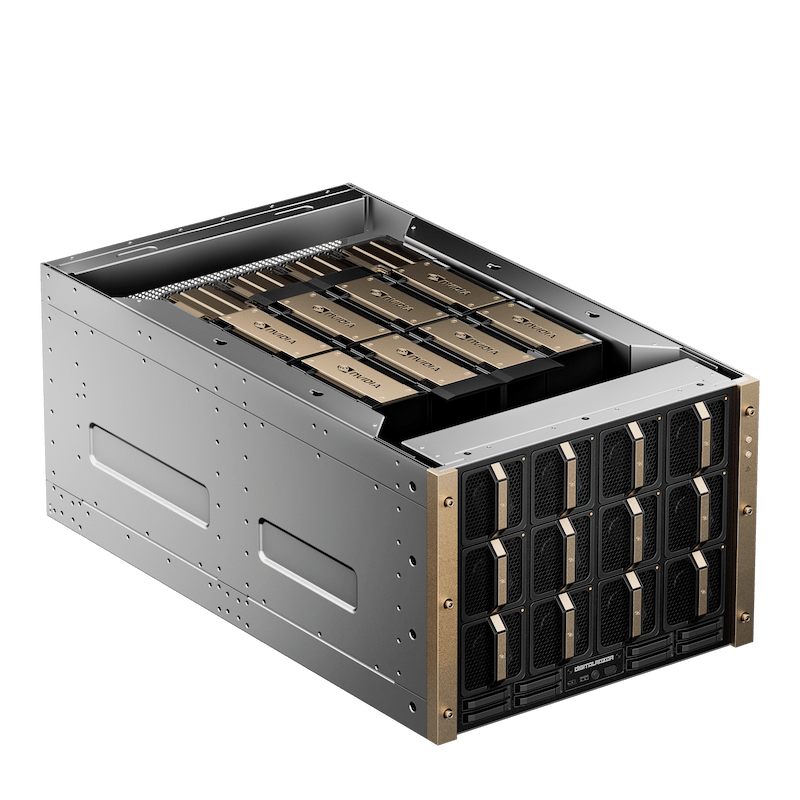

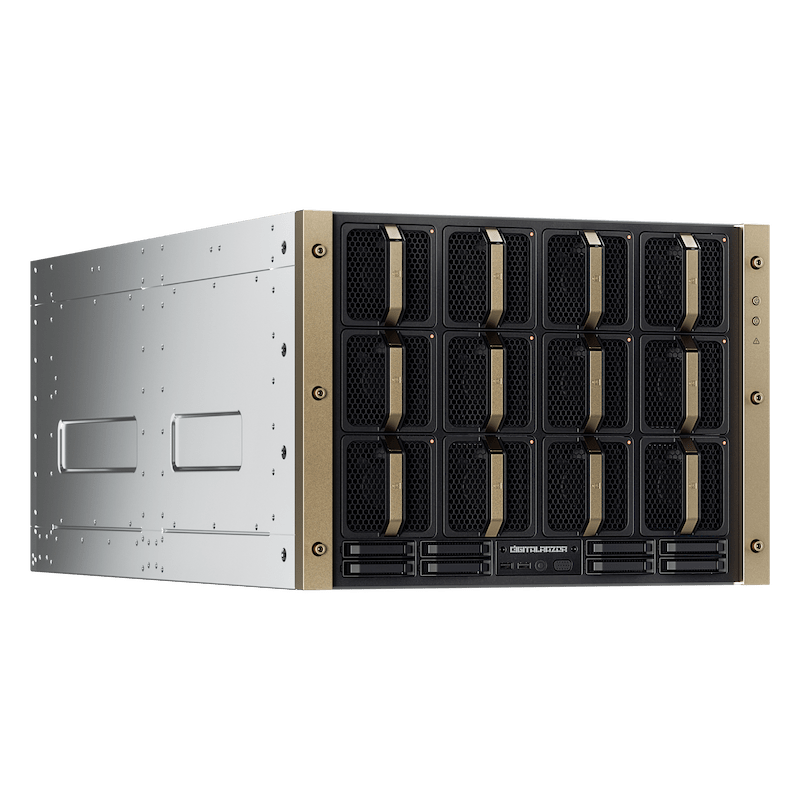

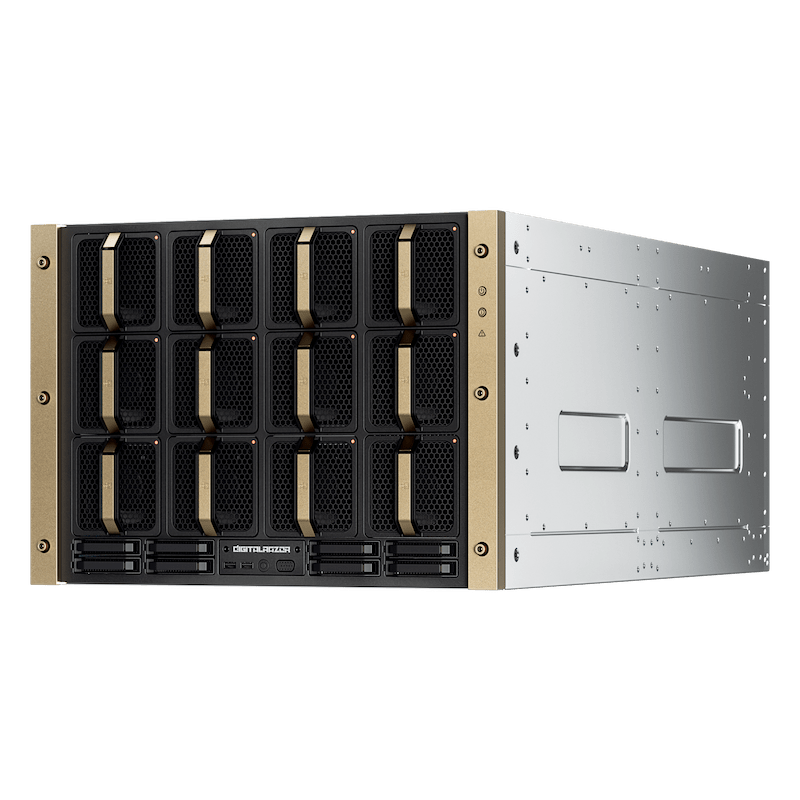

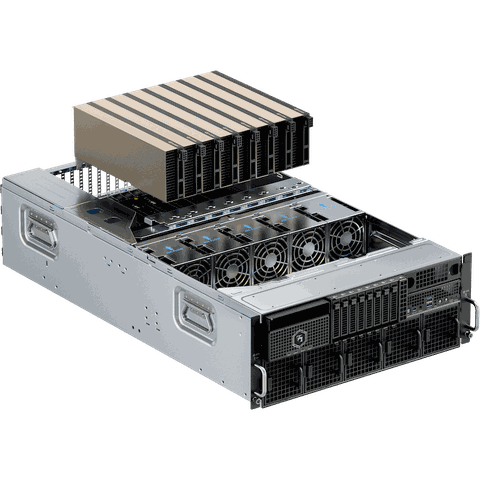

Серверные платформы NVIDIA HGX

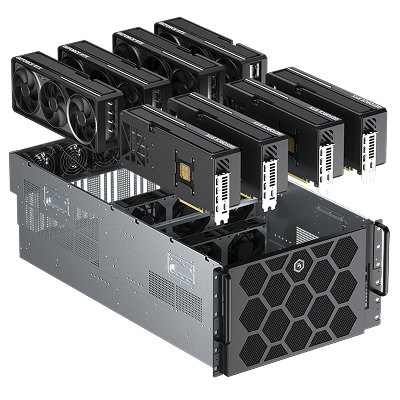

Платформа на базе двух процессоров Xeon / EPYC. Единый вычислительный модуль из 8 ускорителей NVIDIA H200 SXM, объединенных через NVLink + NVSwitch.

Доступно тестирование перед покупкой.

Выберите свой HGX

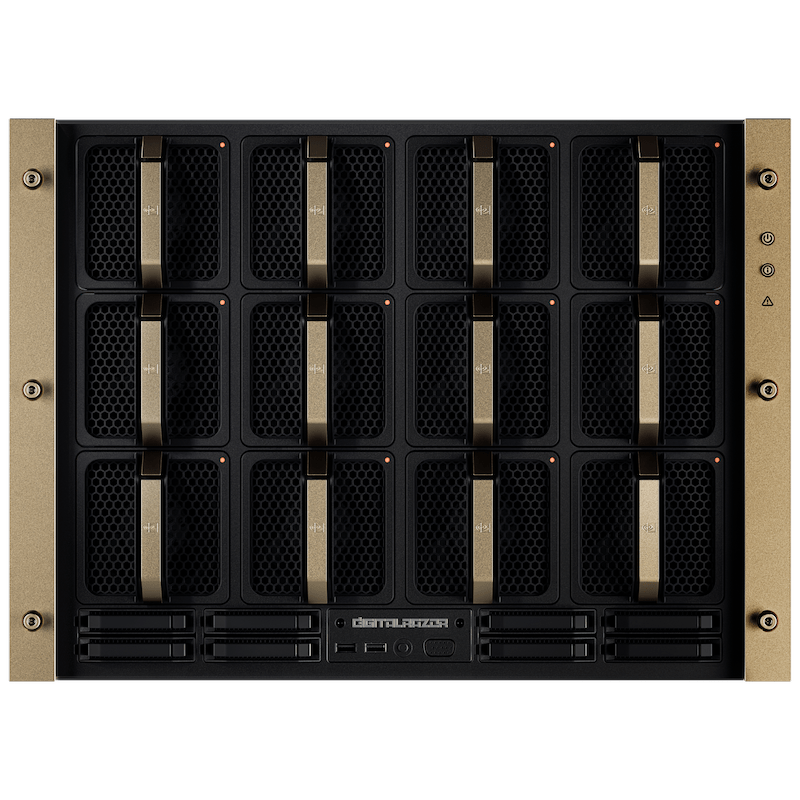

HGX H200

Процессоры

Суммарное количество ядер

Видеокарта

Количество видеокарт

Оперативная память

HGX H200

Процессоры

Суммарное количество ядер

Видеокарта

Количество видеокарт

Оперативная память

Сценарии применения

Ваш технологический партнер

Более 10 лет опыта в High-Performance Computing. Предлагаем проверенные решения для бизнеса и науки с официальной гарантией и поддержкой на всей территории РФ.

Собственное производство

Серийная сборочная линия в России. Промышленные стандарты монтажа и масштабируемые мощности для реализации крупных инфраструктурных проектов.

Экспертиза

в HPC

Более 10 лет опыта в построении высоконагруженных систем. Понимаем специфику «железа» и софта для задач ИИ, рендеринга и науки.

Контроль качества

Многоступенчатая система проверки компонентов. Обязательное 72-часовое нагрузочное тестирование каждого сервера перед отгрузкой клиенту.

Сервис и логистика

Федеральная доставка с полным страхованием груза. Собственная сервисная служба и техническая поддержка на всей территории РФ.

Оплата и оформление

Мы адаптировали процессы под требования корпоративных заказчиков и госструктур. Обеспечиваем полное документальное сопровождение, гибкие финансовые инструменты и соблюдение всех регламентов закупки.

Нам доверяют лидеры рынка

Поставляем высоконагруженные системы для ведущих банков, научно-исследовательских институтов и промышленных предприятий России. Обеспечиваем инфраструктуру для задач любой сложности: от обучения ИИ в МФТИ до банковского скоринга в Сбере.

Альфа-Банк

Samsung

Инновационный центр «Сколково»

Самарский университет

Глобалтехэкспорт

МФТИ

Айтеко

Usetech

МЭИ

Визионеро

ФИЦ Коми научный центр УрО РАН

Консультант+Аскон

Современные системы реновации

Селигдар

ИПЭЭ РАН

Эффективные технологии

XO Studios

Сбер