Что такое llama.cpp и зачем он нужен: руководство по локальному запуску LLM

Содержание

- Что такое llama.cpp и как он работает

- История создания llama.cpp

- Ключевые принципы и архитектура

- Формат GGUF: стандарт для квантизированных моделей

- Квантизация: как уместить LLM в обычный ноутбук

- Основные возможности llama.cpp

- Поддержка множества бэкендов для вычислений

- Гибридный режим: совместное использование CPU и GPU

- Серверный режим с OpenAI API совместимостью

- Python-биндинги для разработчиков

- Производительность: CPU vs GPU, бенчмарки, квантизация

- Практические примеры использования

- Сравнение llama.cpp с альтернативами инструментами

- Гайд по установке и использованию llama.cpp

- Заключение

- FAQ: ответы на популярные вопросы

Ищете идеальный компьютер?

Мы поможем подобрать ПК под игры, работу или учебу.

Рассказываем всё о движке llama.cpp: что это такое, история создания, особенности и пошаговый гайд по установке на локальном оборудовании.

Запуск больших языковых моделей перестал быть привилегией облаков. Сегодня LLM можно запускать локально — на домашнем ПК, рабочей станции или сервере без подключения к интернету. Ключевую роль в этом сыграл проект llama.cpp. Он сделал локальный инференс быстрым, предсказуемым и доступным даже на обычном железе.

Что такое llama.cpp и как он работает

llama.cpp — это движок с открытым исходным кодом на C/C++, предназначенный для локального запуска больших языковых моделей. Он позволяет использовать модели семейства LLaMA и другие LLM прямо на твоём компьютере — без облачных сервисов и постоянного подключения к интернету.

История создания llama.cpp

Движок llama.cpp создал в 2023 году независимый болгарский разработчик Георгий Герганов. Изначально он задумывал проект как компактную библиотеку на C/C++ для локального инференса языковой модели LLaMA от Meta (компания признана в РФ экстремистской организацией), однако со временем расширил поддержку и на другие современные LLM.

Работа над llama.cpp началась осенью 2022 года и опиралась на опыт, полученный Гергановым при разработке whisper.cpp — библиотеки для локального запуска модели распознавания речи Whisper от OpenAI. Ключевая идея проекта заключалась в том, чтобы сделать запуск больших языковых моделей возможным на устройствах без дискретных и специализированных GPU.

Доступность — основная цель проекта. llama.cpp изначально проектировался как инструмент без сложной установки и тяжёлых зависимостей, чтобы запуск больших языковых моделей был возможен не только для профессиональных программистов, но и для широкого круга пользователей.

Отдельно стоит отметить вклад разработчицы Джастин Танни, которая участвовала в оптимизации llama.cpp и создала инструмент llamafile. Он позволяет упаковать всё необходимое для работы модели в один файл формата GGUF, который можно запускать на разных операционных системах без установки.

Сегодня llama.cpp считается одним из самых популярных инструментов для локального запуска LLM. Его используют как основу для множества интерфейсов, серверных решений и экспериментальных проектов, сочетая высокую эффективность, контроль над данными и независимость от облачных сервисов.

Ключевые принципы и архитектура

Ключевая особенность llama.cpp — высокая эффективность инференса при сравнительно низких требованиях к оборудованию. Движок активно использует квантизацию и оптимизирован для работы на CPU, что позволяет запускать крупные модели даже на обычных ПК и ноутбуках. При этом llama.cpp остаётся кроссплатформенным решением и не привязан к конкретной аппаратной или программной экосистеме.

Основные принципы:

- Минимальное потребление памяти;

- Предсказуемые задержки;

- Эффективная работа с CPU и GPU;

- Отсутствие зависимости от технологии CUDA как обязательного требования.

Формат GGUF: стандарт для квантизированных моделей

GGUF (Georgi Gerganov Universal Format) — бинарный формат хранения моделей, разработанный для llama.cpp.

Формат GGUF стал развитием более раннего GGML и был создан как универсальный и расширяемый контейнер для квантизированных LLM. Его идея проста: собрать в одном файле всё, что нужно для запуска модели — описание архитектуры, данные токенизатора, параметры квантизации и сами сжатые веса. Благодаря этому модель остаётся переносимой, самодостаточной и не требует внешних зависимостей при запуске.

Преимущества GGUF:

Портативность. GGUF объединяет модель, параметры запуска и данные токенизатора в одном файле, что упрощает хранение, передачу и повторное использование без сложной настройки.

Расширяемость. Формат использует систему метаданных «ключ–значение», благодаря которой можно добавлять новые параметры и типы квантизации без поломки совместимости со старыми версиями.

Быстрый запуск. GGUF оптимизирован под эффективную загрузку и часто использует отображение в память (mmap). Это позволяет загружать веса по мере необходимости, сокращая время старта и потребление оперативной памяти, особенно у крупных моделей.

Широкая поддержка. Изначально формат создавали под llama.cpp, но со временем он стал стандартом де-факто для локального инференса и поддерживается множеством инструментов в open-source экосистеме.

Файл GGUF состоит из трёх основных частей:

- Заголовок. Сообщает системе тип файла и его версию — это нужно для корректного чтении модели;

- Метаданные. «Паспорт» модели: здесь прописаны архитектура, настройки токенизатора и метод квантизации;

- Данные о тензорах. Основной массив данных: содержит веса и их структуру, без которых запуск (инференс) невозможен.

GGUF решает задачу удобного хранения и загрузки модели, но не отвечает на главный вопрос — как уместить LLM в память обычного компьютера. Именно для этого в llama.cpp активно используется квантизация.

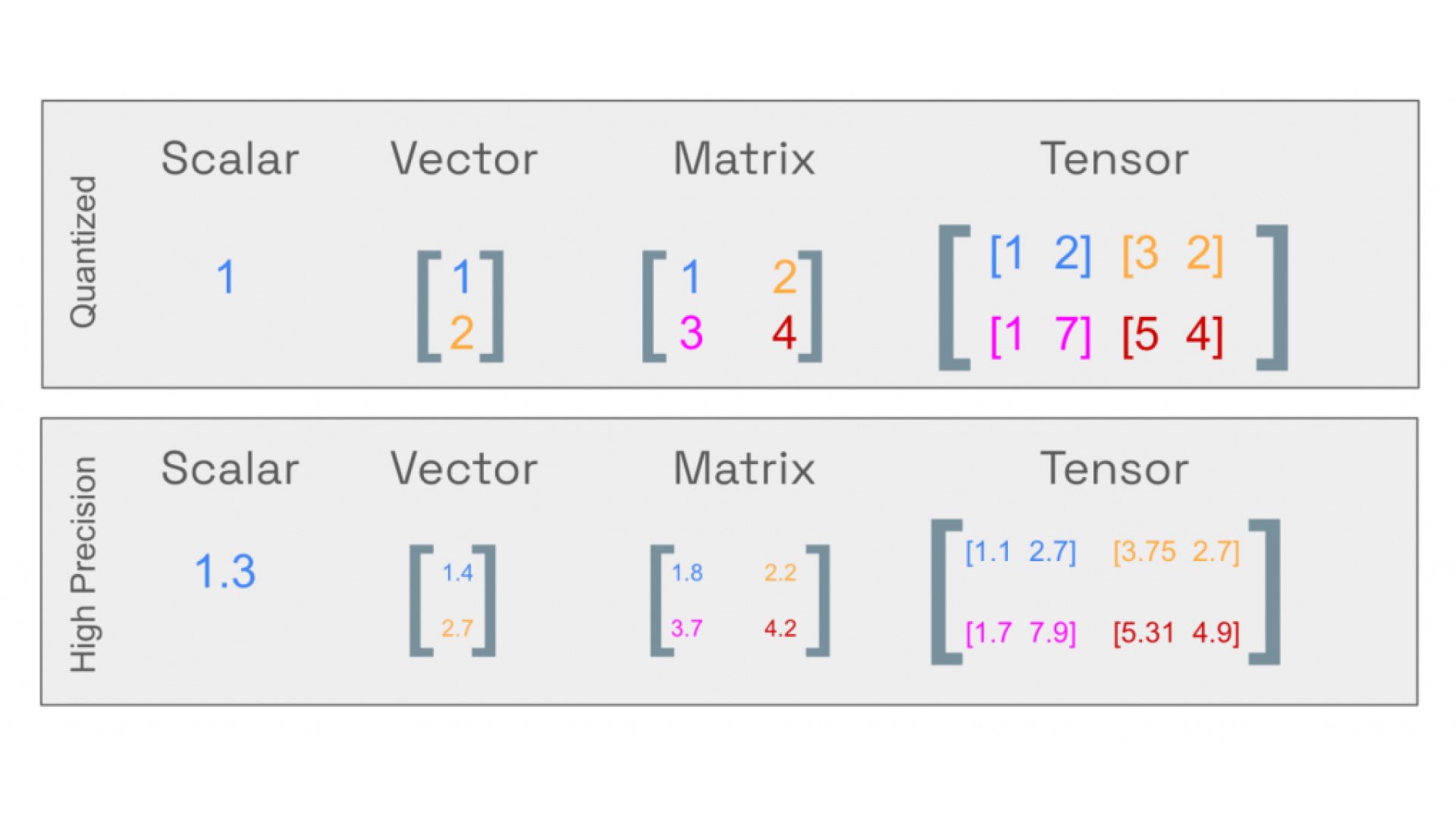

Квантизация: как уместить LLM в обычный ноутбук

Квантизация — технология уменьшения размера нейросети за счёт снижения битности её числовых параметров. Вместо стандартных форматов с высокой разрядностью (FP16 или FP32) используются более компактные, например 8-битные или 4-битные. Это снижает требования к памяти и ускоряет вычисления, при этом качество ответов в большинстве задач меняется незначительно. Зато благодаря этому LLM можно запускать даже на обычных ноутбуках.

Квантизация состоит из следующих процессов:

Оценка данных. Система анализирует, в каких пределах лежат веса и внутренние значения модели, чтобы понять, какую точность можно снизить без заметной потери качества.

Масштабирование значений. Алгоритм переводит числа в оптимальный диапазон для записи в меньшей разрядности без критических искажений.

Снижение точности. Метод округляет значения до упрощённого формата, который процессор или видеокарта обрабатывают быстрее.

Работа с результатом. При необходимости система преобразует выходные данные в привычный вид, не возвращая всю модель к исходной точности.

Сравнение квантизированных и высокоточных параметров

Пример: модель LLaMA 70 млрд параметров в формате FP16 потребляет около 130 ГБ памяти. Та же модель после квантизации Q4 — всего 40–45 ГБ. Это может быть оперативная и (или) видеопамять, в зависимости от метода инференса. К этому мы ещё вернёмся позже

| Методы квантизации | Размер модели, ГБ | Потребление памяти, ГБ | Средняя потеря качества, % |

|---|---|---|---|

| IQ2XS | 19,4 | 21,1 | 19,21 |

| Q2_K | 27,27 | 31,09 | 8,82 |

| Q3_K_S | 28,6 | 31,4 | 7,89 |

| Q3_K_M | 30,83 | 35,54 | 4,72 |

| Q3_K_L | 33,67 | 38,65 | 3,8 |

| Q4_0 | 36,20 | 41,37 | 3,61 |

| Q4_1 | 40,20 | 45,67 | 2,37 |

| Q4_K_S | 36,39 | 41,37 | 1,5 |

| Q4_K_M | 39,5 | 42,1 | 1,20 |

| Q5_0 | 44,20 | 49,96 | 1,26 |

| Q5_K_S | 45,3 | 47,7 | 0,5 |

| Q5_K_M | 46,5 | 48,9 | 0,4 |

| Q6_K | 54 | 56,1 | 0,16 |

| F16 | 128,5 | 129,5 | 0 |

Сравнительная таблица методов квантизации модели LLaMA 70B

llama.cpp поддерживает широкий спектр методов квантизации

- Q6 — максимум качества;

- Q5/Q4 — оптимальный баланс;

- Q2 — минимальный размер ценой точности.

Квантизация — это баланс между компактностью и качеством. Самый наглядный пример — генерация изображений.

Влияние разных методов квантизации на качество генерации изображения

Основные возможности llama.cpp

Локальная работа с моделью. llama.cpp позволяет запускать LLM полностью офлайн и использовать её как персонального ассистента. Он может работать как локальный ChatGPT при корректной настройке.

Широкая поддержка LLM. llama.cpp работает с LLaMA, Mistral, Qwen, Gemma и другими моделями.

Интеграция с инструментами и интерфейсами. llama.cpp используется как бэкенд для множества UI и платформ инференса (Ollama, LM Studio).

Помощь в программировании. При использовании instruction-моделей llama.cpp способен объяснять код, предлагать правки, генерировать функции и помогать с отладкой. И всё это полностью локально.

Анализ документов. Движок подходит для обработки больших текстов: отчётов, статей, технической документации. Модель может кратко пересказывать содержание и выделять ключевые идеи.

Поддержка множества бэкендов для вычислений

llama.cpp может вести инференс разными способами — подстраивается под те комплектующие и ОС, которые у тебя есть.

Поддерживаемые варианты:

- CPU. Основной и самый стабильный режим. Использует современные инструкции (AVX2, AVX-512, AMX), что позволяет эффективно запускать модели даже без видеокарты;

- CUDA (NVIDIA). Ускорение на видеокартах NVIDIA, с частичным или полным переносом вычислений на GPU;

- Metal (Apple Silicon). Оптимизированный бэкенд для Mac с чипами M-серии;

- Vulkan. Универсальный GPU-бэкенд для разных платформ;

- OpenCL. Экспериментальный режим, применяется реже.

Гибридный режим: совместное использование CPU и GPU

При инференсе на CPU вычисления происходят за счёт мощности процессора, а веса модели и рабочие данные размещаются в оперативной памяти. Такой режим универсален и не требует дискретного GPU. Но всё упирается в пропускную способность памяти и вычислительные ресурсы CPU.

При инференсе на GPU основная нагрузка переносится на видеокарту, а модель размещается в видеопамяти. Это позволяет существенно ускорить генерацию, но требует достаточного объёма VRAM и совместимого бэкенда.

Llama.cpp поддерживает гибридный режим вычислений, при котором нагрузка распределяется между центральным процессором и видеокартой. Это позволяет:

- Использовать видеокарту для ускорения работы ИИ;

- Задействовать ресурсы CPU и оперативной памяти вместо жёсткой привязки к видеопамяти;

- Гибко масштабировать инференс под конкретную конфигурацию системы.

На практике гибридный режим особенно полезен на домашних ПК и рабочих станциях, где GPU ускоряет самые тяжёлые операции, а CPU берёт на себя оставшуюся часть модели.

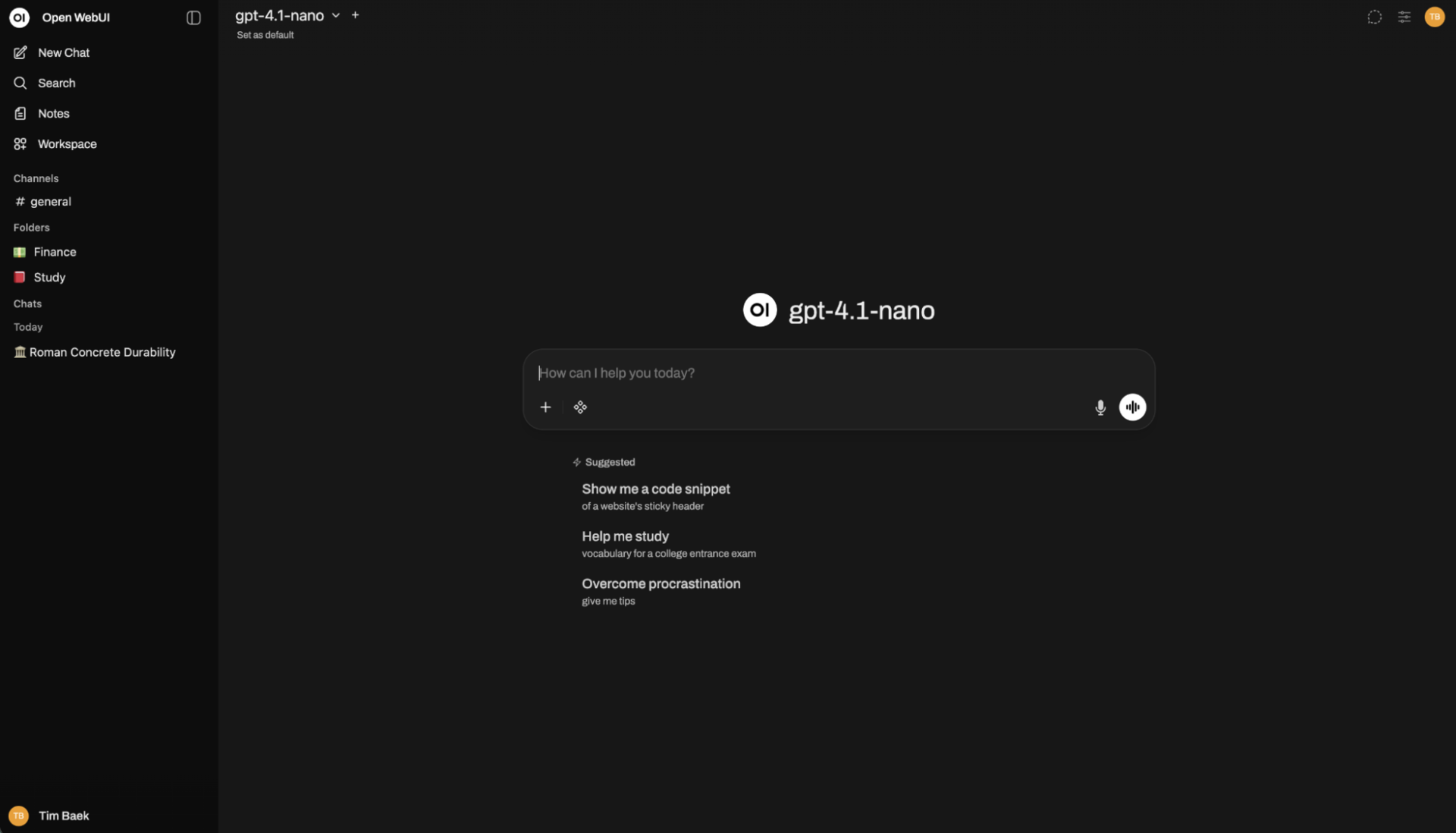

Серверный режим с OpenAI API совместимостью

В серверном режиме llama.cpp работает как локальный API-сервис, совместимый с OpenAI. API-сервис — это программа, к которой другие приложения могут обращаться по стандартным запросам и получать ответы в структурированном виде.

Llama.cpp позволяет развернуть на собственном компьютере или сервере аналог ChatGPT API и подключать к нему приложения и клиенты, рассчитанные на этот протокол.

Такой режим часто используют вместе с веб-интерфейсами, например Open WebUI: модель запускается локально, данные не передаются в облако, а пользователь получает удобную и полностью автономную среду для работы с LLM.

Интерфейс Open WebUI, работающий на движке llama.cpp

Python-биндинги для разработчиков

Python-биндинги позволяют использовать llama.cpp прямо в приложениях (на Python) — запускать модель, управлять генерацией и работать с диалогами. Это упрощает создание ботов, скриптов, сервисов. Примеры использования:

- LangChain — популярный Python-фреймворк для построения приложений на базе LLM: чат-ботов, агентных систем и RAG-сценариев;

- LlamaIndex — фреймворк для организации поиска, индексации и анализа данных с использованием больших языковых моделей;

- OpenWebUI — веб-оболочка, с которой твой локальный ИИ выглядит и работает как ChatGPT. Взаимодействие идёт через API, совместимый с OpenAI.

Производительность: CPU vs GPU, бенчмарки, квантизация

Llama.cpp заточен под локальный инференс и повседневное использование. Производительность здесь — это компромисс: чтобы модель работала быстро и умно, но не требовала суперкомпьютера.

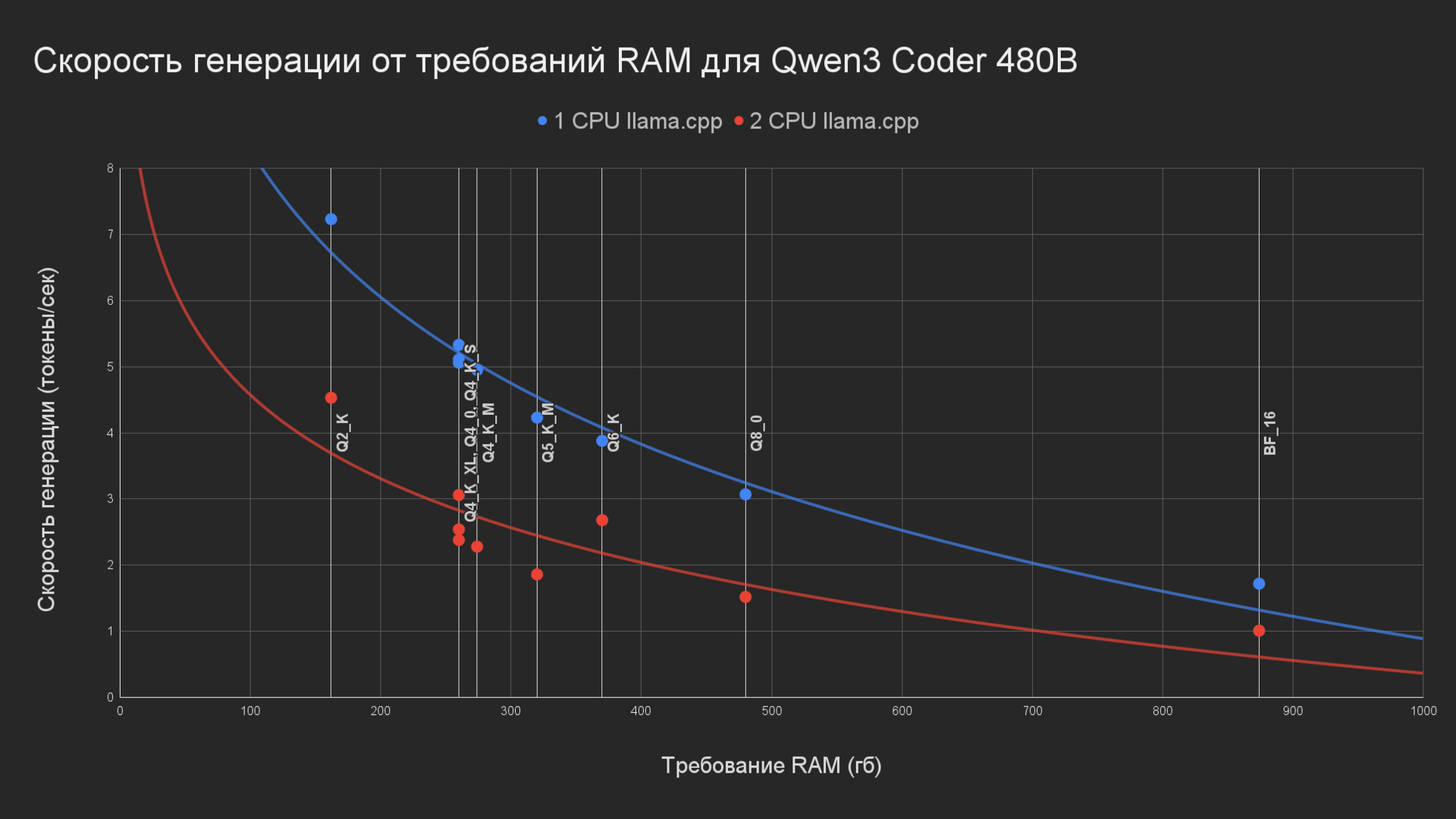

Для начала сравним скорость генерации на конфигурациях с одним и двумя процессорами. На графике ниже мы видим показатели скорости генерации и требования RAM для разных уровней квантизации (уровней сжатия) модели Qwen3 Coder 480B. Q2_K — максимальное сжатие, BF-16 — минимальное.

Конфигурация с одним CPU показывает примерно на 90% более высокую скорость генерации. Такой результат объясняется тем, что в двухсокетной системе из-за NUMA-архитектуры доступ к оперативной памяти становится менее эффективным, а пропускная способность ниже, чем в конфигурации с одним процессором.

Отметим, что существуют настройки которые оптимизируют работу llama.cpp для сетапов с двумя процессорами.

Скорость генерации Qwen3 Coder 480B в зависимости от объёма RAM (1CPU vs 2CPU)

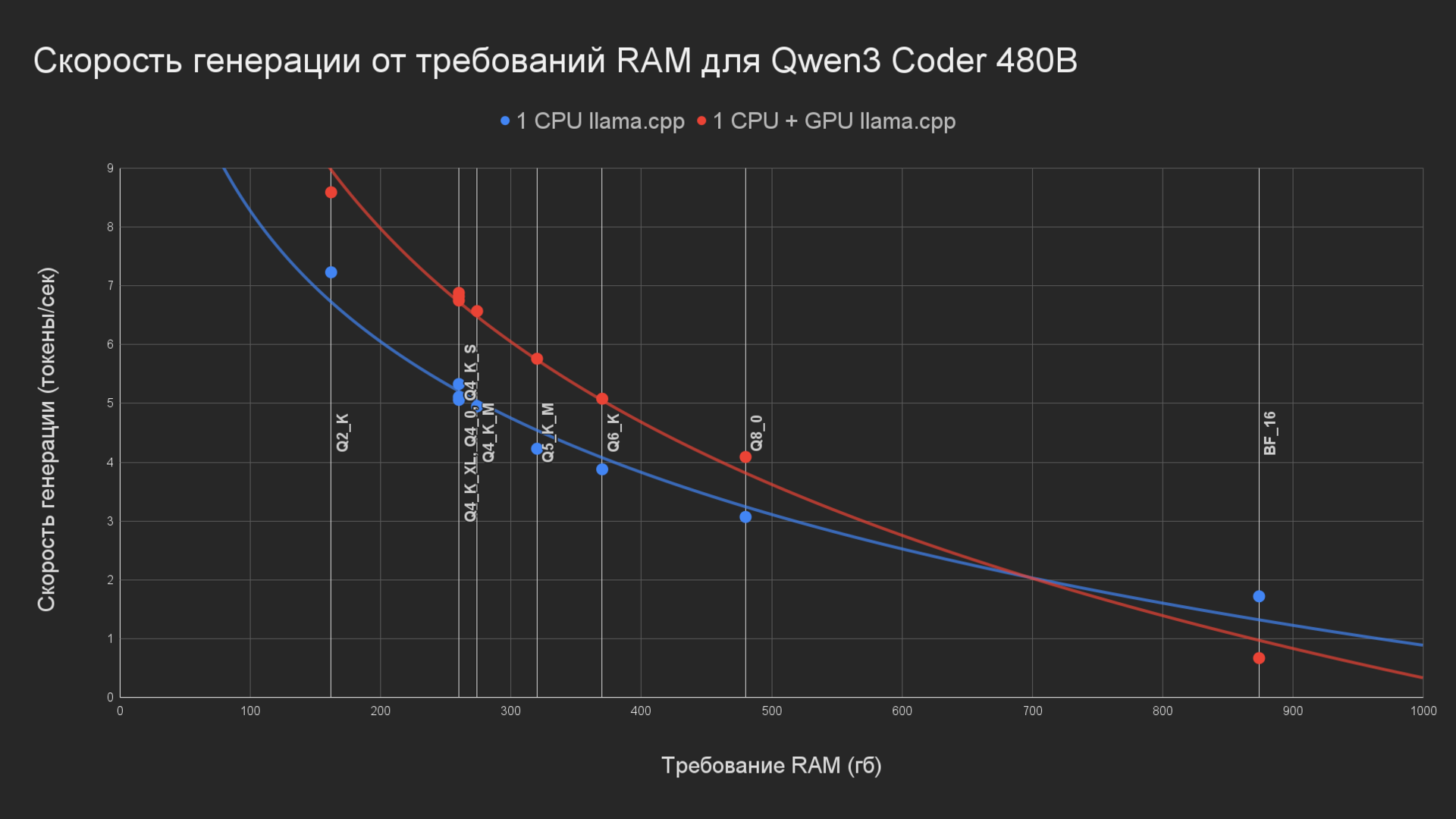

При запуске на CPU модель работает стабильно и предсказуемо, но с ограниченной скоростью генерации. Использование GPU позволяет существенно ускорить инференс.

Следующий этап — сравниваем скорость генерации на CPU и гибридный вариант CPU плюс GPU. Гибридный вариант оказывается производительнее примерно на 30% во всех случаях, кроме режима BF-16. Полагаем, что скорость теряется при передачи данных между RAM и VRAM. Чем больше размер модели, тем сильнее проявляется этот эффект.

Скорость генерации Qwen3 Coder 480B в зависимости от объёма RAM (1CPU vs 1CPU, GPU)

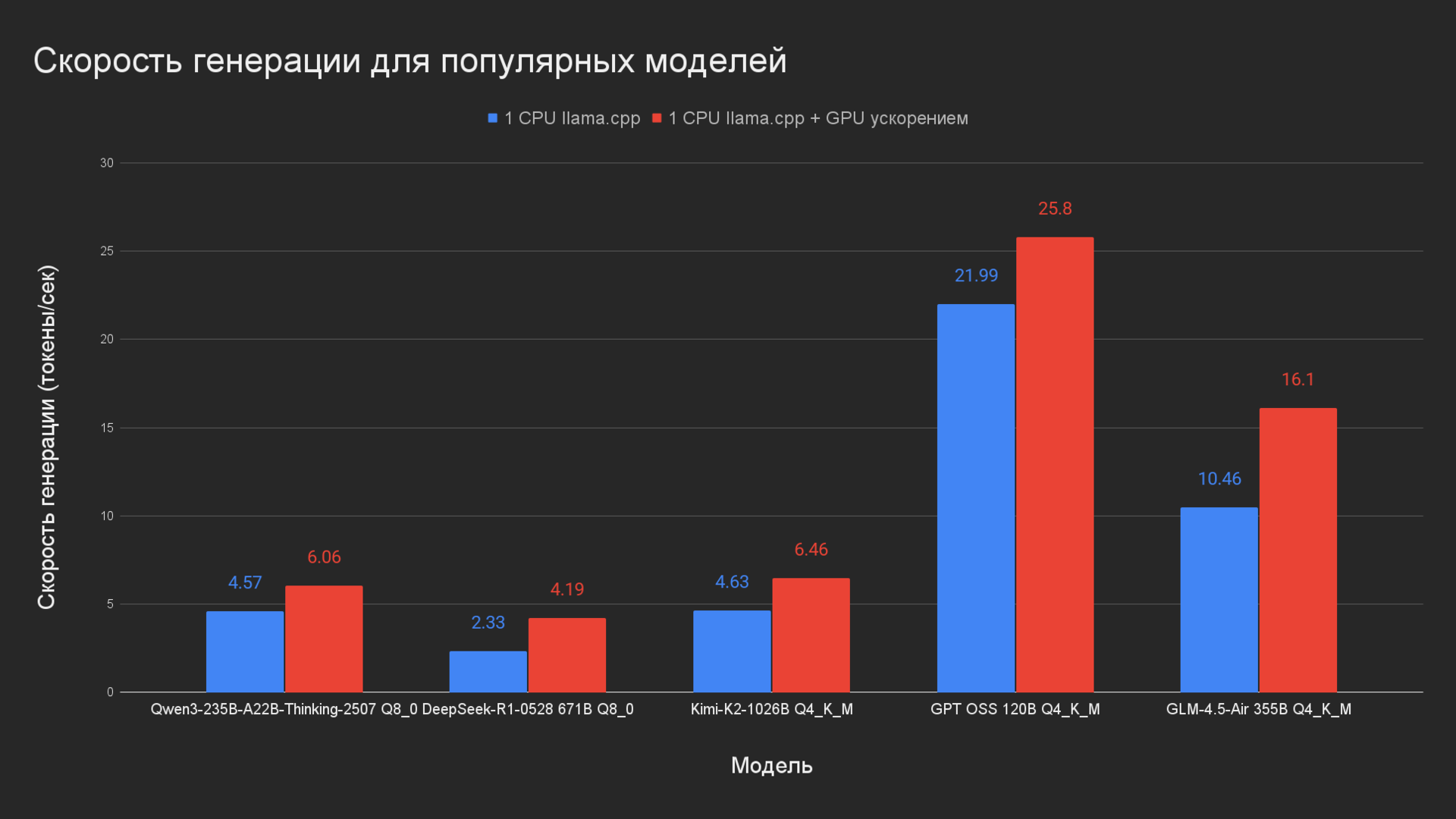

В среднем GPU ускоряет генерацию на 44% в сравнении с чистым CP

Скорость генерации популярных LLM (1CPU vs 1CPU, GPU)

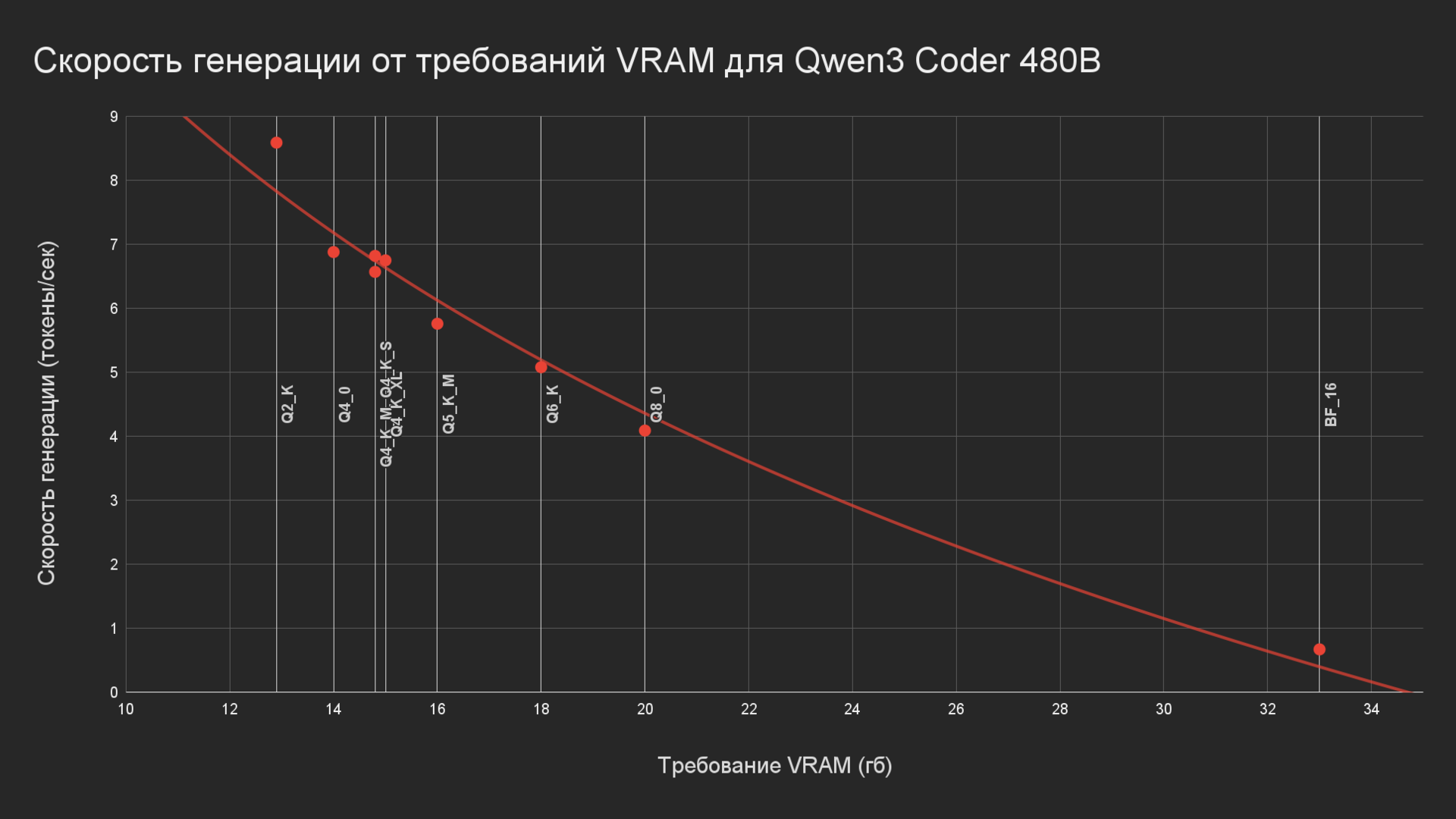

График ниже показывает, как уровень квантизации влияет на требования к видеопамяти и помогает понять, какая модель поместится в VRAM видеокарты.

Скорость генерации Qwen3 Coder 480B в зависимости от объёма VRAM (1CPU, GPU)

Для локального инференса в llama.cpp моделей малого и среднего размера, включая квантизированные LLM до 70 млрд параметров, хорошо подойдут компьютеры DigitalRazor. Для работы с более крупными моделями, высокими требованиями к памяти и GPU-ускорению рациональнее рассматривать профессиональные рабочие станции и серверные решения.

Рабочая станция для локального инференса ИИ от DigitalRazor

Практические примеры использования

Llama.cpp хороший выбор если: вес модели и низкие требования к оборудованию важнее скорости генерации.

Вот несколько распространённых сценариев использования Llama.cpp:

- Локальный ИИ-ассистент — для вопросов, идей, объяснений и работы с текстом;

- Анализ и обработка документов — резюме, договоры, ТЗ, статьи, краткие выводы, поиск ключевых идей, переписывание простым языком;

- Генерация кода — рефакторинг, работа с Python, Bash, SQL— всё полностью офлайн;

- Корпоративный ИИ — развёртывание локального OpenAI-совместимого API для внутренних сервисов и сотрудников;

- Чат-боты и интерфейсы — подключение к Open WebUI, чат-приложениям и кастомным фронтендам через серверный режим;

- Автоматизация рутинных задач — скрипты для обработки логов, CSV, JSON, отчётов и внутренних данных;

- Эксперименты с LLM и квантизацией — тестирование разных ИИ-моделей, форматов GGUF и уровней квантизации на одном ПК;

- Обучение и исследования — изучение принципов работы LLM, инференса, токенизации и оптимизации без сложной инфраструктуры.

Сравнение llama.cpp с альтернативами инструментами

Универсального инструмента для всех сценариев не существует. Выбор движка инференса всегда начинается с трезвой оценки задач и уровня подготовки.

Если цель — быстро и без лишней настройки попробовать локальные LLM, подойдут решения с низким порогом входа: Ollama или LM Studio. Они ориентированы на удобство и минимальное время запуска.

Когда нужен больший контроль, работа с CPU, квантизацией и гибкой конфигурацией — оптимальным выбором становится llama.cpp. Этот вариант чаще выбирают энтузиасты и разработчики, которым важна производительность и прозрачность работы движка.

Для серверных сценариев с высокой нагрузкой и использованием нескольких GPU приоритет смещается в сторону vLLM — он рассчитан на масштабирование, высокую пропускную способность и интеграцию в backend-сервисы.

В корпоративной среде выбирают решения уровня Triton Inference Server. Там критически важны интеграция с Kubernetes, надёжность и максимальная производительность на картах NVIDIA.

| Движок | Для кого | Где работает | Особенности |

|---|---|---|---|

| Ollama | Начинающие пользователи | Windows, macOS, Linux | Быстрый старт, минимальная настройка, простой REST API |

| LM Studio | Продвинутые пользователи | Windows, macOS, Linux | Графический интерфейс, локальный чат, встроенные инструменты |

| llama.cpp | Энтузиасты | Windows, macOS, Linux | Высокая производительность, GGUF, квантизация, гибкая настройка |

| vLLM | Разработчики и ML-инженеры | Linux (Python) | Серверный инференс, KV-cache, OpenAI-совместимый API |

| Triton + TensorRT | Корпоративные и enterprise-сценарии | Linux (RHEL, Ubuntu) | Максимальная оптимизация, GPU-ускорение, масштабирование |

Сравнительная таблица движков для инференса

Практика показывает, что многие начинают с простых инструментов для экспериментов, а по мере роста требований переходят к более специализированным и производительным платформам. Грамотно выбранный движок инференса позволяет сократить затраты ресурсов и избежать лишних технических ограничений.

Гайд по установке и использованию llama.cpp

Перейдём к установке llama.cpp и испытаем его в деле.

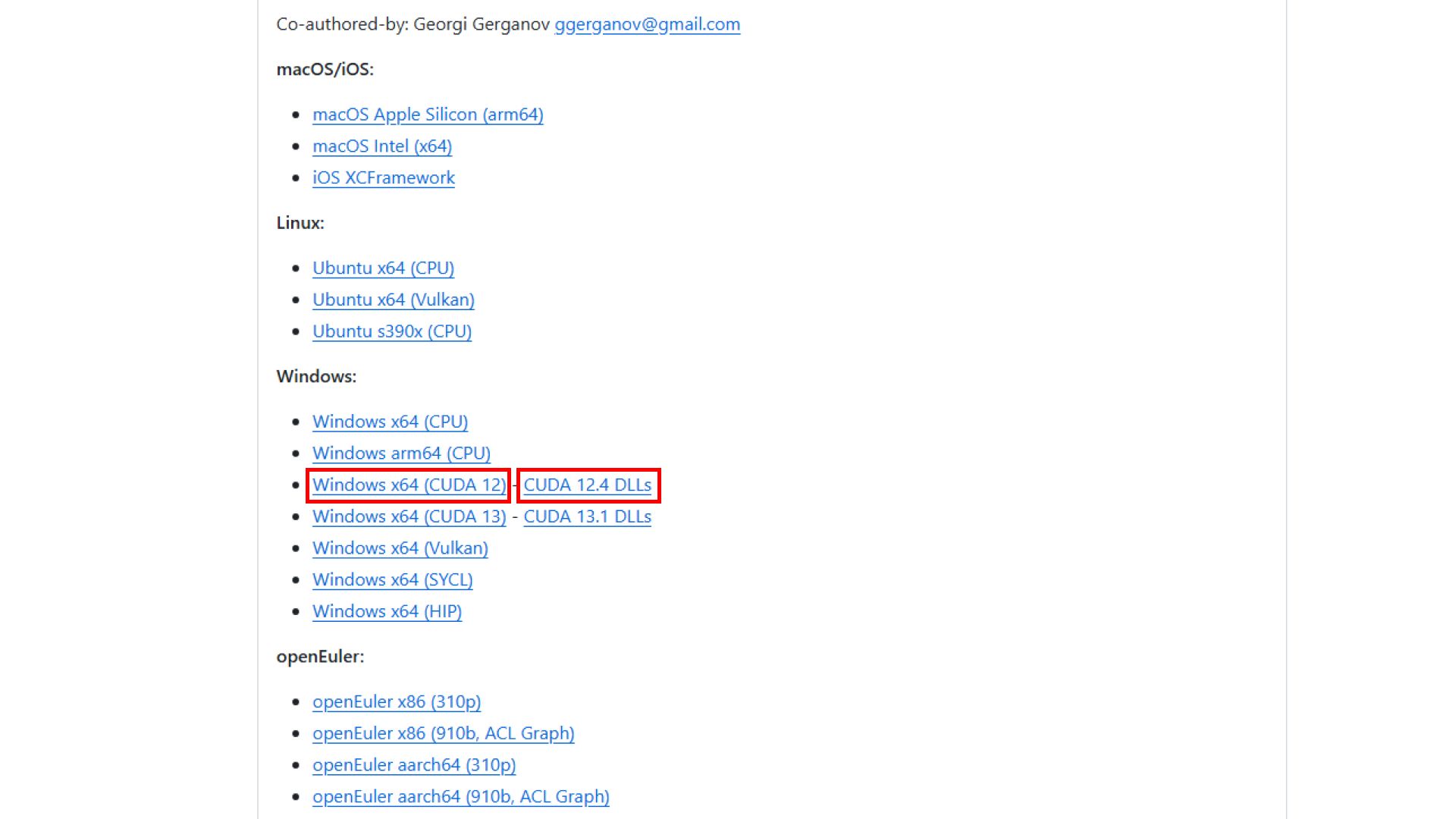

1. Скачиваем последнюю версию движка llama.cpp

Для запуска на CPU стоит выбрать вариант Windows x64 (CPU). У нас в тестовой сборке видеокарта от NVIDIA, поэтому выбираем — Windows x64 (CUDA 12) либо (CUDA 13) для видеокарт NVIDIA серии 5000.

Тут же скачиваем набор CUDA-библиотек (DLL), они необходимы для работы с видеокартами от NVIDIA.

2. Готовим llama.cpp к запуску

Распаковываем скачанные архивы с движком и CUDA-библиотеками, закидываем всё это в одну папку, назовём её просто — llama.cpp.

Дальше по инструкции:

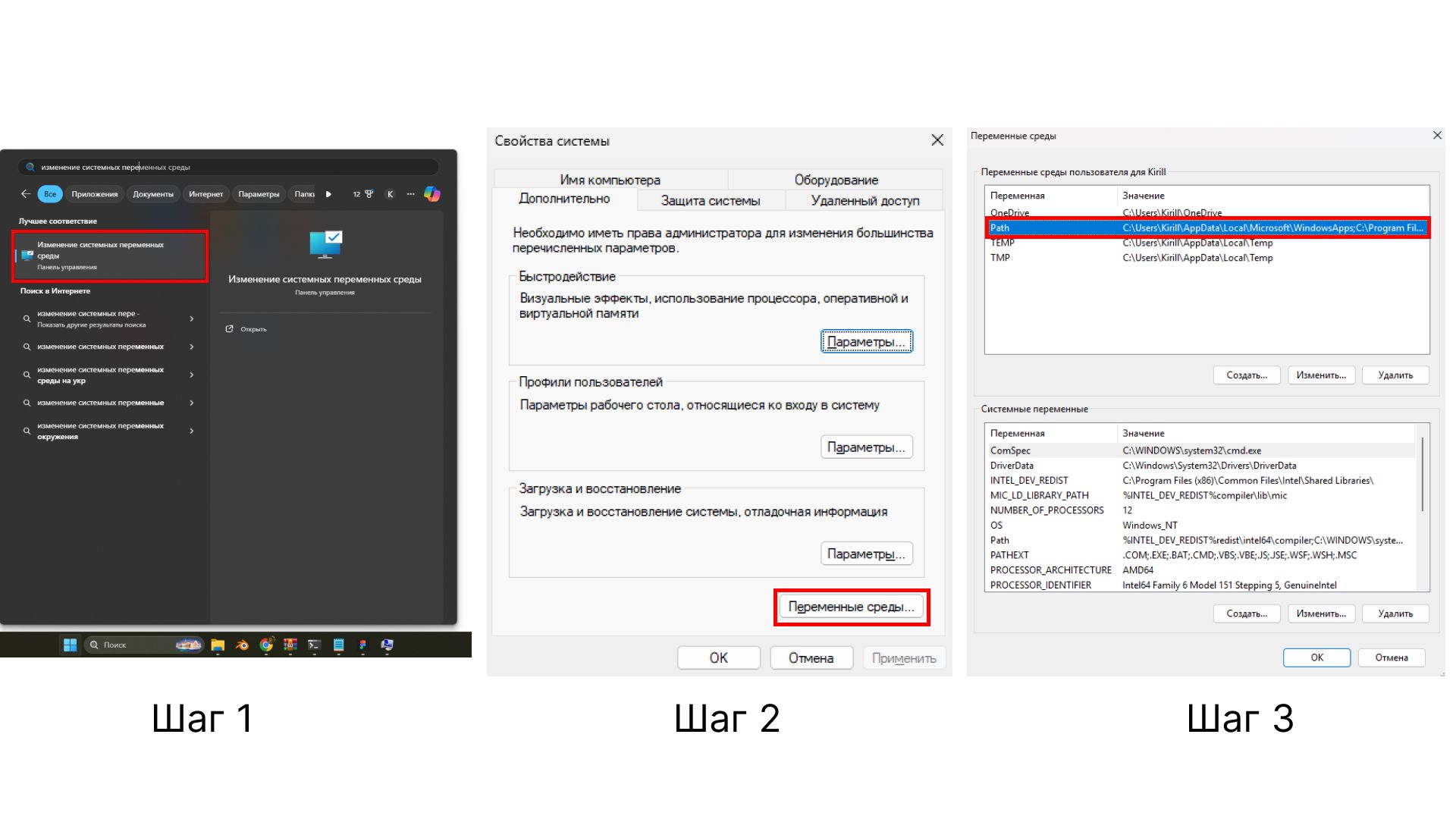

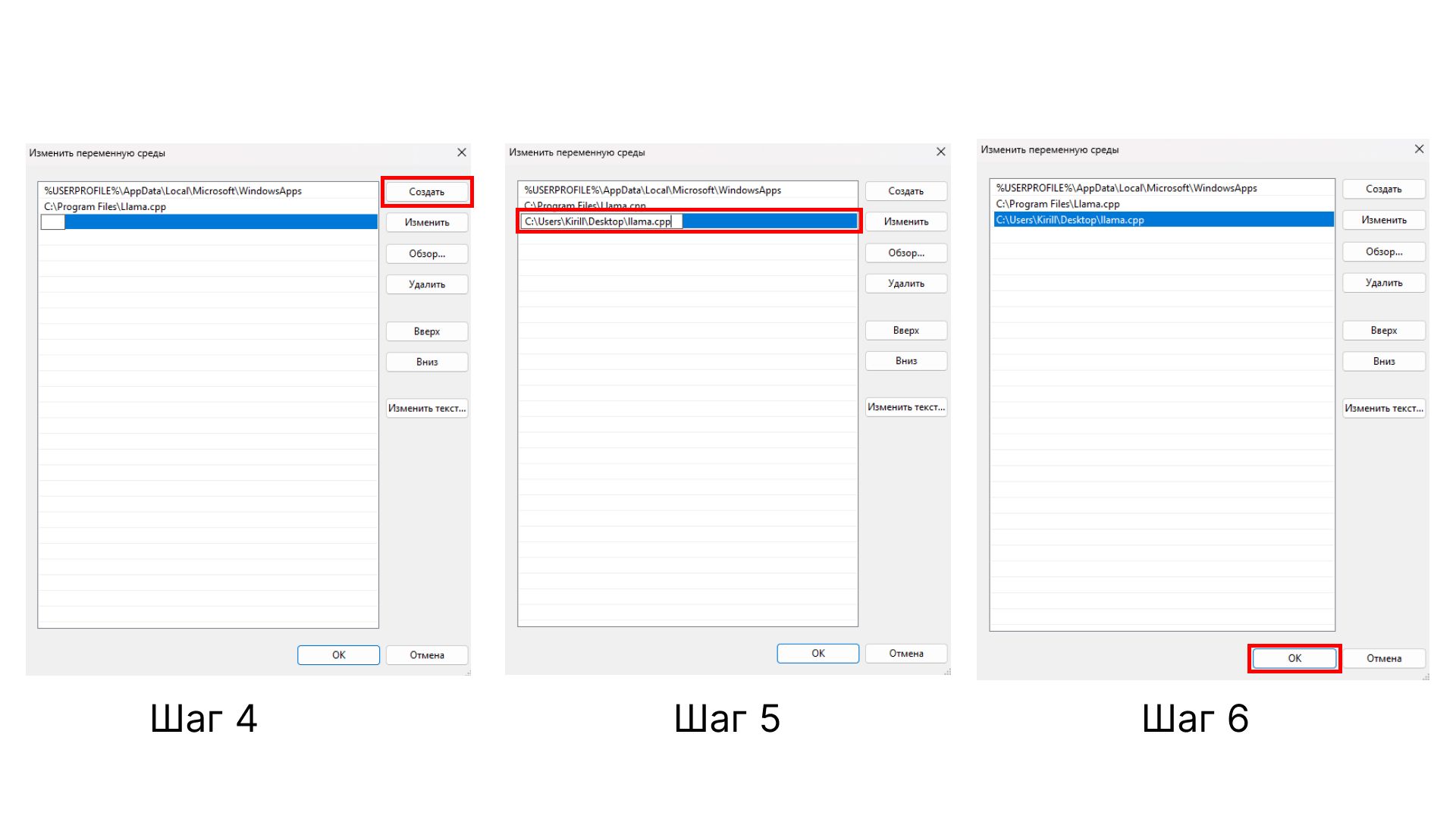

Шаг 1 — в панели «Пуск» ищем — «Изменение системных переменных среды».

Шаг 2 — жмём «Переменные среды».

Шаг 3 — двойной клик по переменной среде Path.

Шаг 4 — создаём переменную, жмём «Создать».

Шаг 5 — копируем путь к папке llama.cpp куда мы поместили наш движок.

Шаг 6 — жмём ОК, сложная часть закончена!

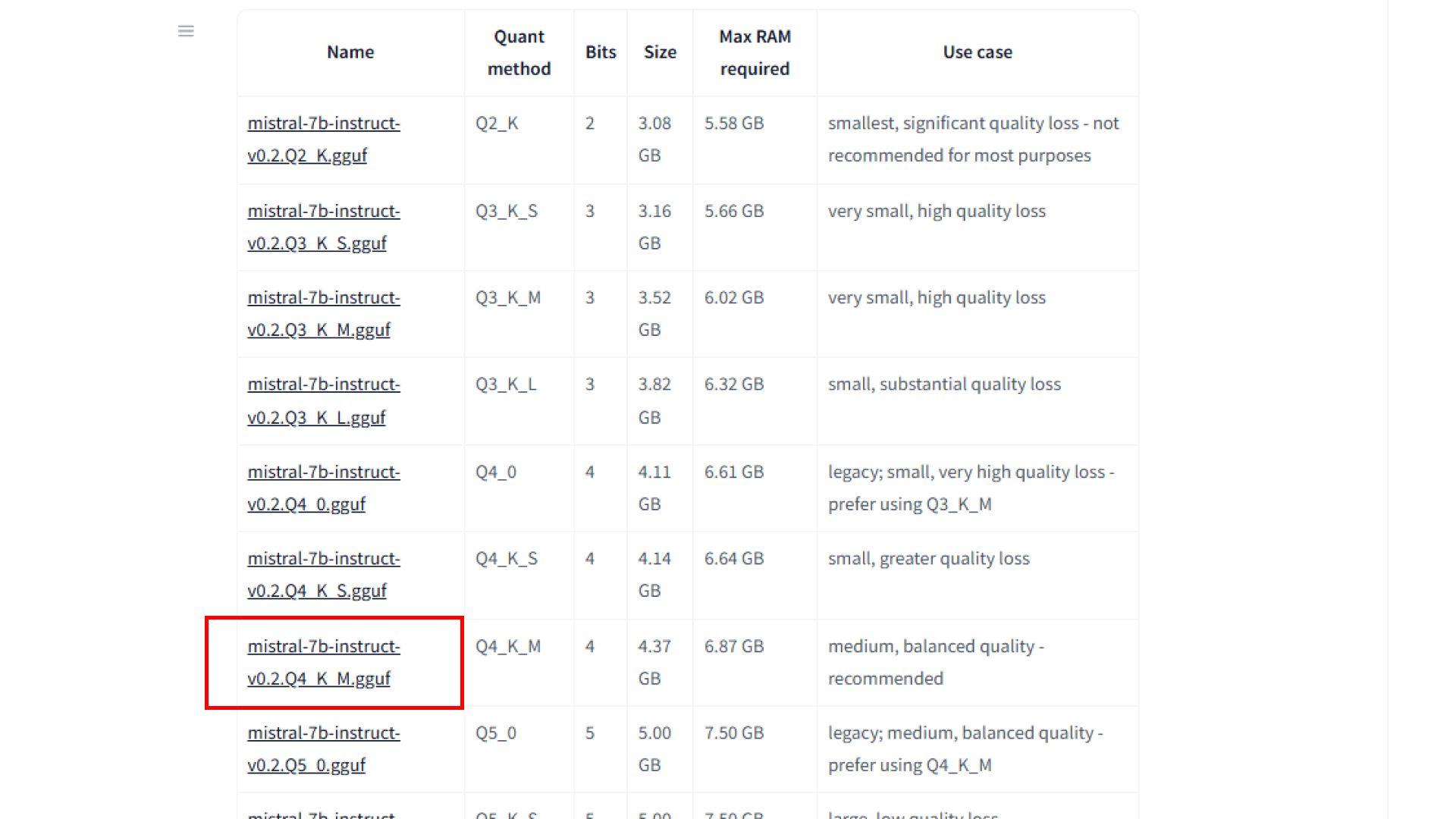

3. Скачиваем модель ИИ в формате GGUF.

Качаем небольшую модель Mistral 7B Instruct. Тут нас встречает уже знакомая таблица с разными типами квантизации. Для первого опыта отлично подойдёт Q4_K_M.

4. Запускаем локальный ИИ.

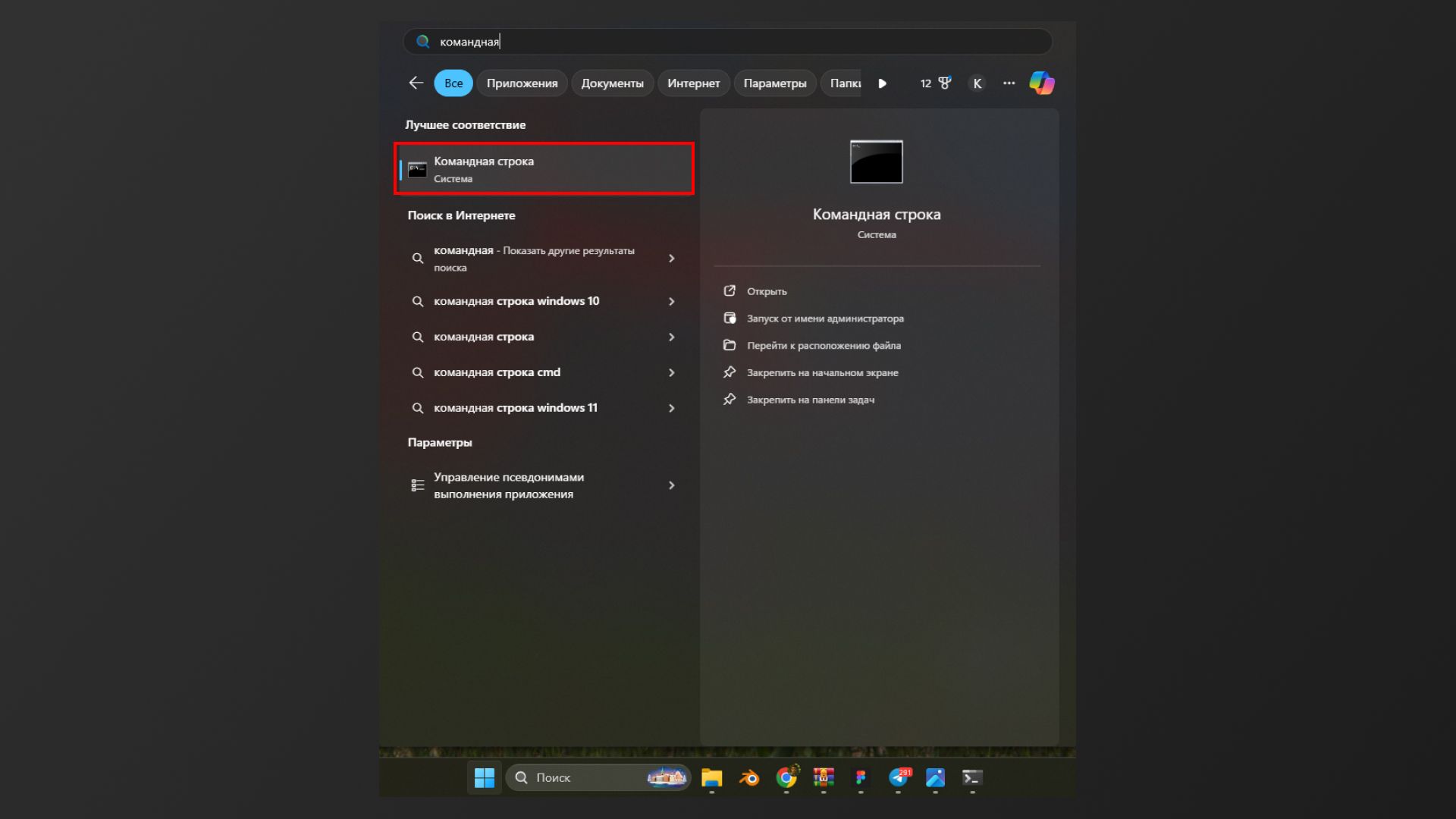

Работает llama.cpp через командную строку — открываем её в меню «Пуск».

Остаётся всего два действия.

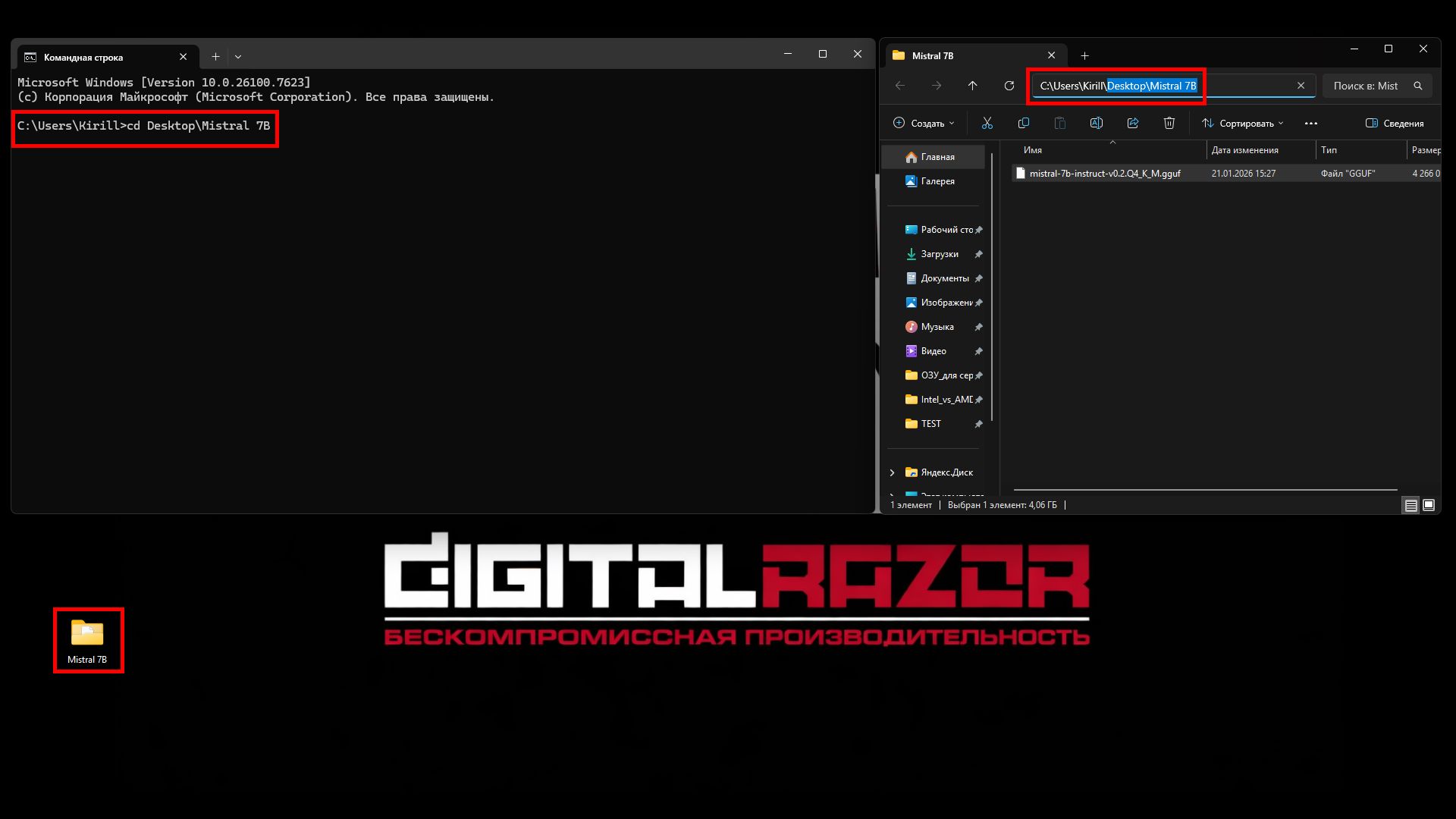

Нам нужно указать в какой папке лежит наша модель Mistral 7B Instruct. У нас это папка Mistral 7B на рабочем столе. Если повторяешь всё в точности — просто копируй следующие команды. Главное проверь, что путь и название папки совпадают:

- Указываем путь к папке: пишем команду — cd Desktop\Mistral 7B

- Жмём enter.

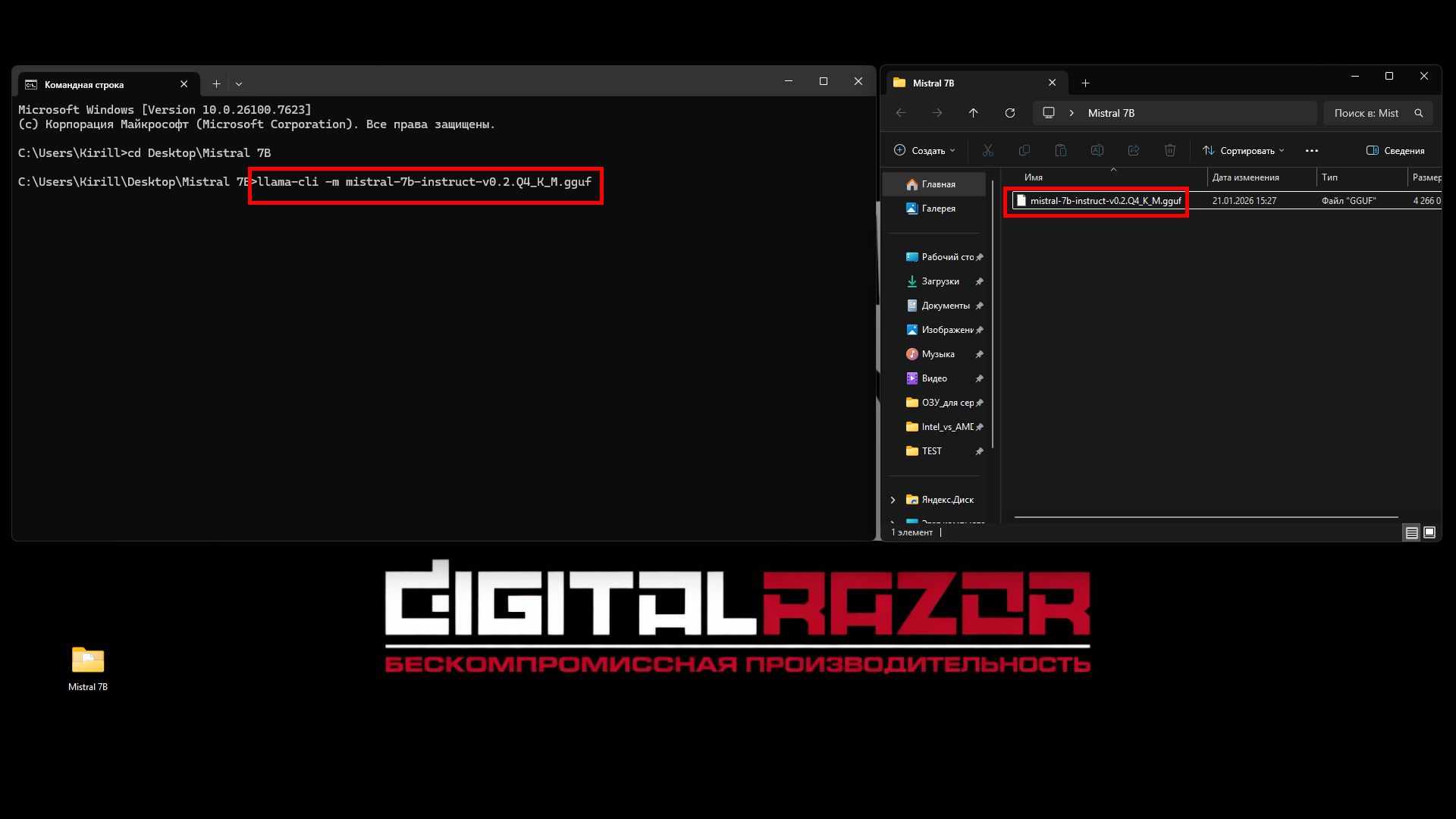

- Запускаем модель, пишем команду — llama-cli -m mistral-7b-instruct-v0.2.Q4_K_M.gguf

- Жмём Enter.

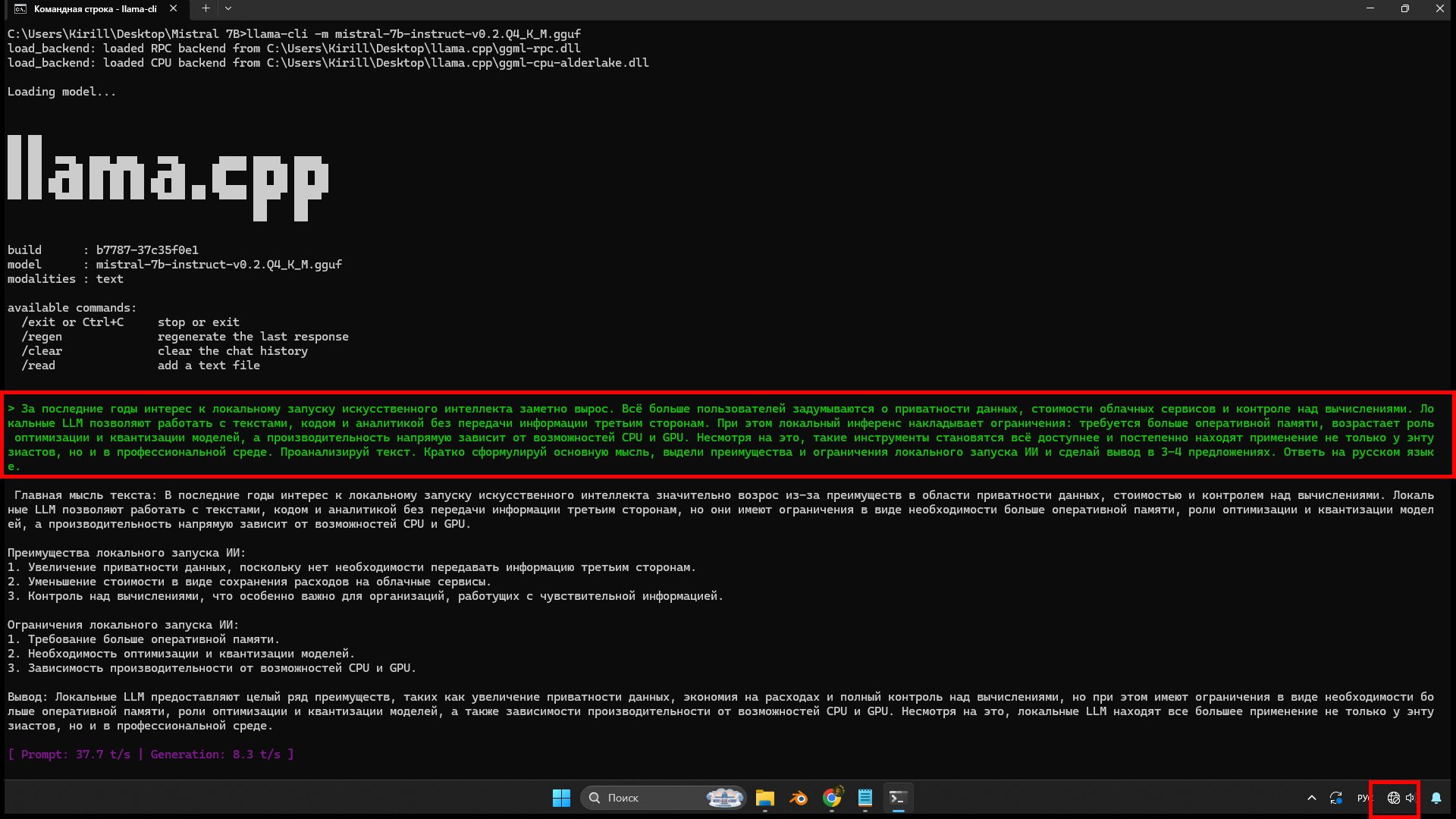

5. Готово! В качестве примера дадим задание проанализировать небольшой текст. Копируем текст в командную строку и пишем задачу «Проанализируй текст. Кратко сформулируй основную мысль, выдели преимущества и ограничения локального запуска ИИ и сделай вывод в 3–4 предложениях».

Практика показывает, что результат не всегда бывает идеальным с первой попытки. Однако у такого подхода есть заметные преимущества:

- Модель компактная и требует всего 7–8 ГБ памяти;

- Можно выбирать версию, квантизацию, параметры генерации и поведение ИИ без ограничений со стороны сторонних компаний;

- Обработка данных происходит локально, без передачи информации в Сеть;

- Работа возможна полностью офлайн, без подключения к интернету;

- Не нужны платные подписки.

Несколько рекомендаций по использованию:

- Формируй запрос как можно точнее, модель поддерживает русский язык — только попроси ответить на русском.

- Задавай контекст — указывай роль модели: «ты — юрист», «ты — системный администратор», «ты — редактор». Это заметно улучшает качество ответов.

- Разбивай сложные задачи на шаги — вместо одного длинного запроса лучше задать несколько последовательных — модель работает точнее.

- Подбирай уровень квантизации под задачу. Q4–Q5 — баланс скорости и качества, Q8 — лучшее качество, но выше требования к памяти.

Заключение

llama.cpp — это основа локального запуска ИИ. Этот проект показал: чтобы работать с мощными моделями, не нужны серверы — хватит домашнего компьютера. Сочетание простой архитектуры, поддержки обычных процессоров и видеокарт, а также умного сжатия данных позволило тысячам людей разобраться, как работают нейросети, не выходя в интернет.

llama.cpp не стремится быть самым быстрым или самым удобным решением «из коробки». Его ценность — в прозрачности, полном контроле над инференсом и возможности тонкой настройки под конкретное железо. Именно поэтому он стал основой для множества «обёрток», локальных интерфейсов и ИИ-платформ, а также популярной точкой входа в экосистему LLM для энтузиастов и разработчиков.

Для локальной работы с ИИ через llama.cpp оптимально подходят ПК и рабочие станции, особенно если важны автономность, приватность данных и гибкость настройки. Такие конфигурации хорошо закрывают задачи экспериментов, разработки и персонального инференса.

Если же нужна высокая пропускная способность, масштабирование и инференс на GPU в корпоративных сценариях, более подходящим выбором станет vLLM и серверные multi-GPU решения.

В каталоге DigitalRazor представлены как рабочие станции для локального инференса, так и серверы, рассчитанные на серьёзные ИИ-нагрузки и промышленную эксплуатацию.

DigitalRazor HPC