Подборка серверов для искусственного интеллекта и машинного обучения

Содержание

- Зачем нужны специализированные серверы для ИИ

- Ключевые характеристики серверов для искусственного интеллекта

- Подборка готовых серверов для ИИ и ML

- Облачные GPU-серверы против выделенных

- Применение серверов для ИИ в разных задачах

- Как выбрать сервер для конкретной задачи ИИ

- Программное обеспечение для ML-серверов

- FAQ: ответы на популярные вопросы

- Заключение

Нужна рабочая станция или сервер?

Наши специалисты помогут подобрать оптимальную конфигурацию под ваши задачи — от ИИ и 3D-графики до инженерных расчётов и видеомонтажа.

Раскладываем по полочкам: какие серверы нужны для искусственного интеллекта и машинного обучения, чем они отличаются от классических решений, и на какие характеристики смотреть в первую очередь. От GPU (A100, H100/H200 и RTX-серии) и объёма видеопамяти, до CPU, ОЗУ, хранилища и прочего.

ИИ-нагрузки — не просто тяжёлые вычисления, а отдельная лига, где всё решают ускорители, память, пропускная способность и правильная инфраструктура. Можно запустить нейросеть и на обычном сервере. Но открыт вопрос, как быстро рабочие процессы упрутся в объём VRAM, скорость интерфейсов, и другие ограничения.

Мы более 10 лет собираем серверы и рабочие станции для высоконагруженных задач, включая работу с ИИ. Поэтому можем многое рассказать о подходящем и неподходящем для этого оборудовании. Если тема покажется вам слишком сложной — наши консультанты помогут с выбором. Просто напишите свой вопрос или обрисуйте им задачу.

Типовые решения для ИИ

Зачем нужны специализированные серверы для ИИ

Специализированные серверы для искусственного интеллекта нужны вовсе не потому, что обычный сервер «не умеет в нейросети». Умеет, просто не так хорошо, ведь он «заточен» под другое. При должном усердии можно и гвоздь отвёрткой забить, но зачем? Корень проблемы — другой характер нагрузки, из-за чего у системы другие проблемные места. Глобально всё упирается в скорость доступа к данным и скорости их обработки.

Основные преимущества ИИ-серверов:

- Производительность. Обучение и инференс — это тонны однотипных операций. GPU выполняют их на порядки (!) быстрее CPU, потому что изначально созданы под параллельные вычисления;

- Память и пропускная способность. Модели и батчи данных требуют не просто много памяти, а много быстрой памяти. На CPU часто упор не в сырую вычислительную мощность, а в то, что система просто не успевает «подвозить» данные;

- Масштабирование. Для больших моделей критически важно, чтобы несколько GPU работали как одна команда. Иначе часть времени система просто стоит и ждёт новые данные. Классические серверы и GPU потребительского класса в плане масштабирования ограничены;

- Быстрый ввод/вывод данных. Процесс обучения нейросети требует терабайты данных. Для их хранения и передачи нужны быстрые NVMe-накопители, скоростные RAID-массивы, скоростной сетевой доступ к хранилищам. Иначе снова возникает ситуация, когда GPU простаивают потому, что «данные не ещё не завезли»;

- Питание и охлаждение. Системы с 4–8 GPU — это 3–8 кВт потребления на один ПК. Нужны правильные блоки питания, продуманная топология и грамотная реализация охлаждения;

- Надёжность и предсказуемость. ECC-память, мониторинг, отказоустойчивость, правильные драйверы/прошивки — чтобы обучение внезапно не остановилось на 6-м дне из-за какой-то мелочи;

- Экономия. Да, спецсервер дороже, но большая производительность, надёжность и объёмы памяти делают его более рациональным выбором, если речь идёт о дистанции в несколько лет. Естественно, при условии достаточной загрузки.

| Критерий | Обычный сервер | ИИ-сервер (AI/ML) |

|---|---|---|

| Основная цель | Веб-сервисы, базы данных, виртуализация, файловые сервисы | Обучение и инференс нейросетей, плотный параллелизм |

| Главный ресурс | CPU, RAM, диски | GPU и VRAM (часто 80% стоимости системы) |

| GPU | Часто вовсе нет | 1–8+ ускорителей, иногда с NVLink/NVSwitch |

| CPU | Важен для вычислений и нагрузки приложений | Важен как платформа: PCIe, каналы памяти, I/O, чтобы кормить GPU |

| ОЗУ | Умеренное количество под сервисы, виртуальные машины, базы данных | Большой объём : кеши датасетов, пайплайны, RAG, обслуживание инференса |

| Память ускорителей | Обычно не критична | Критична: модель/контекст/батч должны помещаться в VRAM |

| Хранилище | SATA/SAS/NVMe под БД и файлы | NVMe как горячий слой (датасеты/чекпоинты), HDD как холодный архив |

| Сеть | 1–25 Гбит/c обычно хватает | 25–100+ Гбит/с для кластерного обучения, часто RDMA/RoCE или InfiniBand |

| Межсоединения | PCIe достаточно | PCIe + быстрые GPU-GPU связи (NVLink/NVSwitch) для масштабирования |

| Охлаждение и питание | Умеренные требования | Высокие: много тепла, 4–8 GPU, нужны мощные БП и правильный воздушный поток |

| Надёжность | Важно, но нагрузка чаще пульсирующая | Критично: обучение/инференс 24/7, ECC, мониторинг, стабильные драйверы |

| Масштабирование | Обычно по CPU/RAM/узлам | По GPU (внутри узла и по кластеру), сеть и накопители становятся узким местом |

| Экономика | Оптимизация под стоимость сервиса | Оптимизация под стоимость обучения/запроса, окупаемость при высокой загрузке GPU |

В итоге на обычном сервере и даже игровом компьютере искусственный интеллект тоже запустится. Но специализированный сервер нужен, чтобы выполнять задачу быстро, с возможностью масштабирования, высокой стабильностью и меньшей стоимостью на продолжительной дистанции.

Роль GPU

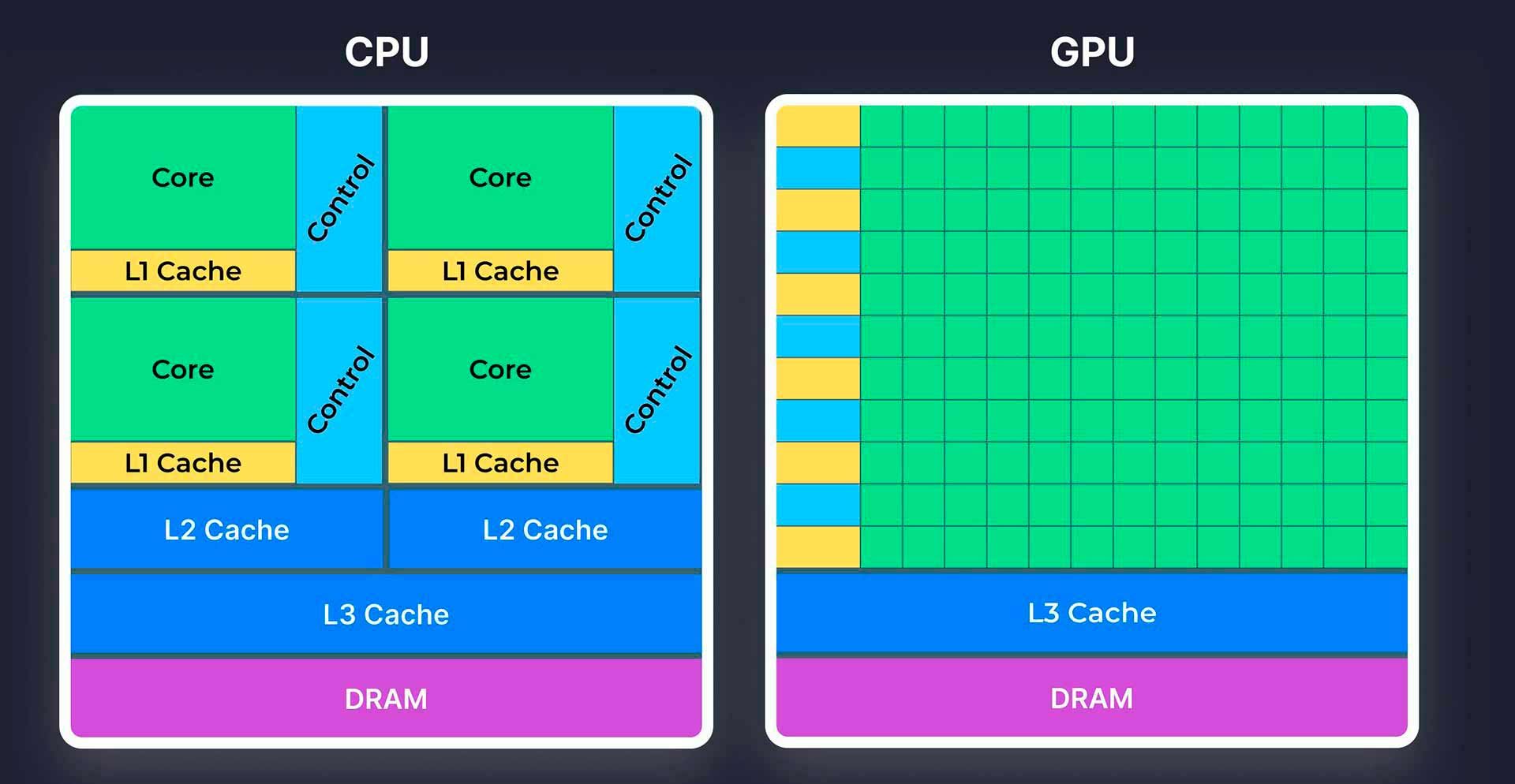

Видеокарта в машинном обучении — это ускоритель, который делает обучение и инференс рациональными по времени и деньгам. Видеокарты нужны не потому, что процессор «плохой», а потому что нейросети — это чистая математика, которая идеально ложится на параллельные вычисления. Развитыми возможностями параллелизма процессор похвастаться не может. Это легко отследить по цифрам: в лучшем случае процессор предложит 192 ядра (AMD EPYC 9965), а видеокарта — 16 896 ядер (NVIDIA H200). Да, CUDA-ядра у карт NVIDIA не такие универсальные и многозначные, но их на несколько порядков больше.

Что именно делает GPU в ML (Machine Learning):

-

Ускоряет матричную математику. Обучение нейросетей почти полностью сводится к умножениям матриц и тензорным операциям (GEMM/conv). GPU имеет тысячи вычислительных ядер и специализированные блоки (tensor-ядра), поэтому выполняет такие операции массово и параллельно. Результат — ускорение в десятки раз по сравнению с CPU в типовых DL-задачах (Deep Learning).

- Держит модель и данные в VRAM. Видеопамять (VRAM) — критический параметр для ИИ-моделей. В ней лежат веса модели, активации, градиенты, состояния оптимизатора и батчи данных. Если VRAM не хватает, система начинает использовать оперативную память и/или накопители, которые медленнее в несколько раз. Поэтому объём видеопамяти часто даже важнее её скорости (она всё равно сильно быстрее ОЗУ) и даже иногда важнее количества GPU.

- Обеспечивает высокую пропускную способность памяти. Для DL важно не только то, сколько сырой вычислительной мощности обеспечивает видеокарта, но и как быстро поступают данные. GPU-память имеет очень высокую пропускную способность, что помогает «кормить» вычислительные блоки без простоев. Особенно на трансформерах, больших батчах и при интенсивном чтении/записи тензоров.

- Масштабирует обучение на несколько ускорителей. Когда один GPU не тянет по видеопамяти или скорости, модель и данные распределяют на несколько GPU.

- Делает инференс дешевле на единицу работы. В продакшене (чат-боты, классификация, рекомендации, CV) GPU ускоряет выдачу ответа и позволяет обслуживать больше запросов на один сервер. Для крупных LLM (Больших языковых моделей) это часто единственный способ получить приемлемое время выдачи.

Обучение и инференс

Обучение (Training) и инференс (Inference) — это два разных режима работы модели, и требования к железу/серверу у них тоже разные.

Машинное обучение — это когда модель учится: прогоняет данные, считает градиенты и обновляет веса. Важные нюансы:

- Нужно гораздо больше памяти, чем кажется. Помимо самих весов модели в памяти хранятся активации, градиенты и состояния оптимизатора (у некоторых моделей их много). Поэтому обучение часто упирается в VRAM раньше, чем в чистую вычислительную мощность.

- Нужна высокая пропускная способность памяти и интерфейс между GPU. Если обучать модель на нескольких GPU, критичны быстрые межсоединения (NVLink/NVSwitch), иначе лишнее время уходит на обмен данными.

- Очень важен I/O (подвоз данных). Если датасеты читаются медленно (диск/сеть/хранилище), GPU простаивают.

- Стабильность важнее пиковых показателей. Обучение может идти сутки, недели. Нужен мониторинг, контроль температур/питания, устойчивые драйверы, чтобы не было «упало на 6-й день».

Инференс — когда модель уже обучена и просто выдаёт ответы: текст, рекомендации, сгенерированные изображения и т. д. Здесь важно:

- Латентность и Throughput. Первое означает время ответа на один запрос, а второе — сколько запросов в секунду сервер обрабатывает. Эти метрики близки, но не одинаковы. Можно настроить сервер на очень быстрые одиночные ответы, или на максимальную пропускную способность.

- VRAM тоже важна, но структура нагрузки другая. Чаще всего главная боль — поместить модель в VRAM полностью и держать нужный контекст/батч. Для LLM-инференса объём VRAM — ключевой параметр.

- Точность вычислений можно ужимать. В инференсе широко используют квантование (INT8/FP8/FP16), чтобы снизить требования к VRAM и поднять скорость. В обучении это тоже бывает, но там больше ограничений.

- Высокая доступность и предсказуемость. Нужны очереди, лимиты, изоляция, автоскейл, кэширование, «тёплые модели» сразу в памяти, чтобы не было лишних задержек.

Ключевые характеристики серверов для искусственного интеллекта

Сервер для искусственного интеллекта — это не просто «железо помощнее». В задачах машинного обучения всё решают узкие места: где модель хранит веса, как быстро подвозятся данные, насколько шустро ускорители обмениваются тензорами, и выдержит ли система долгие недели непрерывной нагрузки без перегрева и сюрпризов. Поэтому выбрать AI-сервер по одной цифре TFLOPS — примерно как выбирать грузовик только по объёму кузова.

GPU-сервер DigitalRazor HPC8000

Разберём ключевые характеристики, которые реально влияют на скорость обучения и инференса: от видеокарт и процессоров до объёма и типа памяти, а также сетевых интерфейсов, хранилищ, питания и охлаждения. Это базовый чек-лист, который помогает понять, где вы потеряете производительность, а за что действительно стоит платить.

Графические ускорители (GPU)

В ИИ-сфере под графическими ускорителями чаще всего подразумевают серверные GPU, но на практике встречаются и не-GPU ускорители (ASIC/TPU/LPU и другие). Не-GPU ускорители — это узкоспециализированные решения, зачастую недоступные рядовым потребителям. Их стезя — крупные вычислительные центры Google, OpenAI, Microsoft, Amazon и других крупных игроков ИИ-рынка. В этой статье сосредоточимся на решениях, которые реально приобрести… хотя бы теоретически.

Сейчас наиболее часто используют ускорители компании NVIDIA. Наиболее распространены NVIDIA A100, H100 и H200, а также профессиональные видеокарты серии RTX. К примеру, RTX 6000 PRO Blackwell. Также энтузиасты экспериментируют с RTX 4090 и RTX 5090 — популярными игровыми видеокартами. У последних действительно мощный графический чип. Однако скромный по меркам ИИ объём видеопамяти вносит свои ограничения.

NVIDIA A100. Классическая «рабочая лошадка» датацентров: подходит и для обучения, и для инференса. Особенно если инфраструктура строилась ещё до эпохи FP8. A100 ценят за сверхбыструю память HBM2e (до 80 ГБ) с высокой пропускной способностью (свыше 2 ТБ/с). Это помогает большим батчам и моделям, где всё упирается в память. A100 вышла почти 5 лет назад, поэтому на фоне современных решений цена гуманная.

NVIDIA H100. Прямой преемник A100. Флагман прошлого поколения, который «заточен» под большие трансформеры и высокую эффективность на современных типах точности. NVIDIA заявляет прирост обучения до четырёх раз относительно решений предыдущего поколения. Отлично подходит для машинного обучения больших моделей, инференса LLM, для работы в кластерах, где важна максимальная производительность на стойку.

H100 на фоне RTX 5090

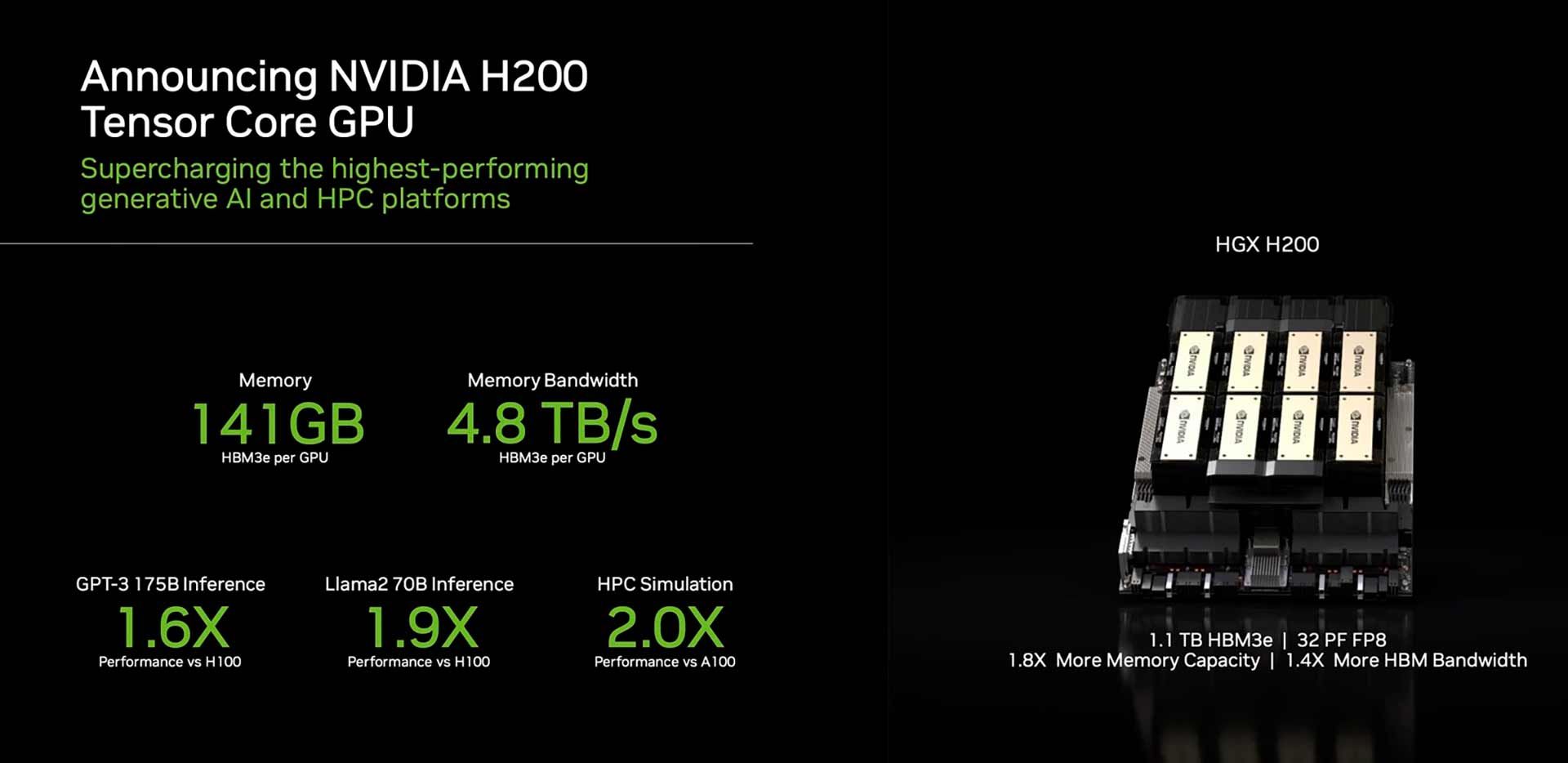

NVIDIA H200. В плане архитектуры не отличается от H100, зато двойной объём видеопамяти. Этот ускоритель ценят за невероятные 141 ГБ памяти с пропускной способностью 4,8 ТБ/с. Это напрямую влияет на размер моделей/контекста/батча без упора в видеопамять.

NVIDIA RTX. Это не «чистые» ИИ-ускорители, а профессиональные решения для рабочих станций для видеомонтажа, разработки игр, архитектурных задач и т. д. К примеру, RTX 6000 Ada и RTX PRO 6000 Blackwell. Номинально они не предназначены для ИИ-задач, но старшие версии за счёт мощного ядра, быстрой памяти и немаленького её объёма вполне применяются и в ИИ-сфере. Часто их используют, когда нужен инференс + визуальные задачи, или когда важнее универсальность и доступность, чем абсолютный пик производительности.

NVIDIA GeForce RTX (не путать с просто RTX). Относятся к игровой линейке GeForce. Применяются по принципу «на безрыбье и рак рыба». Ключевое преимущество — низкая стоимость сравнительно с профильными решениями. Ключевой недостаток — чрезмерно крупные габариты, что мешает установке нескольких видеокарт в одну систему, а также небольшой объём видеопамяти. 32 ГБ в RTX 5090 выглядят откровенно хило на фоне 80 ГБ у той же NVIDIA H100.

| Параметр | NVIDIA A100 | NVIDIA H100 | NVIDIA H200 |

|---|---|---|---|

| Класс | Дата-центры | Дата-центры | Дата-центры |

| Архитектура | Ampere | Hopper | Hopper |

| Память | 80 ГБ HBM2e | 80 ГБ HBM3 | 141 ГБ HBM3e |

| Пропускная способность памяти | 2,04 ТБ/с | 3,35 ТБ/с | 4,8 ТБ/с |

| МежGPU-связь | NVLink до 600 ГБ/с | NVLink до 900 ГБ/с | NVLink до 900 ГБ/с |

| FP8 для тензорных операций | Нет | Да | Да |

| Энергопотребление | 400 Вт | до 700 Вт | до 700 Вт |

Центральные процессоры

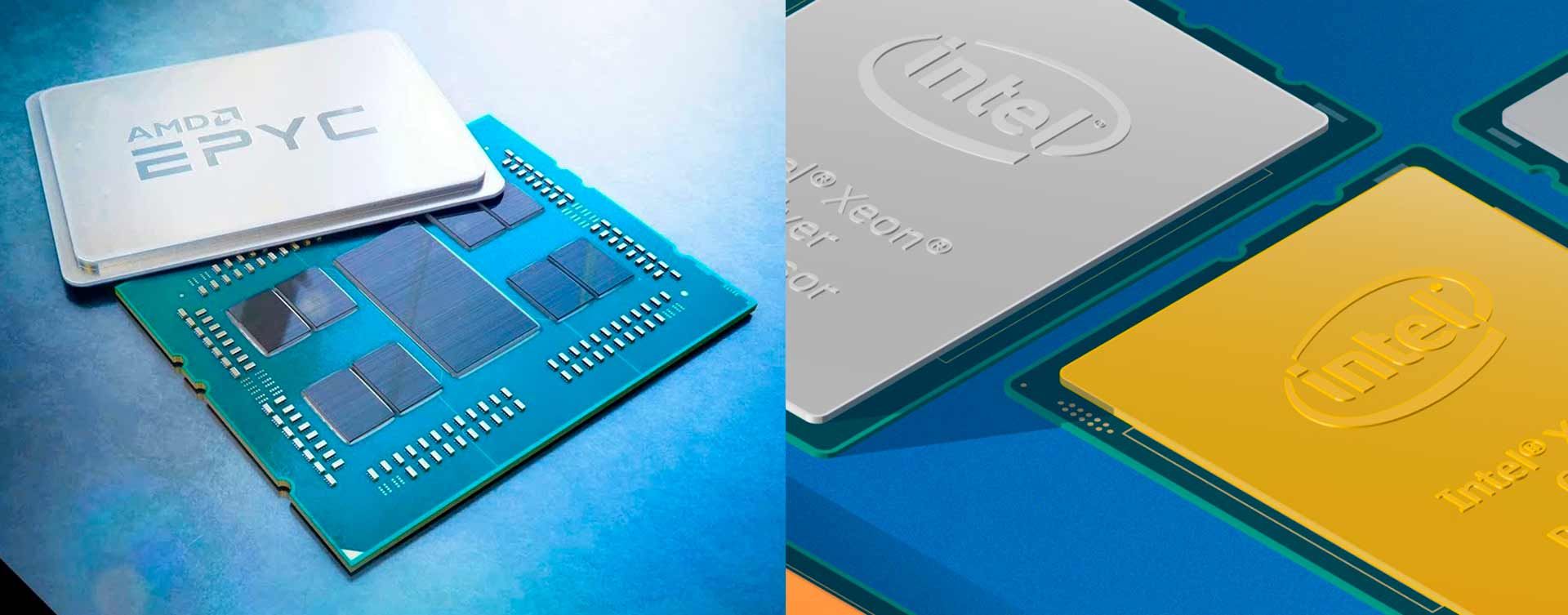

В ИИ-серверах мощность процессора на втором плане. В первую очередь процессор обеспечивает платформу: необходимое количество линий интерфейса PCI-Express для связи с видеокартами, количество каналов для оперативной памяти и максимально поддерживаемый объём, а также связь с накопителями. Задача процессора — «кормить» видеокарты. CPU влияет на подачу данных, токенизацию/препроцессинг, I/O, сетевые операции и общий throughput инференса. То есть это не главный фактор, но и не «почти не важно». Зачастую в ИИ-серверах применяются те же модели, что и в обычных.

Intel Xeon Scalable. Популярный выбор для GPU-серверов в ЦОД корпоративного класса. До 144 ядер, 96 линий PCI-Express, работа с памятью в 12-канальном режиме.

AMD EPYC. Очень частый вариант в AI-узлах, особенно когда нужно много ядер, памяти и интерфейсов под несколько GPU. AMD прямо позиционирует EPYC как CPU для дата-центров и AI-нагрузок. Предлагают до 192 ядер, 128 линий PCI-E 5.0, 12-канальный контроллер памяти.

| Что важно в AI-узле | AMD EPYC 9005 Turin | Intel Xeon 6 P-cores Granite Rapids пример Xeon 6980P | Практический смысл для ИИ |

|---|---|---|---|

| Роль CPU | Платформа и подача данных для GPU, плюс I/O и память | Платформа и подача данных для GPU, плюс I/O и память, плюс CPU-ускорение AI-операций AMX AVX-512 | CPU редко главный вычислитель, но легко становится узким местом по данным, шине и памяти |

| PCIe под GPU | 128 линий PCIe Gen5 | 96 линий PCIe 5.0 | Больше линий, проще разместить много GPU, быстрый NVMe и Сеть без компромиссов |

| I/O в двухсокетных системах | 160 линий для 2-сокетных систем | 192 линий для 2-сокетных систем | Важно для узлов с 4–8 GPU, плюс много NVMe |

| Каналы памяти | 12 каналов DDR5-6400 для серии | 12 каналов DDR5-6400 | Для пайплайна данных и RAG полоса памяти часто важнее частоты CPU |

| Максимум RAM на сокет | До 6 ТБ | До 3 ТБ | Потолок RAM важен для больших кэшей индексов и тяжёлого препроцессинга |

| CXL | CXL 2.0 | CXL 2.0 | Полезно для расширения и шаринга памяти, но зависит от платформы |

| Когда EPYC удобнее | Много GPU, много NVMe, высокий потолок RAM | ---------------------------- | Обычно выбирают как сильную и простую платформу под I/O и память |

| Когда Xeon 6 удобнее | ---------------------------- | Инференс на CPU и тяжёлый препроцессинг, плюс выгода от AMX AVX-512 и MRDIMM | Может помочь там, где часть нагрузки остаётся на CPU и важна полоса памяти |

Также в серверах для нейросетей применяются и узкоспециализированные чипы, такие как NVIDIA Grace и Ampere Altra и другие на архитектуре ARM. Обычно они встречаются в специализированных платформах и облачных/корпоративных решениях, где важны энергоэффективность и определённая архитектура системы. В большинстве типовых AI-сборок выбор всё равно сводится к Xeon или EPYC. Они не только проще в интеграции и обслуживании, но и доступнее.

Оперативная память

Оперативная память (RAM) в AI-сервере влияет на скорость обучения и инференса, потому что именно через RAM проходят данные, кэши и часть рабочих структур пайплайна. GPU выполняет математику, но RAM помогает не оставлять GPU голодным.

VRAM определяет, какая модель вообще поместится в GPU, а RAM определяет, насколько быстро и стабильно система будет обеспечиваться данными.

Память отвечает за:

- Датасеты и Input pipeline. Загрузка, распаковка, декодинг, аугментации, токенизация, формирование батчей — всё это активно использует RAM. Если памяти мало, видеокарта начинает чаще обращаться к диску, что станет потерей времени.

- Кэши и ускорение I/O. В ML типично держать в памяти кэш обработанных данных (например, уже декодированные изображения), кэш токенов/эмбеддингов и кэш файловой системы. Больше RAM = меньше мелких операций чтения с диска и выше стабильность скорости.

- Хост-память для инференса и RAG. В проде память съедают веб-сервис, очереди, батчинг, индексы (векторная БД/поиск) и промежуточные результаты. Для RAG и аналитики это часто ключевой ресурс. RAG (Retrieval-augmented generation) — генерация, дополненная поиском.

- Связка CPU и GPU. Когда VRAM не хватает или нужно оптимизировать стоимость, иногда используют техники, которые опираются на хост-память (частичное размещение весов/кэшей, свопинг, подкачка в ОЗУ). Это работает, но резко повышает требования к RAM и её пропускной способности.

Важные параметры:

- Ключевое — объём. Нехватка оперативной памяти убивает производительность намного сильнее, чем низкая частота;

- Пропускная способность. Складывается из частоты работы и количества каналов памяти;

- Поддержка ECC (код коррекции ошибок). Процесс обучения и инференс очень не любят битовые ошибки памяти;

- Тайминги оперативной памяти. Практически не имеют значения, поскольку слабо влияют на итоговую пропускную способность.

Практические ориентиры:

- Инференс одного сервиса/небольшие пайплайны: 64–128 ГБ;

- Обучение + тяжёлый препроцессинг/кэширование: 256 ГБ и выше;

- Multi-GPU серверы, большие датасеты, RAG + сервисы: 512 ГБ–1 ТБ и выше.

Добавим, что при ограниченном бюджете нередко используют подход с упором на оперативную память. Условные 100 ГБ ОЗУ обойдутся дешевле, чем видеокарта со 100 ГБ видеопамяти. Однако этот метод сильно сказывается на производительности.

Системы хранения данных

Система хранения в AI-сервере — важный элемент системы. Можно купить мощные GPU, но если данные читаются медленно, ускорители будут простаивать, а обучение/инференс станет дорогим и мучительным.

Глобально хранение данных в контексте серверов для искусственного интеллекта можно разделить на две области:

Холодное хранение. Для архивов, версий дата-сетов, бэкапов, и технических данных, что не потребуются в ближайшее время (скорость доступа к которым не так важна). Как правило, используют HDD-накопители, которые отличаются низкой стоимостью за гигабайт. Здесь ключевое — объём и цена. Всё остальное не имеет значения.

Горячее хранение. Для файлов, к которым система часто обращается. Это датасеты для обучения (картинки, видео, текст, логи), чекпоинты и веса моделей, индексы, документы, векторные базы, журналы запросов. Здесь в первую очередь важна скорость доступа.

Обычно в ИИ-серверах используют такую схему:

- Операционная система и контейнеры — отдельный быстрый SSD;

- Датасеты/кэш/временные файлы — отдельный быстрый SSD или RAID-массив из нескольких SSD;

- Старые датасеты/архивные данные, бэкапы и прочее «холодное» — массив из HDD-накопителей, отдельный файловый сервер или облачное хранилище.

| Тип накопителя | Типичные скорости | Для чего уместно в ИИ-сервере | Комментарий |

|---|---|---|---|

| NVMe SSD PCIe 4.0 | сотни тысяч – 1+ млн IOPS, низкая задержка | горячие датасеты, кеш, временные файлы, чекпоинты, локальный слой для обучения | базовый выбор для скорости и параллельного доступа |

| NVMe SSD PCIe 5.0 | 1–3+ млн IOPS, очень низкая задержка | то же, но когда упираетесь в I/O, и нужно больше полосы на узел | дороже и горячее, нужна хорошая платформа и охлаждение |

| Enterprise NVMe SSD | выше стабильность IOPS под длительной нагрузкой | прод 24/7, интенсивная запись чекпоинтов, базы, индексы, RAG | плюс в ресурс записи DWPD и предсказуемости, а не только в пиковых цифрах |

| SATA SSD | десятки–сотни тыс. IOPS, задержка выше NVMe | ОС, сервисы, логи, нетяжёлые рабочие данные | ок для системного диска, но слабее для обучения больших датасетов |

| HDD | очень низкие IOPS, высокая задержка | холодное хранение, архивы датасетов, бэкапы, долгие логи | не годится как рабочий слой для обучения или RAG без кеша на SSD/NVMe |

Сетевая инфраструктура

Продвинутая сетевая инфраструктура нужна по тем же причинам, что и всё остальное — чтобы GPU не простаивали. На начальных этапах это не имеет значения, но с ростом масштабов (количества видеокарт в одном сервере, далее серверов в стойках, стоек в кластере и т. д.) пропускная способность Сети становится таким же ресурсом, как и память.

Основные задачи Сети:

- Распараллеливание (распределённое обучение, multi-node training). Градиенты, параметры, тензоры постоянно гоняются между узлами. Если Сеть медленная или с высокой задержкой — рост количества GPU почти не ускоряет обучение.

- Общий доступ. Датасеты, чекпоинты, артефакты пайплайна и модели часто лежат в облаке или на отдельном сервере-хранилище. Слабая Сеть = «голодный» загрузчик данных = простаивающие GPU.

- Инференс. Запросы, батчинг, межсервисные вызовы, RAG (поиск/векторная БД), репликация — всё это про Сеть и стабильную задержку.

В небольших масштабах используется сетевой интерфейс Ethernet. Он привычный, есть много доступного оборудования, его легко интегрировать в корпоративную Сеть, пропускной способности достаточно. Для действительно больших моделей нейросетей и их обучения нужен соответствующий кластер. В таких случаях выбирают интерфейс InfiniBand.

Для полноты картины стоит упомянуть межсоединения — связь между процессором и видеокартой, а также между самими видеокартами. В серверах начального и среднего уровня для связи используют обычный интерфейс PCI-Express. В случае продвинутых серверов на базе специализированных ускорителей задействуют NVLink/NVSwitch. Это технология NVIDIA, которая особенно хорошо себя показывает в случаях больших масштабов.

Подборка готовых серверов для ИИ и ML

DigitalRazor Rackstation AI. Универсальный сервер для искусственного интеллекта, графики и VFX. Платформа на базе процессора AMD Threadripper PRO. Поддержка до двух ускорителей любого класса — от RTX 5090 до NVIDIA H200. Возможен монтаж в стойку или вертикальное размещение.

DigitalRazor Rackstation Devbox AI. Специализированный сервер для ИИ и высоконагруженного рендеринга. Платформа на базе процессора AMD Threadripper PRO. Поддержка до шести ускорителей RTX 6000 Ada или 4-х RTX 5090 / H200 NVL.

DigitalRazor Scale. Архитектура с высоким потенциалом масштабирования под растущие нагрузки. Платформа на базе двух процессоров AMD EPYC 9005-й серии. Поддержка до восьми ускорителей RTX 5090, RTX 6000 Pro Blackwell или W7900.

DigitalRazor HPC. Платформа на базе двух Intel Xeon / AMD EPYC. Гибкая конфигурация плотности: от четырёх (2U) до восьми (4U) ускорителей H200 / L40S. Поддержка технологий NVLink и InfiniBand.

Облачные GPU-серверы против выделенных

Выбор между облаком и выделенным GPU-сервером — это не про что мощнее, а про что выгоднее и удобнее под конкретную задачу. Облако даёт быстрый старт и простое масштабирование, а собственный (или dedicated) сервер — стабильность, контроль и лучшую экономику при постоянной работе.

| Сценарий | Что важно в первую очередь | Типовая конфигурация | Где чаще всего упирается |

|---|---|---|---|

| Прототипы и эксперименты | Быстрый старт, гибкость | 1 GPU, 64–128 ГБ RAM, NVMe | Нехватка VRAM и время обучения |

| Дообучение модели fine-tune | VRAM и стабильность | 1–2 GPU, 128–256 ГБ RAM, быстрый NVMe | VRAM, скорость диска при датасетах |

| Обучение с нуля | Масштабирование, межGPU связь, I/O | 4–8 GPU, много RAM, NVMe-пул, 100GbE+ | Сеть GPU меж GPU, скорость хранилища, сеть между узлами |

| Инференс в проде | Латентность и throughput, надёжность | 1–4 GPU, 128–512 ГБ RAM, NVMe, хорошая сеть | VRAM, батчинг, CPU и сеть под запросы |

| RAG и поиск по документам | RAM, NVMe, сеть, CPU | 1–2 GPU, 256–1024 ГБ RAM, NVMe, быстрый CPU | RAM под индекс, IOPS, задержки сети |

Преимущества аренды облачного GPU-сервера

- Быстрый старт. Не нужно покупать железо и ждать поставку — запустил и работаешь;

- Простое масштабирование. Можно временно взять больше GPU под машинное обучение или пик инференса;

- Оплата по факту. Оплата за часы/дни использования — удобно для экспериментов и разовых задач;

- Гибкий выбор железа. Легко переключаться между типами GPU и объёмом VRAM под разные модели;

- Меньше инфраструктурной боли. Питание, охлаждение, стойки, обслуживание железа — не твои проблемы;

- Быстрая итерация. Удобно гонять много тестов параллельно (несколько инстансов под разные гипотезы);

- Простая география. Можно развернуть вычисления ближе к данным/пользователям, чтобы снизить задержки.

Когда выгоднее собственный сервер

- Нагрузка постоянная. GPU работают почти каждый день или много часов в месяц — аренда по часам начинает стоить дороже;

- Есть 24/7 инференс. Сервис должен быть всегда онлайн, важна предсказуемая задержка и стабильный Throughput;

- Большие датасеты и дорогой трафик. Постоянно гонять терабайты в облако/из облака больно по деньгам и времени;

- Полный контроль. Безопасность, изоляция, compliance, свой стек, свои версии драйверов/фреймворков;

- Конкретная конфигурация. Много VRAM, быстрый NVMe-пул, специфическая Сеть — никаких компромиссов;

- Если планируешь сделать кластер. Выгоднее строить инфраструктуру под себя и расширять её по мере необходимости;

- Важно избежать дефицита/квот. Чтобы нужные GPU были всегда, а не как повезёт.

- Геополитическая независимость. Невозможен вариант, что сервер «отрубят» по внешним причинам.

Применение серверов для ИИ в разных задачах

Серверы для искусственного интеллекта используют там, где нужны ускорители (GPU), много памяти и быстрый ввод-вывод, потому что обычные серверы быстро упираются в скорость обработки данных и масштабирование.

Обучение нейронных сетей

В обучении нейросетей такие серверы помогают быстрее прогонять большие датасеты, делать fine-tuning и регулярно переобучать модели. Здесь критичен объём видеопамяти, пропускная способность памяти и стабильность работы при длительной нагрузке.

Компьютерное зрение

В сфере компьютерного зрения серверы нужны для обработки потоков с камер: детекция, сегментация, трекинг, контроль качества и видеоаналитика. Важны высокая производительность инференса, низкая задержка и способность параллельно обслуживать много потоков.

Обработка естественного языка (NLP)

В NLP AI-серверы нужны для чат-ботов, суммаризации, классификации, поиска по документам и выполнения RAG-сценариев. Здесь особенно важны объём видеопамяти, скорость выдачи ответа и стабильный Throughput.

Генеративный ИИ

В генеративном искусственном интеллекте серверы используются для генерации текста, изображений, видео и аудио, а также для обслуживания больших языковых моделей в проде. Часто именно GPU определяет, какой размер модели и контекст получится запустить без компромиссов.

Data Science и аналитика

В Data Science (работе с большими данными) и аналитике такие серверы полезны для ускорения тяжёлых расчётов, экспериментов и иногда для AutoML. Но часть задач может эффективно жить и на CPU — всё зависит от конкретного пайплайна и объёма данных.

Как выбрать сервер для конкретной задачи ИИ

Начинать следует с постановки задачи: что именно вы делаете: обучение с нуля, дообучение (fine-tune) или инференс в проде. Какой размер модели и какой нужен SLA по скорости/задержке. От этого зависит, во что упрётесь: в видеопамять, в пропускную способность, в сеть или накопители.

Дальше нужно оценить вычислительные потребности. Для обучения важны GPU-часы и возможность масштабирования на несколько ускорителей. Для инференса — целевая задержка, количество выдаваемых запросов/токенов в секунду. На этом шаге обычно становится понятно, нужен ли один мощный узел, несколько GPU в одном сервере или уже кластер.

Отдельно считают видеопамять. Важно, чтобы модель и рабочие структуры (батч/контекст/кэши) помещались в VRAM. Иначе придётся урезать качество, квантовать, уменьшать контекст или уходить в распределение по нескольким GPU. Для LLM это самый частый ограничитель, поэтому VRAM часто важнее сырой мощности.

Потом проверяют масштабируемость решения. Если планируется рост — выбирают платформу, где можно добавить GPU/узлы без перепроектирования: достаточно PCIe-линий, места под NVMe, нормальная Сеть (минимум 25–100 Гбит/с, а для кластерного обучения ещё больше) и понятная топология. Это защищает от ситуации, когда купили сервер, через месяц он стал тупиком.

В финале балансируют инфраструктуру вокруг GPU: CPU (чтобы кормить ускорители данными), RAM (кэши, пайплайн), быстрые NVMe (датасеты/чекпоинты) и сеть/хранилище. Правило простое: GPU выбирают под модель нейросети, а всё остальное — чтобы GPU не простаивали.

Если такой объём работы и планирования пугает, обратитесь к нашим консультантам. Они помогут подобрать правильный ИИ-сервер под конкретную задачу. Кроме того, у нас есть возможность протестировать сервер перед покупкой. Чтобы вы точно понимали, что он вам подходит и решает ваши проблемы.

Программное обеспечение для ML-серверов

Операционные системы

Для ML-серверов чаще всего выбирают Linux: он лучше подходит для работы с GPU-драйверами, проще автоматизируется и стабильнее в нагрузке 24/7. Важно, чтобы ОС дружила с нужными версиями драйверов и библиотек (CUDA/ROCm), потому что в ИИ-инфраструктуре «не та версия» — частая причина потерь производительности и головной боли при обновлениях.

Фреймворки

TensorFlow и PyTorch — два основных инструмента для обучения и инференса нейросетей. PyTorch обычно любят за гибкость и удобство в исследованиях и прототипировании. TensorFlow — за зрелую экосистему и продакшен-инструменты. Keras — это высокоуровневый интерфейс, который упрощает сборку моделей и ускоряет разработку, чаще всего его используют поверх TensorFlow, когда важны скорость разработки и читаемость кода.

Контейнеризация и оркестрация

Контейнеризация (обычно с помощью Docker) помогает фиксировать окружение: версии библиотек, драйверов и зависимостей, чтобы модель одинаково запускалась на любом сервере. Это резко снижает риск ситуации «у меня работает, а у тебя — нет».

Оркестрация (например, Kubernetes) нужна, когда задач много: она распределяет нагрузки, масштабирует сервисы, управляет обновлениями и позволяет эффективно делить GPU-ресурсы между командами и проектами. В итоге ML-сервер превращается из одного мощного компьютера в управляемую платформу для обучения и продакшена.

FAQ: ответы на популярные вопросы

Заключение

ИИ-сервер — это не самый мощный компьютер, а сбалансированная и выверенная система, где всё крутится вокруг GPU и видеопамяти. А CPU, RAM, накопители и Сеть нужны, чтобы ускорители не простаивали. Если модель влезает в VRAM и данные поступают без задержек — обучение и инференс идут быстро, стабильно и предсказуемо.

Перед покупкой стоит честно ответить себе на три вопроса:

- Что вы делаете: обучение, дообучение или инференс?

- Какого масштаба модели и нагрузка?

- Планируется ли рост?

А дальше всё просто: подбираете конфигурацию под задачу, или используете облако для тестов, или берёте выделенный сервер, если GPU будут работать постоянно. Если не хочется разбираться во всех нюансах, наши консультанты помогут выбрать правильное решение и собрать конфиг без лишних переплат.