Multi-GPU в 2026: где и зачем нужны несколько видеокарт?

Содержание

Ищете идеальный компьютер?

Мы поможем подобрать ПК под игры, работу или учебу.

Разбираемся, что такое Multi-GPU, когда оно даёт ускорение, а где это совершенно бесполезная вещь. На что смотреть при сборке, чтобы видеокарты работали в одной команде, а не просто грели воздух. Затронем тему нескольких видеокарт в играх, рабочих станциях и специализированных GPU-серверах для задач искусственного интеллекта.

Для тех, кто предпочитает видеоформат, есть ролик о Multi-GPU на нашем Youtube-канале. Ниже — расширенная версия с кучей дополнительной информации, графиками, таблицам, пояснениями и другими полезными моментами.

Историческая справка

Если не хотите погружаться в эволюцию технологии Multi-GPU — смело переходите к следующему разделу. Но в небольшой исторической справке мы максимально старались не «душнить» и отметили лишь ключевые вехи, разбавленные интересными фактами и действительно необычными видеокартами.

Рассвет

Идея улучшить производительность путём увеличения количества вычислительных устройств лежит на поверхности. Ведь удвоить быстродействие процессора можно добавлением второго ядра. Поэтому неудивительно, что работа в этом направлении началась сразу после того, как видеокарты научились делать что-то большее, чем просто выводить текст на чёрно-зелёный экран.

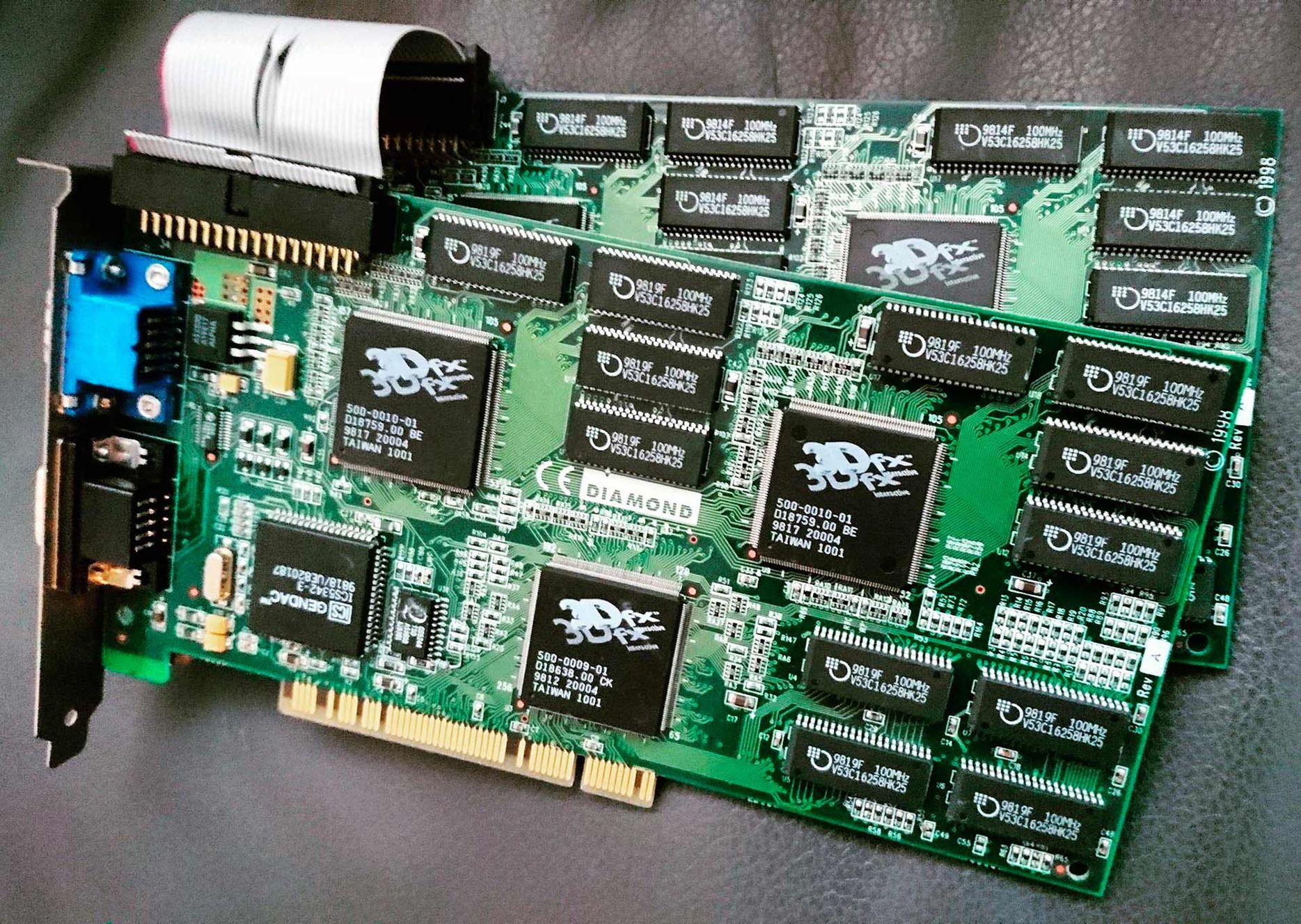

Первопроходцем была компания 3dfx c технологией SLI в 1998 году. Подобные разработки было и до, но именно 3dfx довела технологию до работоспособности. SLI предполагала совместную работу двух чипов над формированием изображения построчно. Нечётные строки обрабатывает GPU1, а чётные — GPU2. В итоге только SLI-система позволяла физически выводить изображение с разрешением 1024×768, что в то время было невероятным достижением.

Diamond Monster 3D II (12 МБ) — лучшее, что можно было купить за деньги в 1998-м

Особого распространения этот подход не получил из-за отсутствия сразу двух разъёмов для видеокарт у большинства материнских плат и очевидной дороговизны. 3dfx попробовала исправить этот недостаток реализацией SLI прямо на плате видеокарты, ещё и не с двумя, а с четырьмя GPU!

Но видеокарт Voodoo5 6000 было выпущено всего 200 штук, из которых половина оказались нерабочими. А годом позже всю 3dfx с её технологиями и вовсе купила компания NVIDIA.

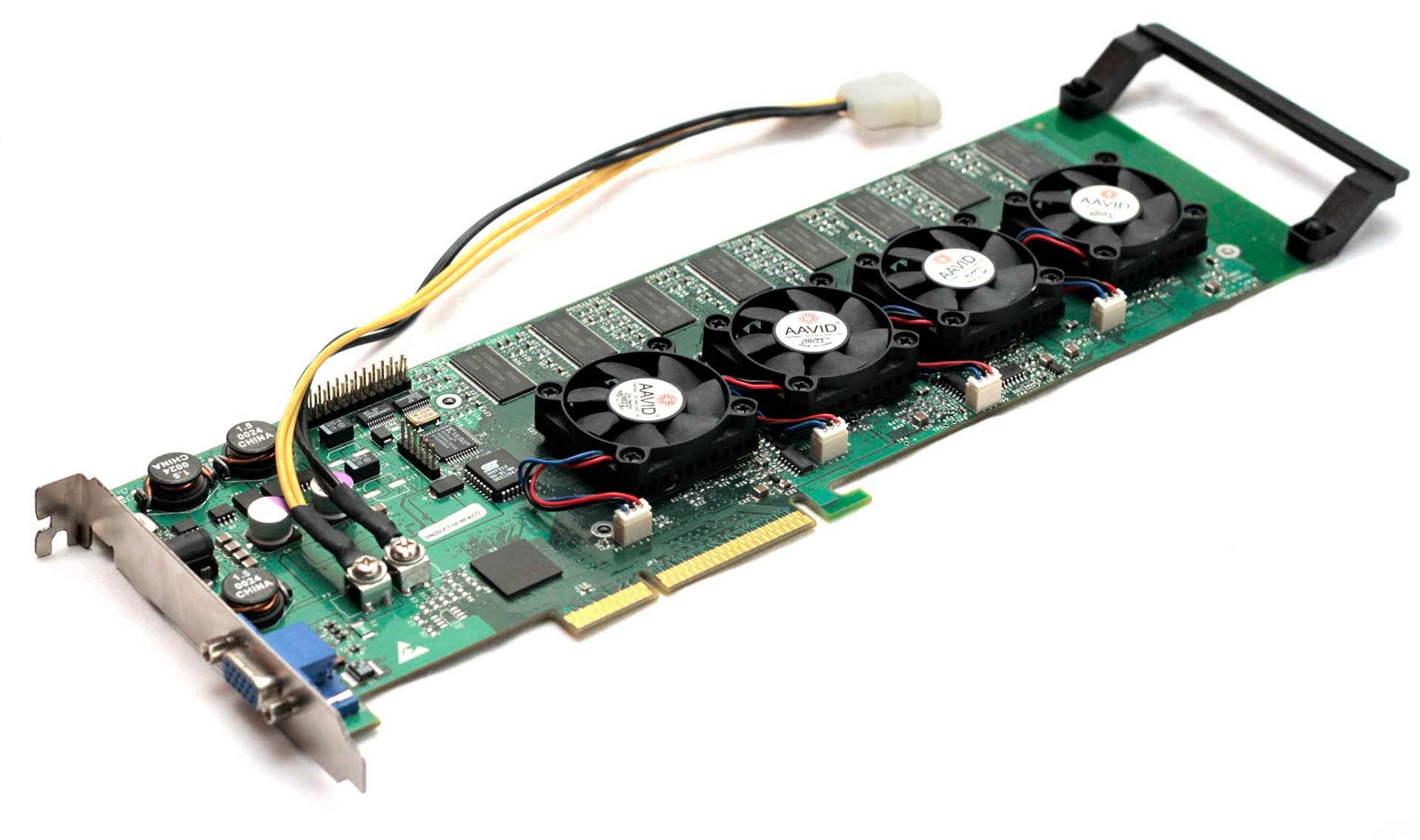

Voodoo5 6000 — самая бракованная видеокарта в истории

Интересный факт

Сейчас Voodoo5 6000 — самая желанная видеокарта у коллекционеров из всех существующих. Экземпляры на eBay появляются очень редко, а цены переваливают за 15 000 долларов. И это за нерабочие образцы!

Становление

После покупки 3dfx NVIDIA разработку не забросила, но переименовала. Точнее, сменила расшифровку:

- Было: SLI (Scan Line Interleave — чередование строчек);

- Cтало: SLI (Scalable Link Interface — масштабируемый интерфейс).

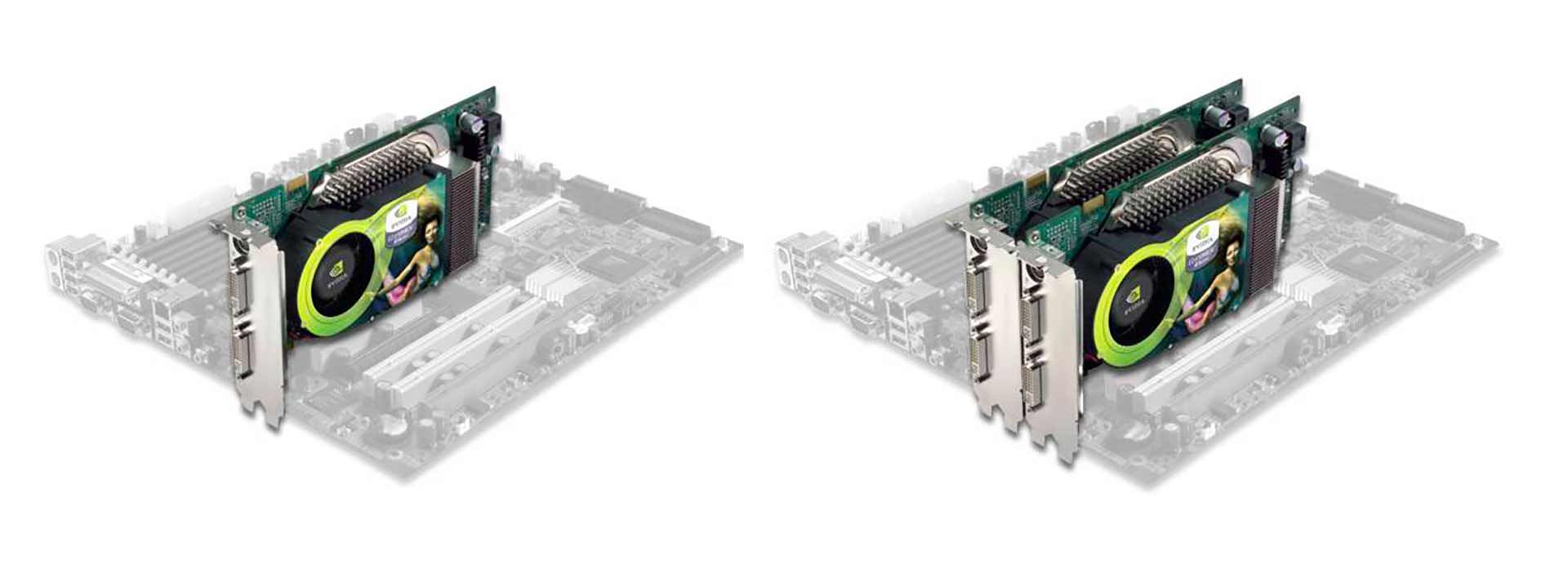

SLI глазами NVIDIA в 2006-м

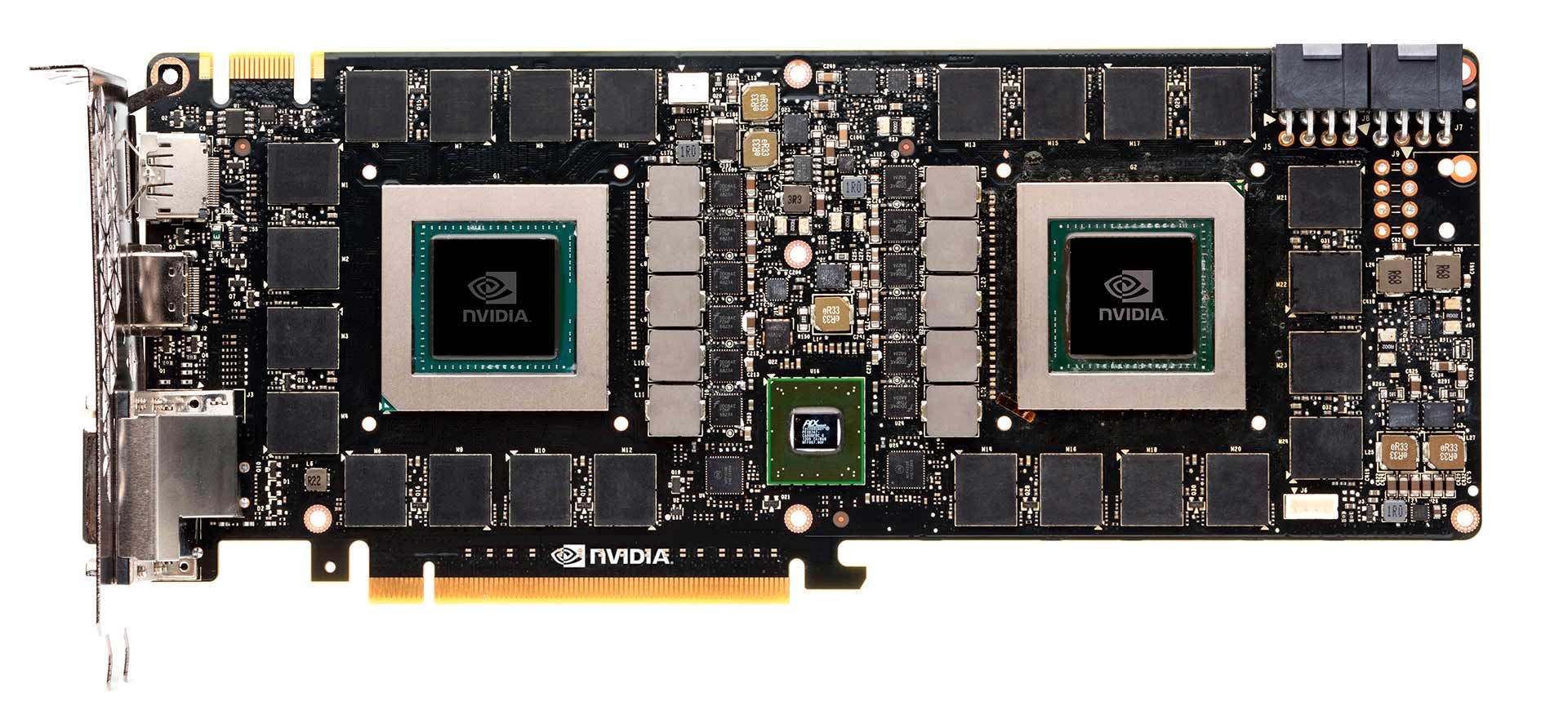

Начиная с 2004 и вплоть до 2018 года компания активно работала над поддержкой SLI. NVIDIA выпускала SLI-профили для каждой игры, а также продавала специальные SLI-мостики для объединения видеокарт. Флагманская модель часто была двухчиповая (GeForce GTX 295, GTX 590, GTX 690, GTX Titan Z), где оба графических чипа и двойной набор видеопамяти распаивали прямо на одной плате под одним кулером.

Поразительно, но когда-то двум видеокартам хватало одного вентилятора

Определённую популярность технология снискала, но только в узких кругах энтузиастов. Пользователи могли купить две видеокарты среднего класса вместо одной топовой (условно, пару RTX 5070 вместо одной RTX 5080), что иногда позволяло сэкономить и получить больше производительности. К тому же это открывает простор для апгрейда: купил карту, а через время купил вторую.

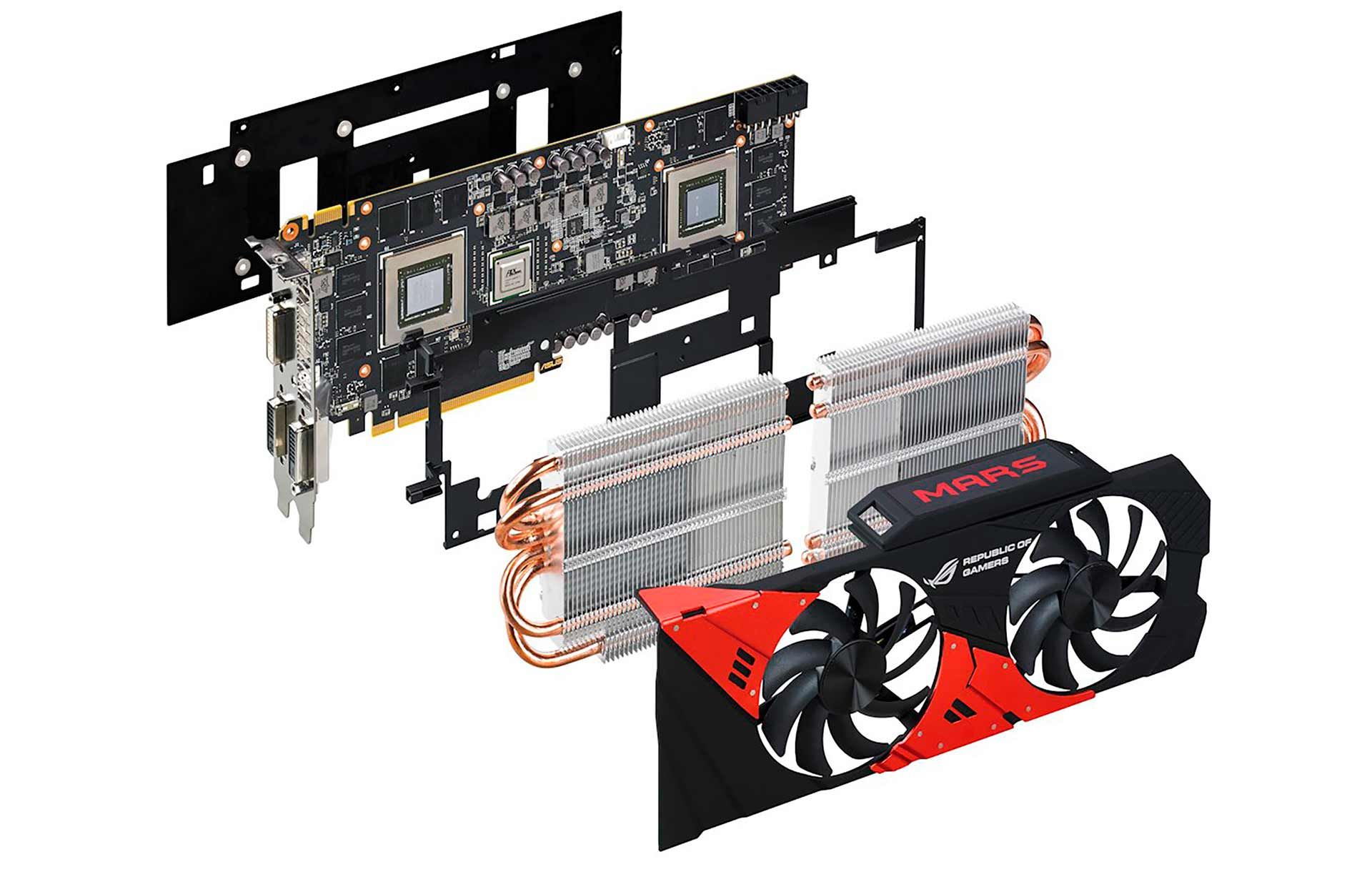

Отдельного упоминания заслуживают «франкеншейны» по типу ASUS ROG MARS 760, где на одной плате была пара GTX 760. Можно понять выпуск убер-флагмана, где на одной плате две топовых видеокарты (вроде GTX 690). Можно понять объединение пары отдельных GTX 770. Но зачем кому-то нужны две откровенно бюджетные видеокарты в одной — совершенно непонятно.

ASUS ROG MARS 760: когда одна голова — хорошо, а две… мутант какой-то

Интересный факт

Больше всего «двуглавые» карты запомнились… феноменальной ненадёжностью. Нередко они выходили из строя прямо во время тестов в ходе подготовки обзоров. Особенно «отличилась» GTX 690. Отчасти это связано с высокими температурами, ведь чисто технически это были две видеокарты в одной. Частично — с внедрением бессвинцового припоя.

Закат

SLI недавно отметила первый юбилей «смерти». Начиная с 1 января 2021 года NVIDIA перестала выпускать специальные SLI-профили, без которых две карты вообще не могли трудиться сообща в играх. NVIDIA переложила работу по синхронизации двух GPU на плечи разработчиков игр. Дескать, нынче API продвинутые пошли, а вы свою игру лучше знаете, так что давайте-ка сами. Нетрудно догадаться, что разработчикам лишние трудозатраты совершенно ни к чему.

RTX 3090 Ti — последние видеокарты с поддержкой SLI

С появлением низкоуровневых графических API, таких как DirectX 12 и Vulkan, разработчики игр могут реализовать поддержку SLI непосредственно внутри самой игры. Вместо того, чтобы полагаться на профиль SLI в драйвере. Знание разработчиками их собственного кода позволяет им добиться максимальной производительности от нескольких графических процессоров.

— выдержка из пресс-релиза NVIDIA.

Причины отказа от SLI

- Низкая популярность. Технологию использовали менее 1% геймеров;

- Сложность реализации. Чтобы две видеокарты реально ускоряли игру, нужна поддержка в движке и драйверные профили. Это постоянная работа под каждую игру;

- Нерационально. Это только «на бумаге» две средние карты выглядит лучше одной топовой. На практике всё наоборот;

- Высокое энергопотребление. А также шум и нагрев. Из-за этого проблемы с надёжностью;

- Качество ощущений. Средней FPS действительно рос, но просадок и микрофризов становилось больше;

- Обратный эффект. Иногда вторая видеокарта только мешала;

- Мало видеопамяти. В случае использования для игр память не суммируется.

Что же AMD?

До этого мы говорили только про SLI от NVIDIA, но у AMD Radeon есть прямой аналог — CrossFireX (не путать с одноимённой игрой). От SLI практически ничем не отличается, и страдает теми же проблемами. В настоящее время не поддерживается. Точнее, «заморожена», но по факту похоронена. Так что ограничимся небольшим упоминанием.

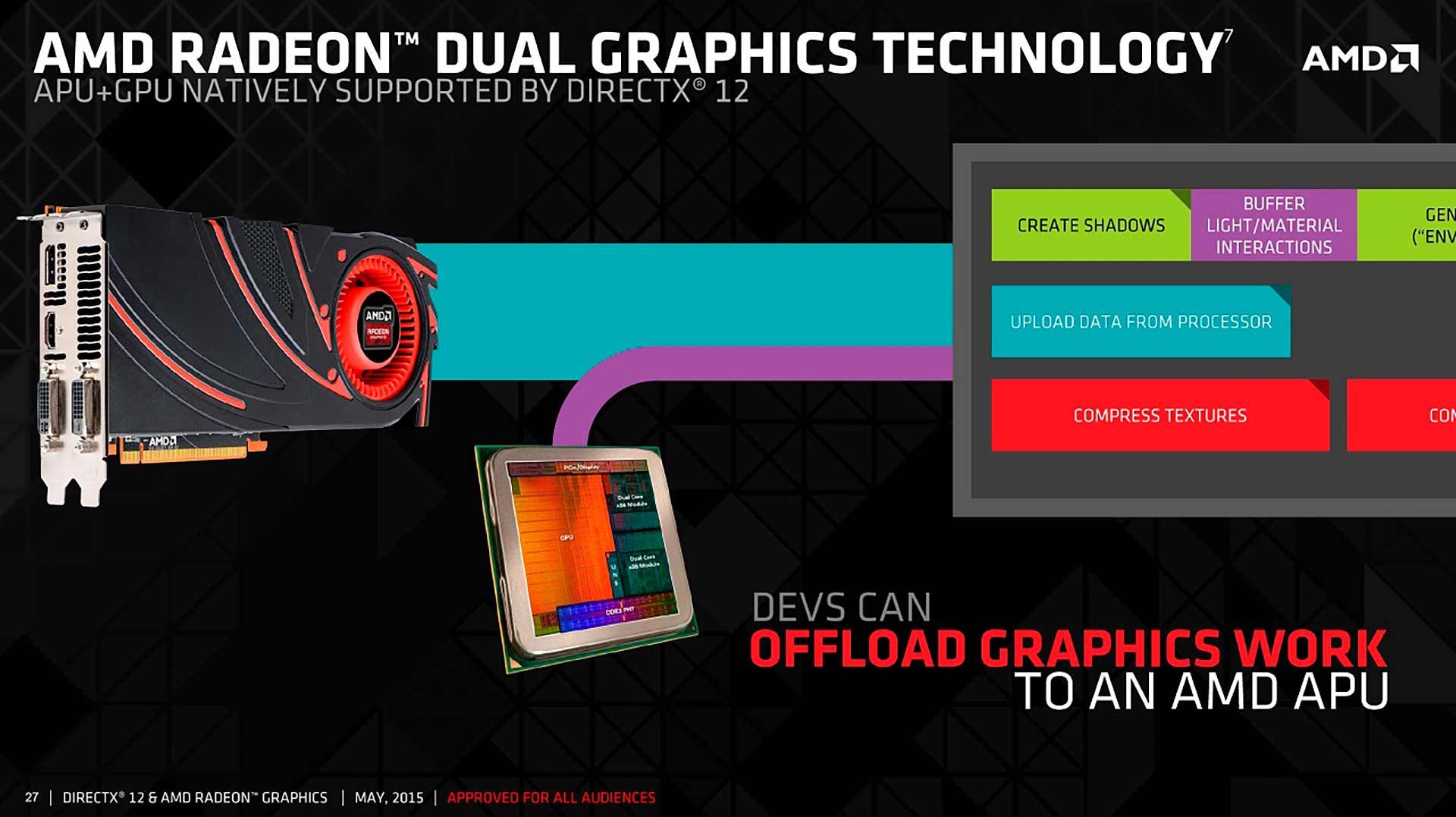

Интересный факт

У AMD была интересная технология Dual Graphics. Встроенное видеоядро в составе гибридных процессоров помогало полноценной видеокарте. Технология не взлетела не только из-за классических проблем, характерных для любых Multi-GPU связок, но и из-за серьёзных проблем по части софта. У AMD так и не получилось толково «подружить» встроенное ядро и полноценную карту.

Что такое Multi-GPU

Multi-GPU — это подход, когда в одной системе (или в связке из нескольких систем) работают две и больше видеокарты, а нагрузка распределяется между ними. Делают это не ради красоты, а чтобы получить больше общей производительности, распараллелить задачи или уместить более тяжёлые проекты в рамках одного узла.

Майнинг-риг — самый простой пример Multi-GPU системы

Зачем вообще ставят несколько GPU:

- Ускорить тяжёлые задачи, которые умеют распараллеливаться;

- Запускать больше процессов одновременно, раздав их по разным видеокартам;

- Получить больше суммарных ресурсов в одном сервере или рабочей станции;

- Повысить пропускную способность узла для профессиональных нагрузок.

На практике Multi-GPU бывает двух типов. Первый — одна задача на несколько видеокарт. Программа делит работу между GPU и собирает результаты. Второй — несколько задач на несколько видеокарт. Каждый GPU обслуживает свой процесс, проект или пользователя. Второй сценарий обычно проще и предсказуемее. Потому что не нужно заставлять видеокарты постоянно синхронизироваться между собой.

Важно понимать, что Multi-GPU не гарантирует прирост в два раза благодаря двум видеокартам. Часто масштабирование упирается в софт и инфраструктуру:

- Приложение может не уметь эффективно делить работу;

- Видеокарты тратят время на обмен данными и ожидание друг друга;

- Узким местом становится CPU, оперативная память, диск или Сеть;

- Питание, охлаждение и ограничения по PCIe уменьшают отдачу.

Где Multi-GPU реально живёт и приносит пользу? В профессиональных задачах, где поддержка заложена изначально (рендер, вычисления, некоторые пакеты для графики и инженерии). А также в сценариях, где нужно много параллельных процессов. А вот в играх классические схемы Multi-GPU практически исчезли — слишком мало поддержки и слишком много побочных эффектов.

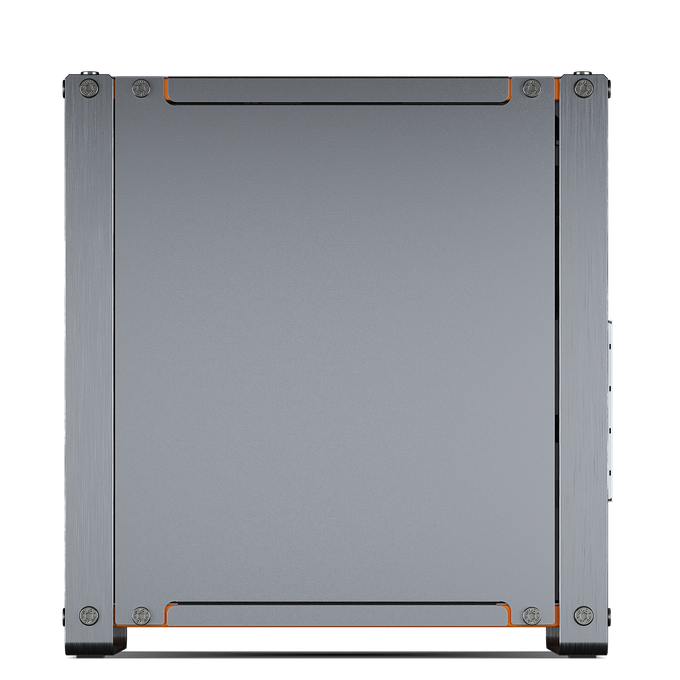

Рабочие станции DigitalRazor

Какие видеокарты поддерживают Multi-GPU

Связки из нескольких видеокарт делятся на два типа — для игр, и для всего остального. Далее мы плотно пройдёмся практически по каждому сценарию, но сперва расставим точки над «ё» в вопросе поддержки со стороны видеокарт.

В случае видеоигр перечень фактически пуст. Технически многие модели (преимущественно предыдущих поколений) могут работать сообща, но на практике только в старых играх, а в современных реалиях это не имеет никакого смысла… Ну, почти (смотреть раздел про Lossless Scaling).

В случае рабочих приложений и ИИ-нагрузок практически любые видеокарты могут работать вместе. И даже разные модели с разным количеством памяти. Но есть тонкость — синхронизация между GPU будет происходить либо через интерфейс PCI-E (медленно), либо через NVLink (быстро). Второй вариант сильно предпочтительнее, и чем больше видеокарт в одной системе, тем большее NVLink обеспечит преимущество.

| Сегмент | Видеокарты | NVLink | Что это даёт в реальности |

|---|---|---|---|

| Датацентры | A100, H100, H200 | Да, в том числе NVSwitch | Максимальный профит в кластерах и multi-GPU: высокая скорость GPU-GPU и масштабирование без упора в PCIe |

| Профессиональные карты Ampere | RTX A6000, RTX A5500, RTX A5000, RTX A4500 | Да | Обычно это сценарий 2х GPU с мостом: быстрый обмен, удобнее модельный параллелизм и меньше штрафов на коммуникации |

| Игровые RTX 3000 | GeForce RTX 3090, GeForce RTX 3090 Ti | Да | Это последние потребительские GeForce с NVLink. Дальше линейка ушла от моста. |

| Игровые RTX 4000 и 5000 | RTX 4090/4080/4070 и все RTX 5000 | Нет | Multi-GPU возможен только через PCIe, без NVLink-моста и без ускоренного меж-GPU канала NVLink |

| Профессиональные карты Ada и Blackwell | RTX 6000 Ada, RTX PRO 6000 Blackwell | Нет | У топовых профессиональных карт последних поколений NVLink-моста нет, поэтому для объединения задач остаются software-подходы и PCIe |

Важное уточнение: наличие NVLink вовсе не гарантирует, что программа будет суммировать видеопамять. В ML и рендере чаще работает распределение модели/сцены между GPU, а NVLink просто делает этот обмен заметно быстрее.

Multi-GPU в играх

Детальное знакомство с технологией стоит начать с использования в играх. Просто потому, что здесь особо нечего расписывать, и вся информация уместится в несколько абзацев. Кратко: в реалиях 2025 про эту технологию стоит забыть.

Почему перестало работать как идея:

- Игре нужно специально уметь делить рендер между GPU, а разработчикам это не нужно из-за малого процента пользователей с двумя картами;

- Классическая схема AFR, когда карты рисуют кадры по очереди, часто давала высокий средний FPS, но плохую ровность кадров и микрофризы;

- Современный рендер сложнее: много постобработки, динамики, стриминга ассетов и зависимостей между кадрами. Из-за этого видеокарты чаще ждут синхронизацию, чем работают;

- Драйверные профили и поддержка со стороны производителей почти перестали развиваться, поэтому новые не получают нормальный multi-GPU режим.

Где multi-GPU в играх ещё может иметь смысл:

- Старые проекты с готовыми профилями под SLI/CrossFire. Но зачем, если в старых играх FPS и так будет запредельный?

- Энтузиастские случаи, когда хочется экспериментировать, а не просто играть.

- Очень специфичные задачи вроде рендера, стриминга, записи или запуска нескольких игр и приложений параллельно, где каждая карта выполняет свою роль. Повторимся, очень специфические, поскольку настройка будет адом, и толково работать всё равно ничего не будет.

Если цель — больше FPS в современных играх, всегда выгоднее одна мощная видеокарта. Поэтому в наших лучших игровых ПК пару видеокарт не встретить.

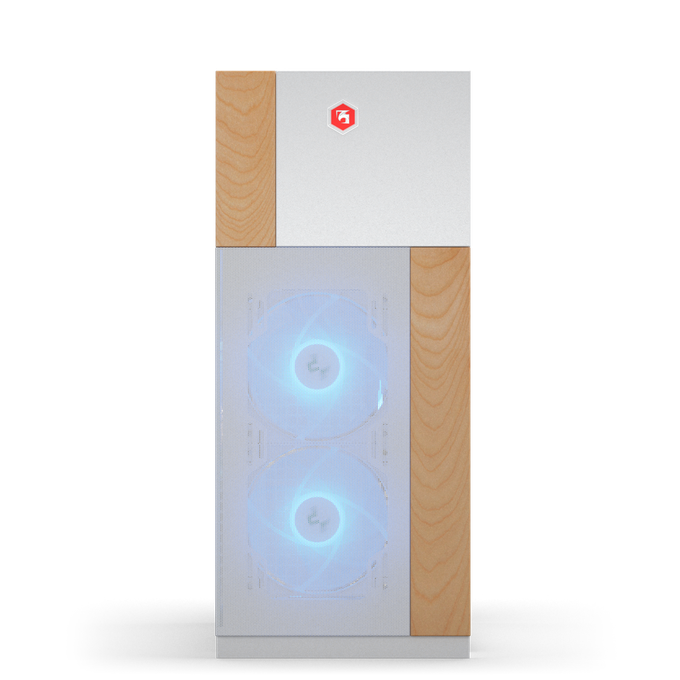

Топовые игровые ПК

Если цель — использовать две карты в одном ПК, то чаще это уже не про игры, а про параллельные задачи и профессиональные приложения. О них поговорим чуть позже.

Тема

Ожидание

Реальность в 2026

Итог для игрока

Поддержка со стороны игр

Игра умеет делить рендер между GPU

Почти никто не внедряет и не тестирует multi-gpu, потому что пользователей с двумя картами мало

В большинстве новых игр это просто не работает

Классическая схема AFR

Высокий прирост FPS за счёт рендеринга кадров по очереди

Средний FPS может расти, но появляются микрофризы и плохая ровность кадров

Плавность важнее цифр, ощущается хуже

Современный рендер

Кадры можно легко разделять между GPU

Много постобработки, стриминг ассетов, зависимости между кадрами, асинхронные этапы

Видеокарты чаще ждут синхронизацию, чем ускоряют

Драйверные профили

Вендор поддерживает профили под новые игры

Профили почти не развиваются, новые игры редко получают оптимальный режим

Даже если игра старая, без профиля толку мало

Масштабирование FPS

Почти линейный прирост от 2 GPU

Непредсказуемо: от нуля до проблем, зависит от конкретной игры

Рассчитывать на стабильный результат нельзя

Стабильность и отладка

Включил и забыл

Настройка, совместимость, баги, разный фреймтайм, нюансы с оверлеями и захватом

Больше времени на пляски, чем на игру

Где может иметь смысл

Везде, где нужен FPS

В основном в старых играх с профилями и в экспериментах энтузиастов

Скорее игрушка для хобби, чем решение

Старые игры с SLI/CrossFire

Красивый прирост в классике

FPS и так высокий, а профит не всегда ощущается

Сомнительная польза, разве что ради интереса

Специфичные сценарии

Ускорить всё сразу

Иногда можно разнести роли: игра на одной GPU, запись/стрим/рендер — на другой

Работает, но это уже не про ускорение игры

Лучший выбор под современные игры

Две карты лучше одной

Почти всегда выгоднее одна мощная видеокарта

Проще, стабильнее, предсказуемее

Multi-GPU и Lossless Scaling

Есть популярный финт с утилитой Lossless Scaling. Сперва напомним, что Lossless Scaling — это программа для Windows, которая масштабирует картинку игры до нужного разрешения. И может добавлять генерацию кадров поверх готового изображения, чтобы повысить плавность, даже если игра сама этого не поддерживает.

Хотя многие пользователи её восхваляют, на самом деле LS — штука очень неоднозначная. Мы в принципе не рекомендуем её использовать, если вам доступны проприетарные технологии производителей, вроде AMD FSR и NVIDIA DLSS. Если недоступны, не изобретайте велосипед, а лучше посмотрите на наши антикризисные ПК линейки Core:

Компьютеры DigitalRazor Core

Просто наивно думать, что программка за пару долларов сделает что-то лучше, чем штат разработчиков AMD и NVIDIA на зарплате.

Дело в том, что сам факт включения генератора немножко отъедает FPS, поскольку увеличивает загрузку графического процессора дополнительной задачей. Наглядно:

FPS

(больше — лучше)

Нетрудно заметить, что включение генерации дополнительного кадра увеличивает FPS не в 2 раза, а немного меньше. Теоретически FPS с 42 должен был увеличиться до 84, но фактически — только до 79. Сам факт включения генератора отъедает ~12% производительности. Далее уже не имеет значения, множитель кадров X2 или X4. На ~12% проседает базовый FPS.

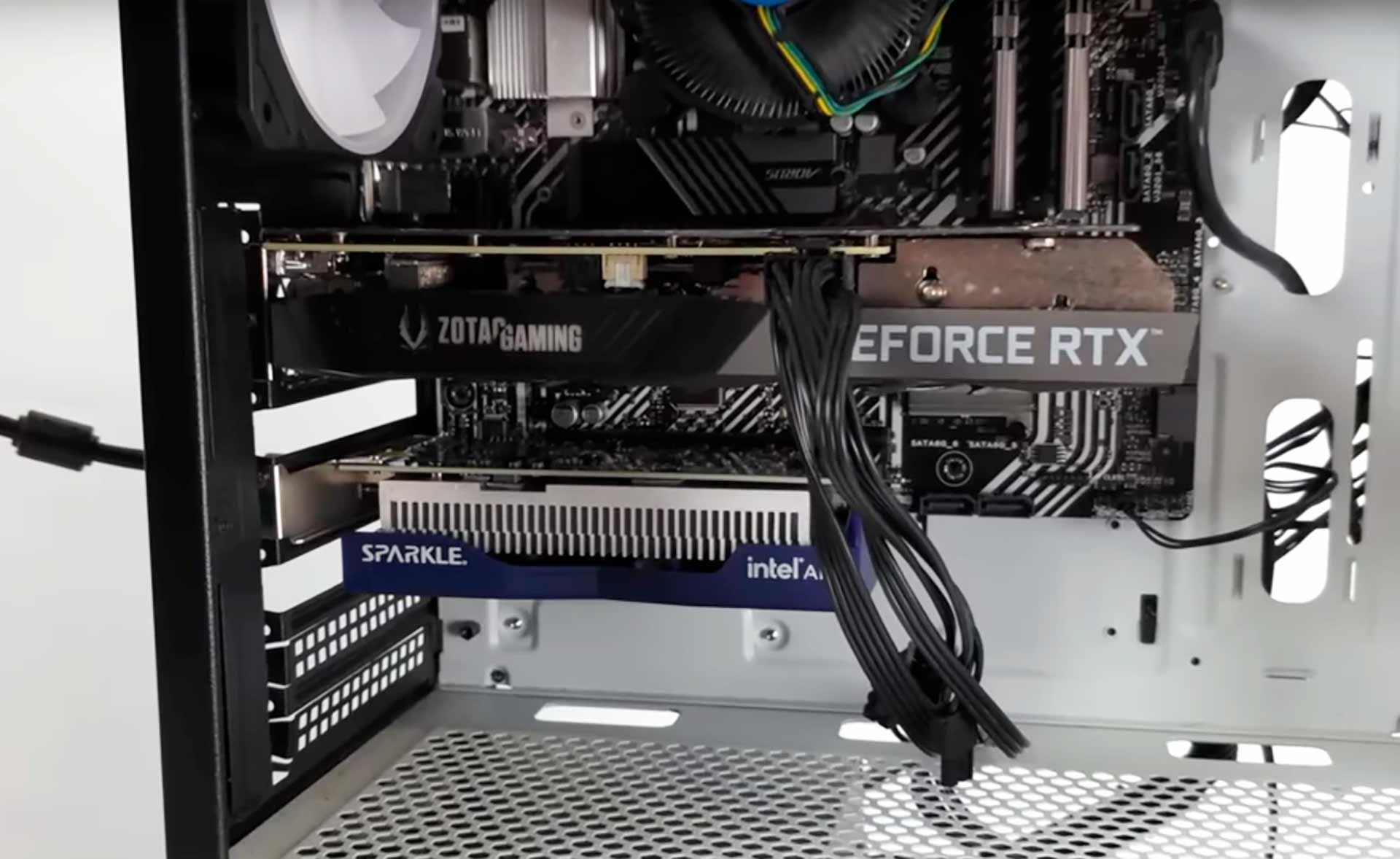

Суть метода с Lossless Scaling в генерации кадров и/или масштабировании изображения силами второго графического чипа. Основная видеокарта выдаёт «чистый» рендер без потери FPS, а дополнительная занимается генерацией/масштабированием. В качестве второй видеокарты можно использовать адаптер другой модели, от другого производителя, и даже встроенное в процессор видеоядро.

GeForce RTX для основного рендера и Intel Arc для генерации

Метод действительно рабочий, но имеет такое количество нюансов, что лучше так не делать. Он решает одну проблему (LSFG отъедает ресурсы у рендерящей GPU), но добавляет несколько новых узких мест и источников нестабильности. В итоге «профит» есть не всегда, а иногда становится хуже, чем если запустить игру на одной карте

Я у мамы инженер

Главный минус — копирование кадров между видеокартами. Чтобы второй GPU мог генерировать кадры, ему нужно получить изображение с первого. Это означает лишние пересылки данных по шинам и дополнительные задержки. Даже если средний FPS растёт, ощущение управления может стать менее живым, потому что добавляется ещё один этап в цепочке.

Дальше упор в вывод картинки. Идеальный сценарий для такого трюка обычно требует, чтобы монитор был подключён к тому GPU, который работает с LSFG и выводит финальный поток. Если монитор подключён к рендерящей карте, может понадобиться обратное копирование, и тогда вся задумка превращается в перегонку кадров туда-сюда с задержками и потерями в стабильности. На некоторых конфигурациях это не чуть хуже, а катастрофа.

Есть и системные ограничения, которые люди недооценивают:

- Пропускная способность PCIe и топология линий. Вторая карта на урезанном слоте или через чипсет часто становится бутылочным горлышком;

- Второй GPU должен успевать генерировать кадры под нужную герцовку и разрешение. Если он слабый, появляются рывки и просадки. Нестабильный FPS хуже, чем просто низкий;

- Дополнительная тепловая и энергопроблема: вторая карта греется, шумит, требует питания, место в корпусе, и может ухудшать температуры основной карты;

- Сложность настройки и повторяемости. То, что работает у одного, может вести себя иначе у другого. Из-за драйверов, версий Windows, режима дисплея, VRR, нескольких мониторов.

Отдельная боль — качество плавности. LSFG сам по себе зависит от ровного кадропотока. Когда появляется второй GPU и пересылки становится легче словить:

- Микрофризы из-за копирования и синхронизации;

- Нестабильный FPS при скачках нагрузки;

- Странности с VRR или захватом/оверлеями в отдельных играх.

По итогу dual-gpu в LSFG — это скорее режим для энтузиастов. Да, в некоторых сценариях он может дать профит. Но LSFG одной рукой даёт, а второй отбирает. И это мы ещё не задевали тему сложности настройки и подводных камней.

Multi-GPU в рабочих приложениях

В отличие от игр, в рабочих приложениях подход с несколькими видеокартами живёт и здравствует. Более того, часто это в принципе единственный способ увеличения производительности. Причина популярности и широкого распространения банальна: многие профессиональные задачи изначально хорошо масштабируются, поскольку разработчики софта позаботились об этом.

Если геймеры связки из нескольких карт используют редко, и это просто слишком маленькая аудитория, то multi-GPU в «рабочках» очень популярны. Разработчикам соответствующих приложений есть смысл заморачиваться над параллелизмом. Поэтому в наших рабочих станциях среднего и выше уровня как минимум две видеокарты. Это золотой стандарт.

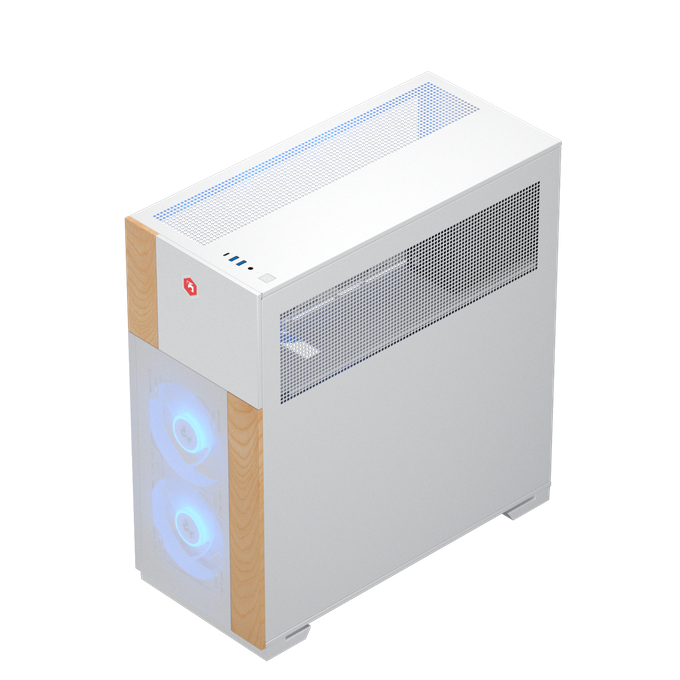

Рабочие станции Multi-GPU

Некоторые рабочие приложения умеют просто превосходно «разбивать» задачу на несколько потоков. Две видеокарты обеспечивают практически двукратный прирост быстродействия (часто 199%). Четыре — почти четырёхкратный (~395%). Таким могут похвастаться OctaneBench и V-ray. Но здесь всё сильно зависит от конкретного приложения и сценария использования, поскольку далеко не все операции выполняются силами GPU. Например, DaVinci Resolve и RedShift получают меньше прироста когда видеокарт больше трёх.

Blender

В Blender Multi-GPU — это в первую очередь про Cycles (рендер). Несколько видеокарт действительно могут ускорять финальный рендер, потому что задача хорошо параллелится: изображение делится на части, и каждый GPU считает свою порцию. В классическом описании Cycles это деление идёт по тайлам (плиткам): больше GPU = больше тайлов в обработке одновременно.

%

(больше — лучше)

В Blender прирост от нескольких видеокарт чаще всего близок к почти линейному, если рассматривать типичную картину для Cycles (финальный рендер кадра, без экзотики). Но есть крайне важный стоп-фактор — видеопамять.

В Blender, как и в большинстве других рабочих приложений, видеопамять не суммируется. В память каждой карты помещается копия данных. Пара RTX 5090 — это 2х 32 ГБ, а не 64 ГБ. Если сцена не помещается в память одной карты, multi-GPU может вообще стать бессмысленным.

Если задача — ускорить Cycles-рендер, multi-GPU обычно даёт понятный прирост, пока сцена влезает в VRAM каждой карты и нет упора во вторичные системы. Если цель — ускорить Blender целиком, то второй GPU чаще помогает только косвенно (например, разделением задач по процессам/кадрам), но не ускоряет всё магически.

В общем, для Cycles — хорошо, для всего остального смысла мало.

DaVinci Resolve

Multi-GPU в DaVinci Resolve реально работает и часто даёт заметный прирост, но не во всех задачах одинаково. В целом, чем больше в проекте тяжёлых GPU-эффектов и чем выше разрешение, тем больше смысла во второй видеокарте.

%

(больше — лучше)

Максимальный профит обычно получается в задачах вроде:

- Fusion-композитинг (сложные нодовые композиции);

- Color с тяжёлыми OFX и особенно шумодавом (вроде Temporal NR);

- Проекты с большим количеством эффектов и слоёв при высоком разрешении.

Если монтаж простой и эффектов мало, прирост может быть слабым: узким местом становятся декодирование, диски и кэш. При финальном экспорте всё зависит от кодека. Если/когда упор идёт в аппаратный энкодер (NVENC/AMF), вторая видеокарта не делает рендер в два раза быстрее.

Adobe Photoshop

В Photoshop multi-GPU почти не даёт выгоды. Во-первых, программа в принципе работает на процессоре. Да, часть процессов выполняется на видеокарте, но распределять одну и ту же задачу на две карты Photoshop не умеет. Кроме того, это просто не нужно — Photoshop любит процессоры.

%

(больше — лучше)

GPU в Photoshop нужен для вещей вроде плавного зума и вращения холста, некоторых фильтров и эффектов (например, размытия, трансформаций, части Neural Filters), а также для ускорения отображения слоёв и превью. Но даже здесь узким местом часто становится не видеокарта, а CPU, оперативная память и скорость диска.

Вторая видеокарта может иметь смысл только косвенно: если на одном GPU работает другой софт (3D, рендер, видео), а Photoshop работает параллельно и хочется раскидать нагрузку по разным приложениям. Для чистого Photoshop обычно разумнее вложиться в одну нормальную видеокарту, дополнительную память или SSD.

Adobe After Effects

В After Effects multi-GPU не даёт прироста. Программа в основном упирается в CPU и память, а GPU использует точечно, поэтому одной карты хватит с головой.

%

(больше — лучше)

GPU ускоряет часть эффектов и обработок (включая некоторые встроенные, а также плагины), помогает с предпросмотром и рендером в проектах, где цепочка эффектов GPU-ускоренная. Но распределять одну композицию на две видеокарты программа не может.

Как и в случае с Photoshop, вторая карта полезна скорее косвенно: если идёт параллельная работа в AE и других приложениях (к примеру, Premiere/Media Encoder/3D), либо одновременный рендер в разных процессах. Тогда нагрузку можно развести, и система будет отзывчивее.

Для After Effects намного лучше приобрести быстрый процессор и больше памяти, чем вторую видеокарту.

Adobe Premiere Pro

В Adobe Premiere Pro multi-GPU редко даёт линейный прирост и обычно не является главным апгрейдом. В большинстве сценариев Premiere использует одну видеокарту для ускорения эффектов и обработки. А производительность часто упирается в кодеки, CPU, память и диски.

GPU важен для Mercury Playback Engine: воспроизведение таймлайна, рендер эффектов/переходов, цветокора, масштабирования. Чем больше тяжёлых эффектов и слоёв, чем выше разрешение и HDR, тем заметнее вклад видеокарты.

V-Ray

Продукция компании Adobe могла подпортить впечатления о мультиграфических системах, но V-Ray и последующие инструменты всё исправят.

Multi-GPU для V-Ray — отличное дополнение. V-Ray умеет эффективно задействовать несколько видеокарт и обычно масштабируется близко к линейному приросту, особенно если карты одного поколения и равны по производительности.

%

(больше — лучше)

Главное ограничение — видеопамять. При рендере сцена копируется на каждую видеокарту, поэтому лимит по VRAM задаёт самая «малопамятная» карта в системе. Условно: если одна карта на 24 ГБ, а вторая на 16 ГБ, то ориентироваться нужно на 16 ГБ. Группа туристов идёт со скоростью самого медленного, а не самого быстрого участника похода.

При этом есть важная оговорка: V-Ray может выполнять объединение памяти через интерфейс NVLink, если у пары GPU есть поддержка этой технологии и установлен мост. Тогда две карты по 24 ГБ позволят работать со сценами, которым нужно около 48 ГБ.

Практические выводы по сборке:

- Самый предсказуемый профит дают одинаковые GPU с одинаковым объёмом VRAM;

- SLI для V-Ray не нужен и даже может мешать, потому что V-Ray использует карты как вычислители, а не как игровую связку;

- Для многокарточных систем разработчики рекомендуют иметь хотя бы 6 физических CPU-ядер на один GPU и по возможности платформу с PCIe 4.0+, чтобы кормить видеокарты данными без лишних узких мест.

RedShift

Multi-GPU в Redshift работает хорошо и часто даёт почти линейный прирост, потому что рендер изначально рассчитан на параллельную работу нескольких видеокарт. На практике добавление второго аналогичного GPU обычно заметно ускоряет финальный рендер и интерактивный рендеринг в реальном времени. На 3–4 GPU прирост всё ещё большой, но уже с небольшими потерями на накладные расходы.

%

(больше — лучше)

Самый важный ограничитель в Redshift — видеопамять. Как правило, сцена должна помещаться в VRAM каждой карты, и лимит задаёт GPU с наименьшим объёмом памяти. При смешивании карт по объёму VRAM и производительности результат становится менее предсказуемым, поэтому оптимальный вариант — одинаковые GPU.

Отдельный плюс Redshift — он рассчитан на работу с большими сценами и умеет использовать out-of-core (часть данных уходит в оперативную память). Но это скорее спасательный круг, чем способ нормально масштабироваться. Скорость ощутимо падает, поэтому всё равно выгоднее держать сцену внутри VRAM.

Практический вывод: multi-GPU в Redshift имеет смысл почти всегда, если вы упираетесь именно в рендер-время, а сцены не выходят за объём VRAM. Если же основная боль — память, иногда выгоднее одна карта с большим VRAM, чем две поменьше.

| Приложение | Польза от multi-gpu | Где будет самый заметный профит | Главные ограничения и нюансы |

|---|---|---|---|

| Blender | Высокая в Cycles, низкая в остальном | Cycles финальный рендер и IPR, запекание через Cycles | VRAM обычно не суммируется, сцена должна влезать в память каждой карты. Eevee и вьюпорт чаще опираются на один GPU |

| DaVinci Resolve | Средняя–высокая, но зависит от проекта | Fusion, тяжёлые OFX, шумодав, 4K–8K таймлайны | Экспорт часто упирается в кодек/энкодер, диски и кэш. Разный класс GPU может дать слабый эффект |

| Adobe Photoshop | Почти нет | Косвенно, если параллельно работает другое тяжёлое GPU-зависимое приложение | Photoshop в основном рассчитан на один GPU. Чаще выгоднее память и быстрый SSD под скрэтчи |

| Adobe After Effects | Низкая, чаще косвенная | Параллельный пайплайн с Premiere/Media Encoder, разные процессы/задачи | AE часто упирается в CPU, RAM и кэш. Одна композиция не масштабируется на два GPU |

| Adobe Premiere Pro | Низкая–средняя, чаще косвенная | Тяжёлые эффекты и цвет, высокая нагрузка на таймлайн, параллельно с Media Encoder | Во многих проектах потолок это декод/энкод и CPU. Второй GPU редко даёт кратное ускорение экспорта |

| V-Ray | Высокая | GPU-рендер, особенно при длительных просчётах и сериях кадров | VRAM обычно не суммируется и лимит задаёт младшая карта. Лучше одинаковые GPU по VRAM и классу |

| Redshift | Высокая | Финальный рендер и IPR при сценах, которые влезают в VRAM | Ключевой лимит VRAM на карту. Out-of-core спасает, но заметно режет скорость. Микс GPU менее предсказуем |

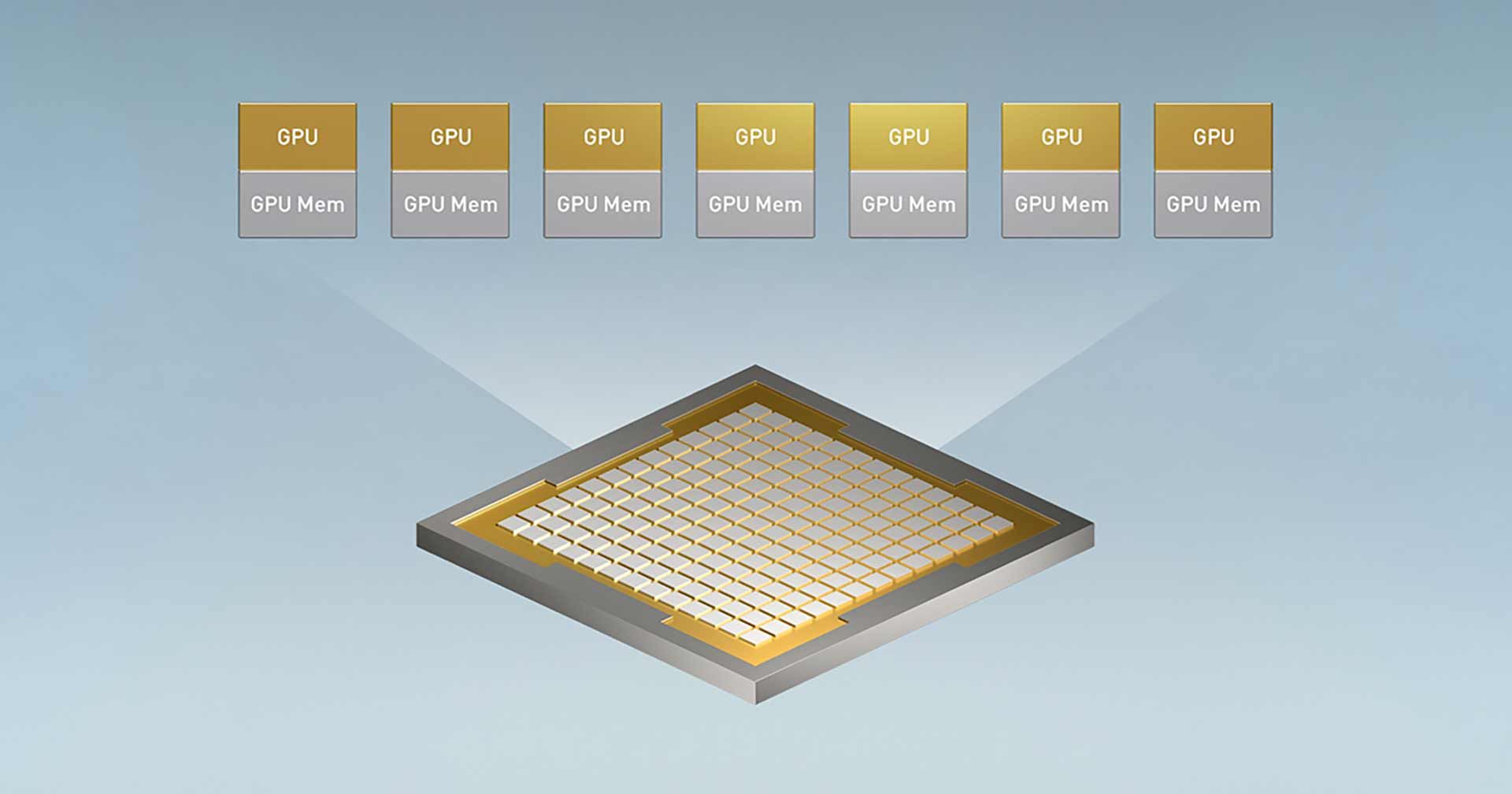

Multi-GPU в сфере ИИ

Multi-GPU в ИИ-вычислениях — это когда две и больше видеокарт используют как единый вычислительный ресурс: либо чтобы ускорить расчёты, либо чтобы уместить модель, которая не помещается в память одной карты. В отличие от игр, здесь масштабирование реально работает, потому что фреймворки и библиотеки изначально проектировали под параллельные вычисления.

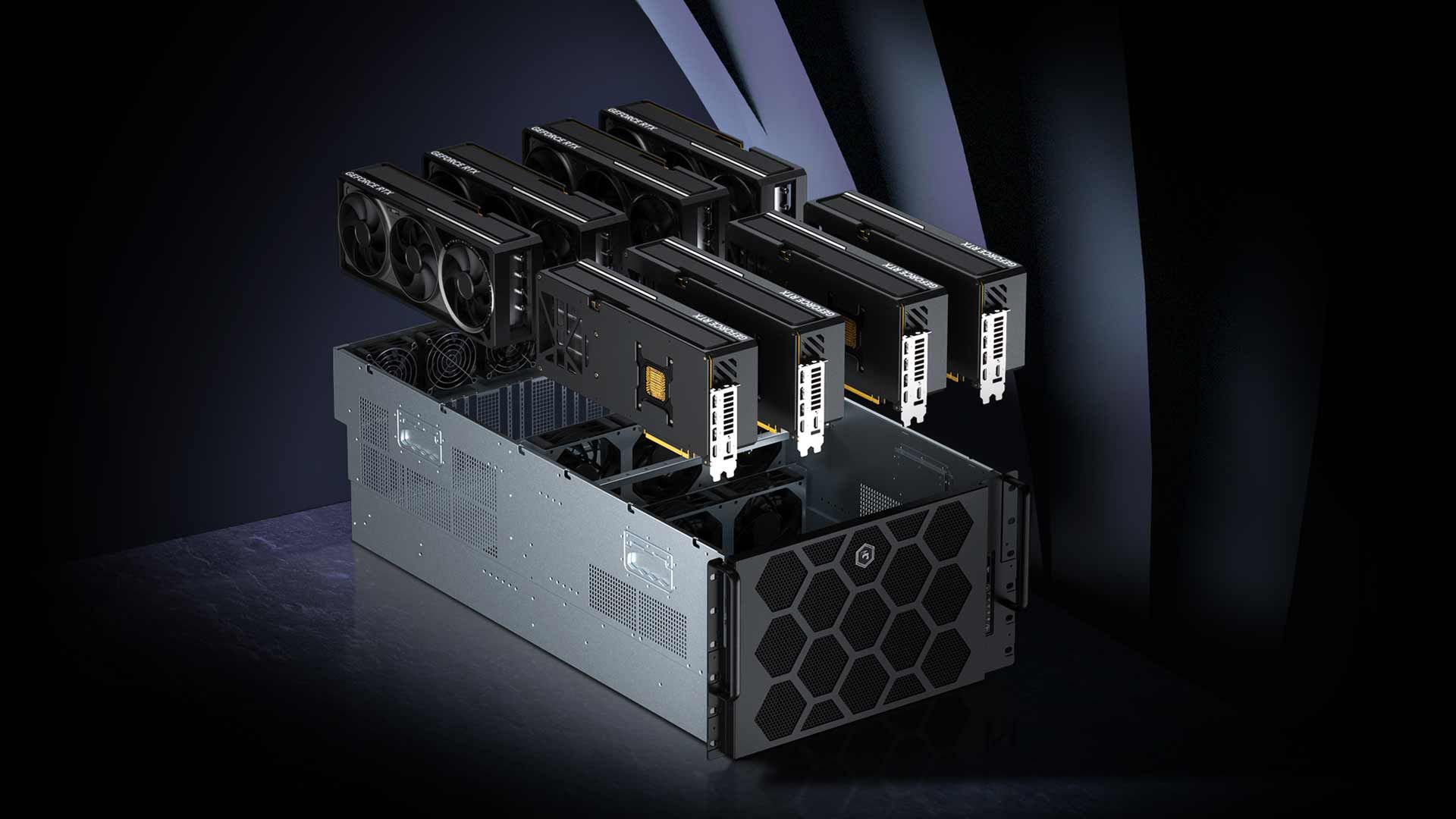

Фактически использование нескольких видеокарт — обязательное условие для ИИ-проектов среднего уровня и выше. Более того, часто речь идёт даже не про один сервер с несколькими видеокартами, вроде наших линеек Scale и HPC, а про целый кластер из нескольких серверов по 6-8 адаптеров в каждом. Возможности для масштабирования здесь практически бесконечные.

Два основных сценария

Первый — увеличить скорость. Одну задачу распределяют по нескольким GPU, чтобы получить большую вычислительную мощностью и большую пропускную способность памяти. Это особенно заметно при обучении, где много матричной математики. На практике прирост близок к линейному только до тех пор, пока обмен данными между GPU не начинает съедать время. Чем чаще нужно синхронизировать градиенты и параметры, тем сильнее роль межсоединений и сети.

%

(больше — лучше)

Поэтому важна не только «сырая» вычислительная мощность и количество видеокарт, но и правильная сборка и «платформа» — материнская плата, Сеть, хранилище данных и т. д. В наших GPU-серверах всё это учтено. Детальнее об этом мы рассказывали в этой статье.

ИИ-серверы

Второй — увеличить вместимость по памяти. Если модель, контекст, батч или кэш не помещаются в VRAM одной карты, её разбивают на части и размещают на нескольких GPU. Это не всегда ускоряет процесс, а иногда даже замедляет, но делает задачу в принципе возможной. В этом режиме важно не только количество GPU, но и то, как быстро они могут обмениваться тензорами. Здесь очень важная платформа и «обвязка» видеокарт.

Как именно распределяют нагрузку :

- Data parallelism: каждый GPU считает свою часть батча, затем идёт синхронизация градиентов;

- Model parallelism: разные слои/части модели работают на разных GPU;

- Pipeline parallelism: разные стадии обучения модели выполняются на разных GPU по конвейеру;

- Tensor parallelism: крупные матричные операции делятся между GPU внутри одного слоя.

ГРАФИК ПАДЕНИЯ СКОРОСТИ, ЕСЛИ НЕ ВЛАЗИМ В ПАМЯТЬ

Почему межсоединения решают

Если GPU общаются медленно, они просто ждут друг друга. Поэтому в серьёзных системах критичны:

- Быстрые соединения между GPU. Например, NVLink/NVSwitch в некоторых платформах);

- Достаточная пропускная способность PCIe. Если нет поддержки NVLink;

- Быстрая Сеть. Иначе масштабирование на несколько серверов резко деградирует.

Где чаще всего ломается эффективность:

- Слишком маленький батч. Вычислений мало, синхронизации много;

- Узкое место в данных. Медленный даталоадер, диск или Сеть, и GPU простаивают;

- Нехватка VRAM. Из-за чего начинается выгрузка в RAM/на диск;

- Смешанные GPU. Разные скорости и разный объём памяти усложняют балансировку.

Multi-GPU для ИИ — это либо способ быстрее посчитать, либо способ влезть в память в принципе. В идеале нужен баланс: достаточное число GPU, чтобы модель помещалась и масштабировалась, и достаточно быстрая инфраструктура вокруг, чтобы эти GPU не простаивали.

«Обратный» Multi-GPU

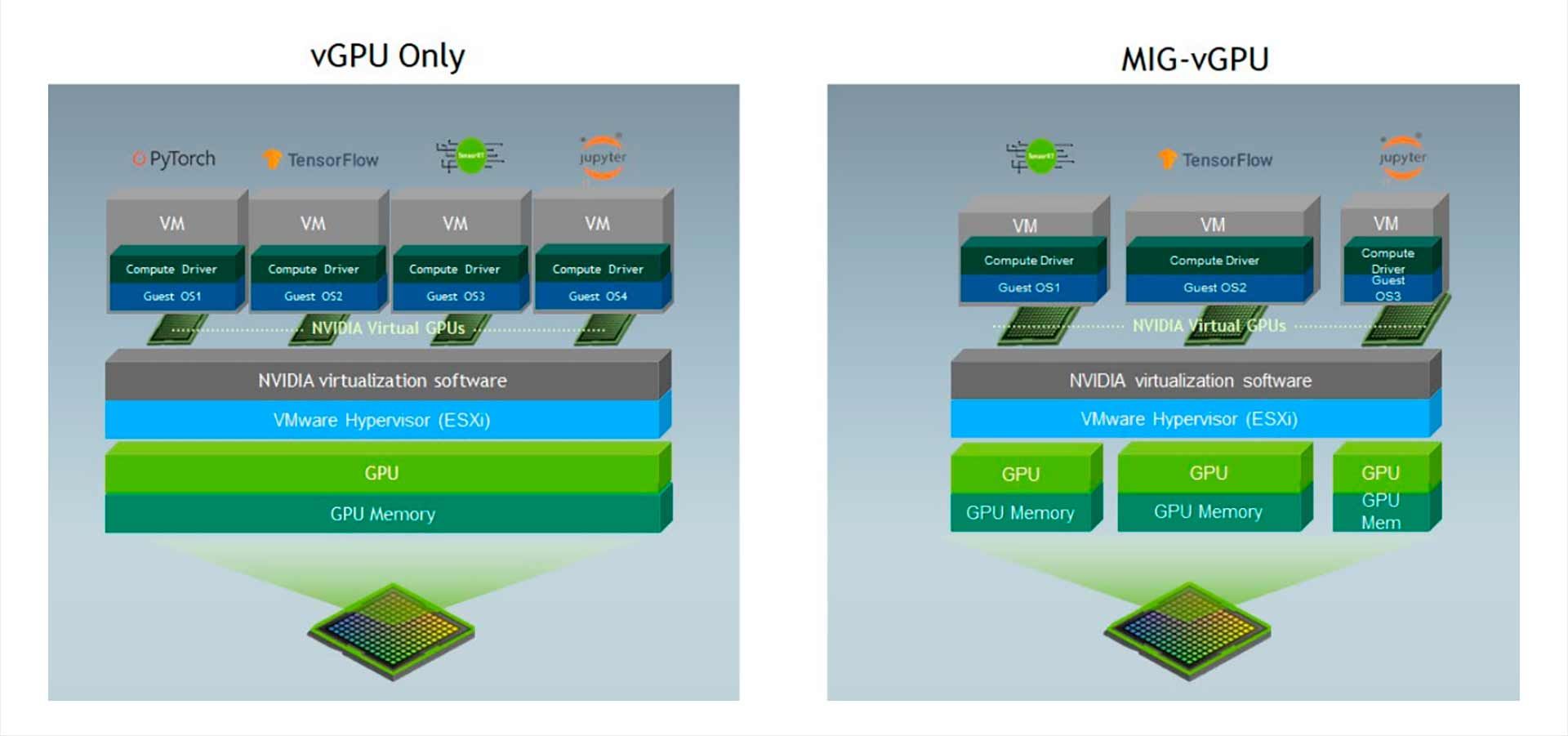

Говоря об использования нескольких видеокарт вскользь заденем ещё одну тему — MIG и vGPU. Чисто технически эти технологии являются обратным Multi-GPU или его антонимом. У технологий похожий фундамент — деление одной физической видеокарты на несколько виртуальных. Такой финт можно масштабировать и на несколько карт.

MIG

MIG (Multi-Instance GPU) — это технология NVIDIA, которая позволяет «нарезать» один физический ускоритель на несколько независимых виртуальных GPU. Чтобы параллельно запускать разные задачи (или обеспечивать работу разных пользователей) и не простаивать впустую.

Важно, что это не просто софтверное деление по времени. Инстансы (частички GPU) изолированы и получают свои выделенные части вычислительных блоков и памяти с предсказуемой задержкой и пропускной способностью.

Технология особенно полезна, если одна сильная карта должна обеспечивать несколько сотрудников рабочими местами. Вместо покупки нескольких средних компьютеров достаточно одного сильного сервера. Если его мощностей или памяти недостаточно, добавление второй карты увеличивает доступные ресурсы.

Официально поддержка MIG начинается с архитектуры Ampere. Список включает ускорители A100, A30, H100/H200, B200/GB200, а также RTX PRO 5000/6000 Blackwell (в т. ч. Server/Workstation Edition).

vGPU

vGPU (virtual GPU) — собрат MIG. Практически всё тоже самое, но есть ключевое отличие «под капотом» — механизм разделения видеокарты. MIG жёстко делит видеокарту — чуть ли не на аппаратном уровне. А vGPU — это уровень попроще, реализация на уровне софта. Зачастую технологию используют для организации удалённых рабочих мест.

Перечень поддерживаемых видеокарт почти такой же, как и у MIG — некоторые профессиональные видеокарты и специализированные решения для дата-центров.

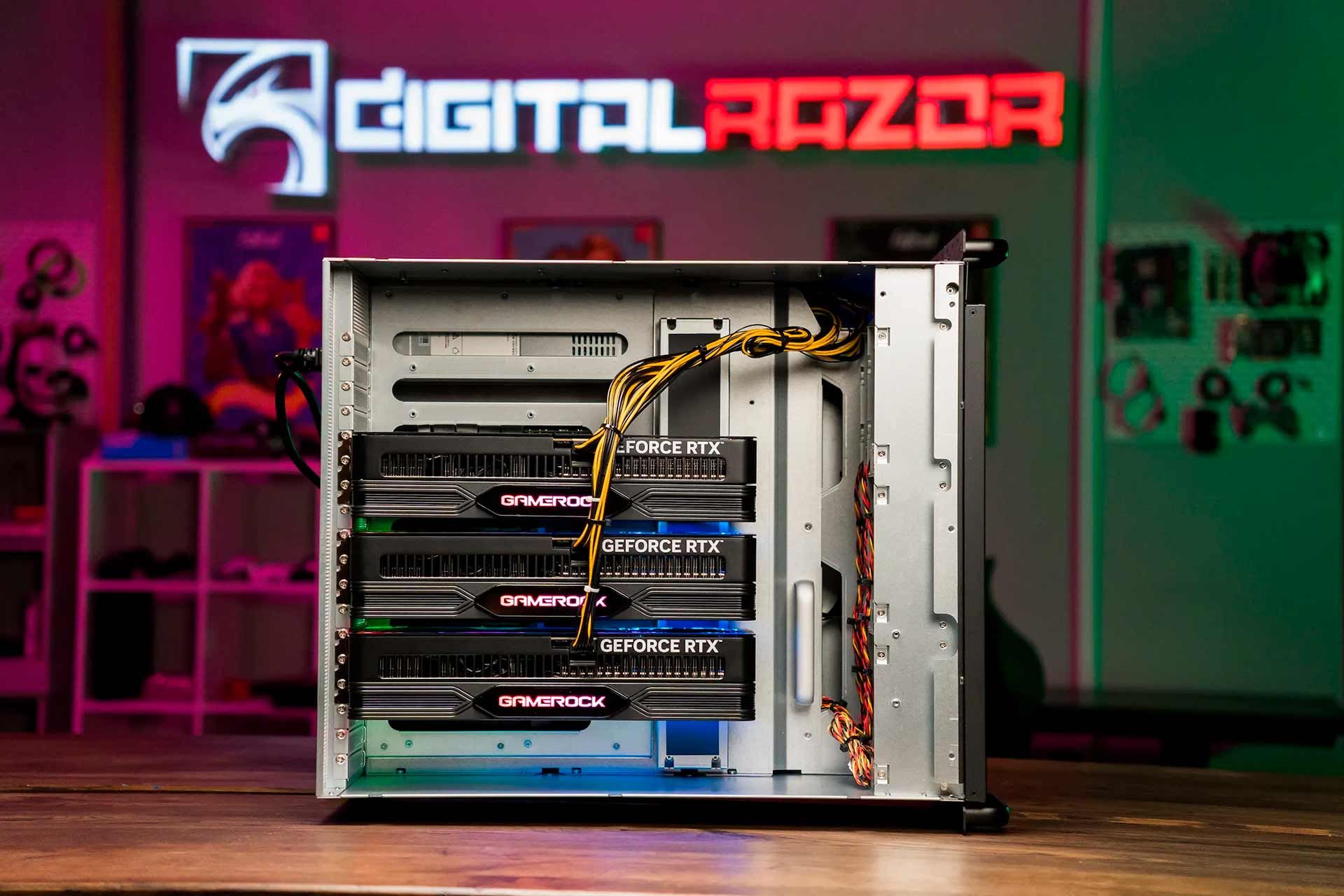

Проблемы и сложности Multi-GPU

Видеокарта — самый прожорливый и теплонагруженный компонент системы. Вторую, третью, восьмую карту добавляют тогда, когда одна не справляется, что автоматически подразумевает максимально возможную нагрузку. Следовательно, требования к питанию, охлаждению, качеству сборки растут в геометрической прогрессии с каждой дополнительной картой.

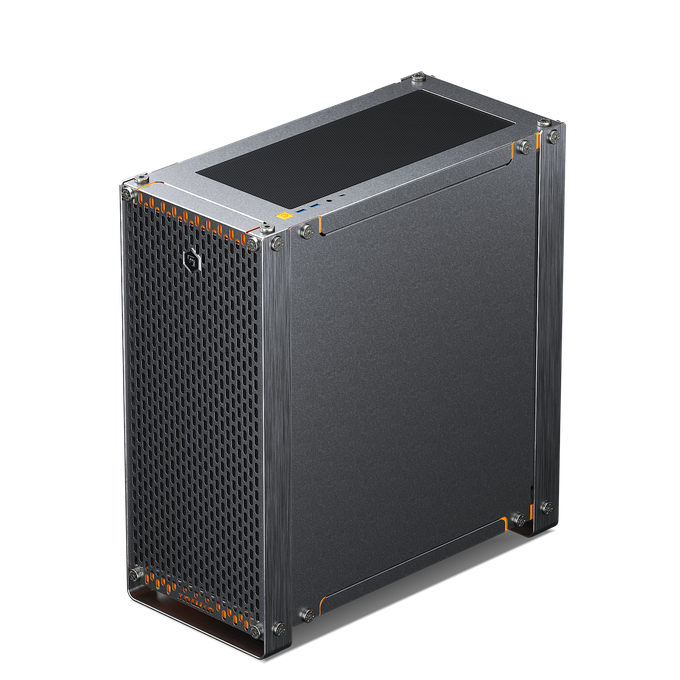

DigitalRazor Devbox AI

DigitalRazor HPC8000

В наших познавательных статьях мы много рассказываем о нюансах самостоятельной сборки игровых ПК и даже рабочих станций начального уровня. Но станция с несколькими картами, не говоря уже про GPU-сервер — это совершенно другой уровень. Как говорится, не лезь, она тебя сожрёт.

Аппаратные проблемы. Сложности с Multi-GPU почти всегда сводятся к четырём вещам: питание, охлаждение, PCIe-топология и физическая компоновка.

С питанием главная ловушка не в TDP, а в пиках потребления. Две мощные карты могут одновременно дёрнуть нагрузку, и если БП, проводка и разводка по линиям сделаны без запаса, случатся ребуты, ошибки драйвера или отвал одного из GPU под нагрузкой.

Охлаждение в multi-GPU сложнее. Потому что карты греют друг друга. Поэтому в плотных сборках обычно нужны либо турбинные кулеры, либо серверные пассивные карты под сильный фронтальный поток, либо жидкостные системы.

PCIe становится узким местом по линиям и по топологии. Важно, сколько линий даёт платформа, и как слоты привязаны к CPU (особенно в двухсокетных системах). PCIe-свитчи помогают размножить слоты, но не создают дополнительную пропускную способность и добавляют задержку, что критично для задач с активным обменом данных между GPU.

Наконец, механика. Современные карты огромные и тяжёлые. Нужны правильные расстояния между слотами, место под кабели питания, жёсткое крепление. Иначе проблемы будут не теоретические, а в виде перегрева, плохого контакта и нестабильности.

Мы предлагаем широкий ассортимент GPU-серверов с 2–8 видеокартами, а также рабочие станции с 1–4 GPU. Надёжные системы для тяжёлых вычислений оптимизированные для обучения нейросетей, анализа больших данных, 3D‑рендеринга и других ресурсоёмких задач. Multi-GPU — именно тот сегмент рынка, где стоит обратиться к профессионалам.

ИИ-серверы

Итоги

Multi-GPU в 2026 году — это не волшебная кнопка, а инструмент под конкретные задачи. В играх он почти умер вместе со SLI и драйверными профилями: слишком много побочных эффектов, слишком мало поддержки и слишком непредсказуемый результат.

Зато в рабочих сценариях всё наоборот. Там, где нагрузка хорошо параллелится (рендер в Cycles/V-Ray/Redshift, тяжёлые узлы в Resolve, пакетные просчёты и вычисления), добавление второй и третьей видеокарты даст честное ускорение и ощутимую экономию времени, денег и нервов.

Ключевой вывод простой: multi-GPU работает изумительно, когда совпали три вещи — подходящий софт, сцены/проекты, которые влезают в VRAM каждой карты, и правильная платформа (питание, охлаждение, PCIe-топология). Поэтому если задача требует нескольких ускорителей, логичнее сразу смотреть в сторону рабочих станций и GPU-серверов, которые рассчитаны на такую компоновку, а не пытаться собрать «многоголовую» систему дома на коленке.

В наших линейках рабочих станций и GPU-серверов как раз есть конфигурации на 2–8 видеокарт под рендер, монтаж и ИИ-задачи, где прирост получается не на бумаге, а в реальных часах, которые вы перестаёте тратить на ожидание.